- 投稿日:2020-02-18T23:58:50+09:00

COTOHAを使って「タイポグリセミア」文章を作成する

この きじ の がよいう を せめつい するよ

いきなりですが、以下の文章をざっと読んでみてください。

こんちには みさなん おんげき ですか? わしたは げんき です。

この ぶんょしう は いりぎす の ケブンッリジ だがいく の けゅきんう の けっか

にげんんは たごんを にしんき する ときにその さしいょ と さいご の もさじえ あいてっれば

じばんゅん は めくちちゃゃ でも ちんゃと よめる という けゅきんう に もづいとて

わざと もじの じんばゅん を いかれえて あまりす。

どでうす? ちんゃと よゃちめう でしょ?どうですか?意外とすんなり読めるのではないでしょうか。

この文章は(個人的には)割と有名なコピペで、正式名称をタイポグリセミアというらしいです。カラクリをざっくりと説明すると、人間は単語を認識する際に1文字ごとに理解するのではなく文字の集合として視覚的に認識しています。その際に、脳内で単語を瞬時に理解・予測しているため、単語を構成する文字が多少入れ替わっても補正されて読むことができるそうなのです。

※これらの補正は個人の知識やボキャブラリーに依存するため、個人差があります。今回はCOTOHA APIで提供されている構文解析APIを使って、入力された文章を解析してタイポグリセミア文章として出力します。

こんな かじんで しつゅりょく さるれよ

before : PythonとCOTOHAを使用して出力されたタイポグリセミア文章をQiitaに投稿 after : pothyn と choota を しよう し て しょつりゅく さ れ た たぽせいみりぐあ ぶしょんう を qiita に とこううなんともそれっぽい結果に!!

CHOOTA って いたっい どんな API なだんい?

COTOHAとはNTTコミュニケーションズが提供する自然言語処理・音声処理APIプラットフォームです。

今回の記事で紹介する構文解析以外にも固有表現抽出・照応解析・キーワード抽出・類似度算出・文タイプ判定・ユーザ属性推定・感情分析・要約などなど様々な機能が用意されています。ユーザ登録も簡単で、無料枠内でも各APIを1000コール/日使用できるため、軽く遊びで動かしてみることも可能です。

今ならQiitaとコラボしてこんな企画をやっているので是非是非参加してみてください!!ユーザの無料登録はCOTOHA API Portalからできます。

いくつかの基本項目を入力すると、APIを利用するためのユーザIDとシークレットが発行されるので、もし以降のスクリプトをお手元で試したい場合は控えておいてください。Pothyn を つっかて じそっう するよ

以下の記事を参考にさせていただきました。

どちらの記事も非常に分かりやすくまとまっているので非常にオススメです!ベースは上の記事を参考にしていますが、APIのエンドポイント部分をちょっとだけいじってあります。

元はBASE_URLにnlpまで含めてありましたが、COTOHA公式のフォーマットに合わせて省いています。

メインプログラム

cotoha_api.pyimport os import urllib.request import json import configparser import codecs import re import jaconv import random # COTOHA API操作用クラス class CotohaApi: # 初期化 def __init__(self, client_id, client_secret, developer_api_base_url, access_token_publish_url): self.client_id = client_id self.client_secret = client_secret self.developer_api_base_url = developer_api_base_url self.access_token_publish_url = access_token_publish_url self.getAccessToken() # アクセストークン取得 def getAccessToken(self): # アクセストークン取得URL指定 url = self.access_token_publish_url # ヘッダ指定 headers={ "Content-Type": "application/json;charset=UTF-8" } # リクエストボディ指定 data = { "grantType": "client_credentials", "clientId": self.client_id, "clientSecret": self.client_secret } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 res = urllib.request.urlopen(req) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディからアクセストークンを取得 self.access_token = res_body["access_token"] # 構文解析API def parse(self, sentence): # 構文解析API URL指定 url = self.developer_api_base_url + "nlp/v1/parse" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "sentence": sentence } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # 固有表現抽出API def ne(self, sentence): # 固有表現抽出API URL指定 url = self.developer_api_base_url + "nlp/v1/ne" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "sentence": sentence } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # 照応解析API def coreference(self, document): # 照応解析API 取得URL指定 url = self.developer_api_base_url + "beta/coreference" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "document": document } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # キーワード抽出API def keyword(self, document): # キーワード抽出API URL指定 url = self.developer_api_base_url + "nlp/v1/keyword" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "document": document } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # 類似度算出API def similarity(self, s1, s2): # 類似度算出API URL指定 url = self.developer_api_base_url + "nlp/v1/similarity" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "s1": s1, "s2": s2 } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # 文タイプ判定API def sentenceType(self, sentence): # 文タイプ判定API URL指定 url = self.developer_api_base_url + "nlp/v1/sentence_type" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "sentence": sentence } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body # ユーザ属性推定API def userAttribute(self, document): # ユーザ属性推定API URL指定 url = self.developer_api_base_url + "beta/user_attribute" # ヘッダ指定 headers={ "Authorization": "Bearer " + self.access_token, "Content-Type": "application/json;charset=UTF-8", } # リクエストボディ指定 data = { "document": document } # リクエストボディ指定をJSONにエンコード data = json.dumps(data).encode() # リクエスト生成 req = urllib.request.Request(url, data, headers) # リクエストを送信し、レスポンスを受信 try: res = urllib.request.urlopen(req) # リクエストでエラーが発生した場合の処理 except urllib.request.HTTPError as e: # ステータスコードが401 Unauthorizedならアクセストークンを取得し直して再リクエスト if e.code == 401: print ("get access token") self.access_token = getAccessToken(self.client_id, self.client_secret) headers["Authorization"] = "Bearer " + self.access_token req = urllib.request.Request(url, data, headers) res = urllib.request.urlopen(req) # 401以外のエラーなら原因を表示 else: print ("<Error> " + e.reason) # レスポンスボディ取得 res_body = res.read() # レスポンスボディをJSONからデコード res_body = json.loads(res_body) # レスポンスボディから解析結果を取得 return res_body if __name__ == '__main__': # ソースファイルの場所取得 APP_ROOT = os.path.dirname(os.path.abspath( __file__)) + "/" # 設定値取得 config = configparser.ConfigParser() config.read(APP_ROOT + "config.ini") CLIENT_ID = config.get("COTOHA API", "Developer Client id") CLIENT_SECRET = config.get("COTOHA API", "Developer Client secret") DEVELOPER_API_BASE_URL = config.get("COTOHA API", "Developer API Base URL") ACCESS_TOKEN_PUBLISH_URL = config.get("COTOHA API", "Access Token Publish URL") # COTOHA APIインスタンス生成 cotoha_api = CotohaApi(CLIENT_ID, CLIENT_SECRET, DEVELOPER_API_BASE_URL, ACCESS_TOKEN_PUBLISH_URL) # 解析対象文 sentence = "PythonとCOTOHAを使用して出力されたタイポグリセミア文章をQiitaに投稿" # 整形前を表示 print('before :') print(sentence) # 構文解析API実行 result_json = cotoha_api.parse(sentence) # 整形前の文字列リスト word_list_base = [] # 整形後の文字列リスト word_list = [] # 英数字判定用の正規表現 alnumReg = re.compile(r'^[a-zA-Z0-9 ]+$') # 解析結果をループして処理 for i in range(len(result_json['result'])): for j in range(len(result_json['result'][i]['tokens'])): # 英数字の場合は'form'の値を、日本語の場合は'kana'の値を利用する word = result_json['result'][i]['tokens'][j]['form'] kana = result_json['result'][i]['tokens'][j]['kana'] # 半角英数字か判定 if alnumReg.match(word) is not None: # 1単語かそうでないかを判定 if ' ' in word: # 複数後で構成される場合はさらに分解する word_list_base.extend(word.split(' ')) else : word_list_base.append(word) # 日本語 else : # カタカナをひらがなに変換してリストに追加 word_list_base.append(jaconv.kata2hira(kana)) # 各単語を解析し4文字以上の文字の先頭と末尾以外を入れ替える for i in range(len(word_list_base)): # 4文字以上 if len(word_list_base[i]) > 3: # まず1文字ずつのリストに分解 wl_all = list(word_list_base[i]) # 先頭文字と末尾文字を保持しておく first_word = wl_all[0] last_word = wl_all[len(wl_all) - 1] # 中の文字をリスト形式で取得 wl = wl_all[1:len(wl_all) - 1] # シャッフルする random.shuffle(wl) word_list.append(first_word + ''.join(wl) + last_word) # 4文字未満ならそのまま else : word_list.append(word_list_base[i]) # 整形結果を表示 print('after :') print(' '.join(word_list))

設定ファイル

config.ini[COTOHA API] Developer API Base URL: https://api.ce-cotoha.com/api/dev/ Developer Client id: 【クライアントID】 Developer Client secret:【シークレット】 Access Token Publish URL: https://api.ce-cotoha.com/v1/oauth/accesstokens使い方は

config.iniにクライアントIDとシークレットを入力し、cotoha_api.pyと同じ階層に置きます。

実行は下記の通りです。python cotoha_api.py実行結果before : PythonとCOTOHAを使用して出力されたタイポグリセミア文章をQiitaに投稿 after : pothyn と choota を しよう し て しょつりゅく さ れ た たぽせいみりぐあ ぶしょんう を qiita に とこううまとめ

Pythonや自然言語処理に関する知識など全く持ち合わせていないにも関わらず、流行りに乗って実装(ほぼ人様のスクリプト)まで行ってしまいました。

しかしながら、そんな状態でも個人的には満足な結果が得られたのでCOTOHAは非常に扱いやすく、入門としても最適なのではないでしょうか。この記事を読んで少しでも

COTOHAに興味を持っていただけたら幸いです。さこんぶぶうけん

- COTOHA APIリファレンス

- 自然言語処理を簡単に扱えると噂のCOTOHA APIをPythonで使ってみた

- 「メントスと囲碁の思い出」をCOTOHAさんに要約してもらった結果。COTOHA最速チュートリアル付き

あがとき

余談ですが「タイポグリセミア」は、誤植を意味する"typographical error"と低血糖を意味する"Hypoglycemi"のかばん語のようです。

かばん語とは、「熱さましーと」とか「ネスプレッソ」のように複数単語を用いて作られた単語です。あれ?これはこれで

COTOHAで扱ったら面白そうな予感が・・・やるとすれば、「COTOHAを使ってナウいかばん語を生み出してみた」とかですかね(笑)

- 投稿日:2020-02-18T23:55:52+09:00

サイトの更新日を真面目に取得する

サイトの更新日を取得するのってむずくね

レスポンスヘッダーを調べることで、静的なサイトであれば最終更新日がわかることがあります。

get_lastmodified.pyimport requests res = requests.head('https://www.kantei.go.jp') print(res.headers['Last-Modified'])Mon, 17 Feb 2020 08:27:02 GMT(前回記事)【Python】ウェブサイトの最終更新日を取得

一部ニュースサイトや日本の政府関係の多くのサイトではこれで問題なく取れるのですが、大半のサイトはうまくいきません。

KeyError: 'last-modified'じゃどうしたらいいかというと、大きく2つの方法がありそうです。

方針1 URLを見る

URLの中には 2019/05/01 や 2019-05-01 のような文字列が入っていることがあります。これを抜き出すのは有力で確実な手段です。

方針2 スクレイピング

最終的に頼るのはここなんでしょう。

ということで、これらの合わせ技で、普段読んでいるニュースサイトから自動でサイト更新日を抜き出していきます。

なお、サイトによってはBOTでのクロールを禁じていますので、あくまでHTMLファイルが手元にある状態で使ってください。スクレイパーはBeautifulSoup4を用い、取得した更新日はdatetime型に変換します。文字列の抽出や整形は正規表現を使います。

get_lastmodified.pyimport bs4 import datetime import re調べたニュースサイト

CNN

Bloomberg

BBC

Reuter

Wall Street Journal

Forbes Japan

Newsweek

朝日新聞

日経新聞

産経新聞

読売新聞

毎日新聞CNN

https://edition.cnn.com/2020/02/17/tech/jetman-dubai-trnd/index.html

get_lastmodified.pyprint(html.select('.update-time')[0].getText()) #Updated 2128 GMT (0528 HKT) February 17, 2020 timestamp_temp_hm = re.search(r'Updated (\d{4}) GMT', str(html.select('.update-time')[0].getText())) timestamp_temp_bdy = re.search(r'(January|February|March|April|May|June|July|August|September|October|November|December) (\d{1,2}), (\d{4})', str(html.select('.update-time')[0].getText())) print(timestamp_temp_hm.groups()) print(timestamp_temp_bdy.groups()) #('2128',) #('February', '17', '2020') timestamp_tmp = timestamp_temp_bdy.groups()[2]+timestamp_temp_bdy.groups()[1]+timestamp_temp_bdy.groups()[0]+timestamp_temp_hm.groups()[0] news_timestamp = datetime.datetime.strptime(timestamp_tmp, "%Y%d%B%H%M") print(news_timestamp) #2020-02-17 21:28:00 # 日付だけならURLからも取れる URL = "https://edition.cnn.com/2020/02/17/tech/jetman-dubai-trnd/index.html" news_timestamp = re.search(r'\d{4}/\d{1,2}/\d{1,2}', URL) print(news_timestamp.group()) #2020/02/17 news_timestamp = datetime.datetime.strptime(news_timestamp.group(), "%Y/%m/%d") print(news_timestamp) #2020-02-17 00:00:00コメント:'Updated'の文字列が常に入っているのかは未検証。CNNの記事はまとめページを除くと日付がURLに入っているので、これを取るのが確実に見える

Bloomberg

https://www.bloomberg.co.jp/news/articles/2020-02-17/Q5V6BO6JIJV101

get_lastmodified.pyprint(html.select('time')[0].string) # # # # 2020年2月18日 7:05 JST # # timesamp_tmp = re.sub(' ','',str(html.select('time')[0].string)) timesamp_tmp = re.sub('\n','',timesamp_tmp) news_timestamp = datetime.datetime.strptime(timesamp_tmp, "%Y年%m月%d日%H:%MJST") print(news_timestamp) #2020-02-18 07:05:00 # URLでも日付までは取れる URL = "https://www.bloomberg.co.jp/news/articles/2020-02-17/Q5V6BO6JIJV101" timestamp_tmp = re.search(r'\d{4}-\d{1,2}-\d{1,2}', URL) print(news_timestamp_tmp.group()) #2020-02-17 news_timestamp = datetime.datetime.strptime(timestamp_tmp, "%Y-%m-%d") print(news_timestamp) #2020-02-17 00:00:00コメント:タグ内で改行と空白があり一手間必要。

BBC

https://www.bbc.com/news/world-asia-china-51540981

get_lastmodified.pyprint(html.select("div.date.date--v2")[0].string) #18 February 2020 news_timestamp = datetime.datetime.strptime(html.select("div.date.date--v2")[0].string, "%d %B %Y") print(news_timestamp) #2020-02-18 00:00:00コメント:細かい時間はどこ見ればいいのかわかりませんでした。

Reuter

https://jp.reuters.com/article/apple-idJPKBN20C0GP

get_lastmodified.pyprint(html.select(".ArticleHeader_date")[0].string) #February 18, 2020 / 6:11 AM / an hour ago更新 m1 = re.match(r'(January|February|March|April|May|June|July|August|September|October|November|December) \d{1,2}, \d{4}',str(html.select(".ArticleHeader_date")[0].string)) print(m1.group()) #February 18, 2020 m2 = re.search(r'\d{1,2}:\d{1,2}',str(html.select(".ArticleHeader_date")[0].string)) print(m2.group()) #6:11 news_timestamp = datetime.datetime.strptime(m1.group()+' '+m2.group(), "%B %d, %Y %H:%M") print(news_timestamp) #2020-02-18 00:00:00Wall Street Journal

https://www.wsj.com/articles/solar-power-is-beginning-to-eclipse-fossil-fuels-11581964338

get_lastmodified.pyprint(html.select(".timestamp.article__timestamp")[0].string) # # Feb. 17, 2020 1:32 pm ET # news_timestamp = re.sub(' ','',str(html.select(".timestamp.article__timestamp")[0].string)) news_timestamp = re.sub('\n','',m) print(news_timestamp) #Feb.17,20201:32pmET news_timestamp = re.match(r'(Jan|Feb|Mar|Apr|May|Jun|Jul|Aug|Sep|Oct|Nov|Dec).(\d{1,2}),(\d{4})(\d{1,2}):(\d{1,2})',str(news_timestamp)) print(news_timestamp.groups()) #('Feb', '17', '2020', '1', '32') tmp = news_timestamp.groups() timesamp_tmp = tmp[0]+' '+ tmp[1].zfill(2)+' '+tmp[2]+' '+tmp[3].zfill(2)+' '+tmp[4].zfill(2) print(timesamp_tmp) #Feb 17 2020 01 32 news_timestamp = datetime.datetime.strptime(timesamp_tmp, "%b %d %Y %H %M") print(news_timestamp) #2020-02-17 01:32:00Forbes Japan

https://forbesjapan.com/articles/detail/32418

get_lastmodified.pyprint(html.select("time")[0].string) #2020/02/18 12:00 news_timestamp = datetime.datetime.strptime(html.select("time")[0].string, "%Y/%m/%d %H:%M") print(news_timestamp) #2020-02-18 12:00:00Newsweek

get_lastmodified.pyprint(html.select('time')[0].string) # On 2/17/20 at 12:11 PM EST m = re.search(r'(\d{1,2})/(\d{1,2})/(\d{1,2}) at (\d{1,2}:\d{1,2}) ', str(html.select('time')[0].string)) print(m.groups()) #('2', '17', '20', '12:11') tmp = m.groups() timesamp_tmp = tmp[0].zfill(2)+' '+ tmp[1].zfill(2)+' '+'20'+tmp[2].zfill(2)+' '+tmp[3] print(timesamp_tmp) news_timestamp = datetime.datetime.strptime(timesamp_tmp, "%m %d %Y %H:%M") print(news_timestamp) #2020-02-17 12:11:00朝日新聞

https://www.asahi.com/articles/ASN2K7FQKN2KUHNB00R.html?iref=comtop_8_07

get_lastmodified.pyprint(html.select('time')[0].string) #2020年2月18日 12時25分 news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y年%m月%d日 %H時%M分") print(news_timestamp) #2020-02-18 12:25:00コメント:静的でわかりやすい。ざっと見たところカテゴリー別でも揺らぎが無くて助かる。

日経新聞

https://r.nikkei.com/article/DGXMZO5556760013022020TL1000

get_lastmodified.pyprint(html.select('time')[1]) #2020年2月18日 11:00 news_timestamp = datetime.datetime.strptime(html.select('time')[1].string, "%Y年%m月%d日 %H:%M") print(news_timestamp) #2020-02-18 11:00:00https://www.nikkei.com/article/DGXLASFL18H2S_Y0A210C2000000

get_lastmodified.pyprint(html.select('.cmnc-publish')[0].string) #2020/2/18 7:37 news_timestamp = datetime.datetime.strptime(html.select('.cmnc-publish')[0].string, "%Y/%m/%d %H:%M") print(news_timestamp) #2020-02-18 07:37:00https://www.nikkei.com/article/DGXKZO55678940V10C20A2MM8000

get_lastmodified.pyprint(html.select('.cmnc-publish')[0].string) #2020/2/15付 news_timestamp = datetime.datetime.strptime(html.select('.cmnc-publish')[0].string, "%Y/%m/%d付") print(news_timestamp) #2020-02-15 00:00:00コメント:色々書き方がある。ざっと見で3つあったけれどもっとあるかも。

産経新聞

https://www.sankei.com/world/news/200218/wor2002180013-n1.html

get_lastmodified.pyprint(html.select('#__r_publish_date__')[0].string) #2020.2.18 13:10 news_timestamp = datetime.datetime.strptime(html.select('#__r_publish_date__')[0].string, "%Y.%m.%d %H:%M") print(news_timestamp) #2020-02-18 13:10:00コメント:よくみたらURLに時まで載ってた。

読売新聞

https://www.yomiuri.co.jp/national/20200218-OYT1T50158/

get_lastmodified.pyprint(html.select('time')[0].string) #2020/02/18 14:16 news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y/%m/%d %H:%M") print(news_timestamp) #2020-02-18 14:16:00コメント:日付だけならURLから取れる。

毎日新聞

https://mainichi.jp/articles/20180803/ddm/007/030/030000c

get_lastmodified.pyprint(html.select('time')[0].string) #2018年8月3日 東京朝刊 news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y年%m月%d日 東京朝刊") print(news_timestamp) #2018-08-03 00:00:00https://mainichi.jp/articles/20200218/dde/012/030/033000c

get_lastmodified.pyprint(html.select('time')[0].string) #2020年2月18日 東京夕刊 news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y年%m月%d日 東京夕刊") print(news_timestamp) #2020-02-18 00:00:00https://mainichi.jp/articles/20200218/k00/00m/010/047000c

get_lastmodified.pyprint(html.select('time')[0].string) #2020年2月18日 09時57分 #最終更新はprint(html.select('time')[1].string) news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y年%m月%d日 %H時%M分") print(news_timestamp) #2020-02-18 09:57:00https://mainichi.jp/premier/politics/articles/20200217/pol/00m/010/005000c

get_lastmodified.pyprint(html.select('time')[0].string) #2020年2月18日 news_timestamp = datetime.datetime.strptime(html.select('time')[0].string, "%Y年%m月%d日") print(news_timestamp) #2020-02-18 00:00:00コメント:毎日新聞では、電子版のみの記事は分単位で取得できるぽい。朝刊・夕刊からの記事と毎日プレミアについては、URLで取れるのと同じ、日付までしか取得できない。

表

ニュースサイト Rヘッダーから URLから HTML中身から CNN 年月日 年月日時分 Bloomberg 年月日 年月日時分 BBC 年月日 Reuter 年月日時分 Wall Street Journal 年月日時分 Forbes Japan 年月日時分 Newsweek 年月日時分 朝日新聞 年月日時分 年月日時分 日経新聞 年月日時分 産経新聞 年月日時分 年月日時 年月日時分 読売新聞 年月日 年月日時分 毎日新聞 年月日 年月日時分* *毎日新聞は記事によっては日付のみあるいは日付+朝/夕刊の記載

思ったこと

言語はもちろん、サイトごとに日付の表記はまちまちです。同じニュースサイト内であっても表記揺れがあり、それについては全てを確認できているわけではありません。

HTMLみても取れないけどURLを見るとわかる、というサイトは今のところ見つけられていません。合わせ技と言いましたが、スクレイピングだけで取得しても変わらないですね。

この方法は各サイトごとに地道にタグやクラス名を読んでいかなければならず、全てのサイトはもちろん、ニュースサイトのみですら対応するのはかなり難しそうです。もっと良いやり方があればぜひ教えてください。

- 投稿日:2020-02-18T23:54:56+09:00

cif2cellことはじめ

cif2cellの概要

CIF2Cell download | SourceForge.net

結晶構造のフォーマットであるcif(crystallographic Information File)から、第一原理計算コードの入力ファイル(原子配置の指定部分)を出力してくれる、pythonで書かれたアプリ。一般ユーザー権限でインストール

ものは試しで一般ユーザー権限で出来る範囲でのインストールを試みる。

例としてcif2cell-1.2.10.tar.gzを取ってきたとする。

$ tar -zxvf cif2cell-1.2.10.tar.gzで、展開し出来たcif2cell-1.2.10を/home/user/sourcesに移動。そのディレクトリに移動する。PyCiRWを一般ユーザー権限でインストール

実は、cif2cellをインストールするには、PyCiRWなるアプリが必要で、これはcif2cellのコードに同梱されている。

$ tar -zxvf PyCiRW-3.3.tar.gzで展開してできるPyCiRW-3.3に移動する。基本的には所謂

python setup.py installでインストールされる類のもの。ただ、この手続きで管理者権限がないとファイル追加できない/usr/lib64/python2.7/site-packagesにファイルを生成しようとするため、一工夫が必要。pythonで参照されるpathの確認

pythonを実行して、

import sys print(sys.path)で、現在参照できるpathの確認をしよう。この中に

home/user/.local/lib/python2.7/site-packagesのような、一般ユーザーが編集できる箇所があれば、そこに入れることができる。但し、私は極度の潔癖でインストールしたものは、それとわかるように別に置いておきたいので、明確に入れる先を作ることにする。インストール用ディレクトリを作成してインストール

インストールする先を、

/home/user/opt/PyCiRW-3.3とする。

のちに、インストールのprefixとして、このディレクトリを指定してインストールを試みると、適切なpathが設定されていないと怒られる。これは上で調べたpathの中に、これから入れるディレクトリに付随した箇所にpathが通っていないため。なので、適切にpathを追加することにする。

このpathの設定にはいくつか方法があるが、ここでは環境変数PYTHONPATHを設定することで解決することにする。export PYTHONPATH=/home/user/opt/PyCiRW-3.3/lib64/python2.7/site-packagesで、環境変数

PYTHONPATHが適切に設定される。このディレクトリはインストール前には存在していないが、これからインストールする先の下に先読みしてlib64/python2.7/site-packagesを補っておかないと、引き続くインストールのところでコケる。python setup.py install --prefix=/home/user/opt/PyCiRW-3.3で晴れてインストール終了。ソースのあるディレクトリにある

INSTALLに、import CifFileでインポートできれば、インストール成功とある。

多分だけど、これは

python setup.py installを一般ユーザー権限で行うときにいつも使える手続きのように思う。cif2cellを一般ユーザー権限でインストール

ここまでくれば、晴れてcif2cellがインストールできる。cif2cellのソースがあるディレクトリに移って、

python setup.py install --prefix=/home/user/opt/cif2cell-1.2.10でインストール完了。

cif2cellの使い方

(多分PyCiRWに

PYTHONPATHを通しておかないと実行できない気がするけれど、そのテストは後日して、ここに追記)

- 投稿日:2020-02-18T23:17:36+09:00

AtCoderのStreakを自分用に通知する!

この記事のまとめ

- AtCoderのStreakを続けたい!

- そのためにAtCoder APIを利用して自分宛てに通知するよ!

- Twitterやメールで通知するよ!

はじめに

AtCoderとは?

みなさんは、AtCoderって知っていますか?

AtCoderは、国内で最大の競技プログラミングサイトで、アルゴリズムやパズルの問題を世界同時に速さと正確さを競うことができます。そのうち、特に嬉しい点として

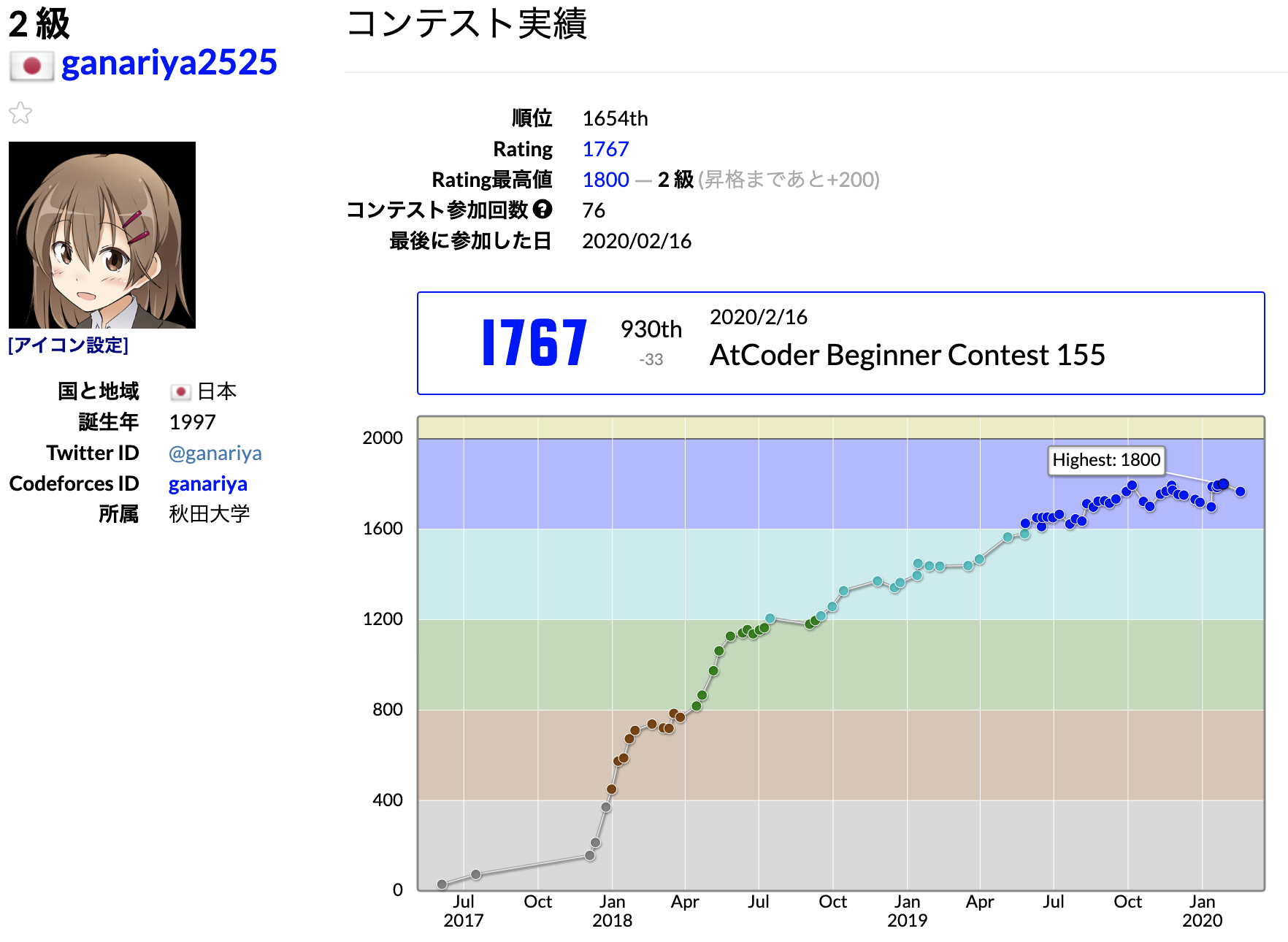

以下のようにコンテストの結果によってレートが出ます。出れば出るほどレートは上がるというものではありません。

いい順位を取らなければ、レートは無慈悲にも下がってしまいます><

そのため、面白い問題を自分の発想で解いてレートが上がったときは、ものすごくドーパミンがドバドバ、キメるタイプの朝ココになります><Streakとは?

AtCoderの公式ではないのですが

有志で作られているもっとも有名な便利ツールにAtCoder Problemsがあります。上記のようにこれまで解いた問題をわかりやすくビジュアライズしたり

これまでの解いてきた統計を可視化してくれる、すごすぎるサービスです><!!!!

このなかで、Streakというものが存在します。

上記の画像にCurrent Streakというものが存在しますが、これは

「何日連続で、まだ解いてない問題を新しく解いたか?」を表すものです。

つまり、このCurrent Streakが大きいほど、より熱心に毎日新規問題に取り組み、日々精進しているか?を表しています。一番大きい人だと1000弱、つまり1000日間毎日新規問題を解いていることになります。すごいです><!

発生した問題点

現在、ガナリヤは「Streakをできるだけ続けたい!」という意思を持って、毎日新規AC、つまりStreakを続けています。

しかし、自分はダメ人間なので、ニコニコ動画やYouTubeを見てるとStreakを忘れて途切れてしまうことが多々ありました。

これではStreakを大きくすることはできません。

そこで、個人用にStreakを自分宛てに通知することにしました。

AtCoder APIとStreak判定

AtCoderのStreakの判定に

AtCoder Problemsの作者(@kenkoooo)さんの非公式AtCoder APIを利用させていただきました。

ありがとうございます!今回は非常に小さいデータしか使わないため、直接APIを叩かせていただいていますが、大規模に叩く場合はドキュメントを参照してキャッシュなどの処理をしてください。

今回はこのAPIのうち

https://kenkoooo.com/atcoder/atcoder-api/results?user={user_name}を利用します。これによって、user_nameのこれまでのSubmit経歴を見ることができます。

APIをPythonで叩く

APIはpythonで叩くことにしました。

ライブラリはrequestsを用います。# coding: UTF-8 import datetime import time import os import requests user_name = "ganariya2525" user_url = f"https://kenkoooo.com/atcoder/atcoder-api/results?user={user_name}" res = requests.get(user_url).json()上記のコードで、これまでの自分のSubmit経歴を取得しましょう。

今日はStreakできているか確認する

次に、取得したデータからStreakがうまく行っているか判定しましょう。

# coding: UTF-8 import datetime import time import os import requests user_name = "ganariya2525" user_url = f"https://kenkoooo.com/atcoder/atcoder-api/results?user={user_name}" res = requests.get(user_url).json() # 今の時間(Asia) now = datetime.datetime.fromtimestamp(time.time(), datetime.timezone(datetime.timedelta(hours=9))) # 以前に解いたもの accepted = set() # 今日のAC today_accepted = [] # 各提出p を見る for p in res: # pの提出をしたときの時間 dt = datetime.datetime.fromtimestamp(p['epoch_second'], datetime.timezone(datetime.timedelta(hours=9))) # pが解いた問題のID p_id = p['problem_id'] # 正解でないなら関係ない if p['result'] != 'AC': continue # 以前に解いている if dt.date() < now.date(): accepted.add(p_id) # 今日解いて、しかもまだ解いていない問題なら if dt.date() == now.date() and p_id not in accepted: today_accepted.append(p)上記のようなソースコードにすることで、今日新しく新規ACしているか判定することができます。

多分もっと簡潔かつ丁寧なコードにできると思います。時間のあるときに、今何Streak続いているか?も判定したいですね。

あとは、today_acceptedを見て

- today_acceptedが空なら、新規ACなし!解け!

- today_acceptedが要素を持つなら、新規ACあり!好きなことしろ!

を判定できます><

通知をする

今度は実際に通知をしてみます。

今回は

- SendGrid(メール送信サービス)

- python-twitter(Twitterのサードパーティライブラリ)

を用いて、メールとTwitterで自分自身に通知しています。

以下のようなコードです。

# coding: UTF-8 import datetime import time import os import requests import twitter from sendgrid import SendGridAPIClient from sendgrid.helpers.mail import Mail api = twitter.Api( "consumer_key", "cusumer_secret", "access_token_key", "access_token_secret" ) user_url = "https://kenkoooo.com/atcoder/atcoder-api/results?user=ganariya2525" res = requests.get(user_url).json() now = datetime.datetime.fromtimestamp(time.time(), datetime.timezone(datetime.timedelta(hours=9))) accepted = set() today_accepted = [] for p in res: dt = datetime.datetime.fromtimestamp(p['epoch_second'], datetime.timezone(datetime.timedelta(hours=9))) p_id = p['problem_id'] if p['result'] != 'AC': continue if dt.date() < now.date(): accepted.add(p_id) if dt.date() == now.date() and p_id not in accepted: today_accepted.append(p) directory = os.path.dirname(__file__) dame = os.path.join(directory, 'dame.gif') happy = os.path.join(directory, 'tenor.gif') # ダメなら if len(today_accepted) == 0: text_message = "Streak (Python) " + str(now.strftime("%Y-%m-%d %H:%M:%S")) # 画像付きツイート api.PostUpdate(text_message, media=dame) # OK else: text_message = "Streakをセイキンさんも喜んでくれている (Python) " + str(now.strftime("%Y-%m-%d %H:%M:%S")) api.PostUpdate(text_message, media=happy) # メールの作成 # 普段使っている自分のメール(ganariya@ganariya.com.com)に送る message = Mail( from_email='sendgridのメアド', to_emails='ganariya@ganariya.com.com', subject='AtCoder Streak', html_content=text_message ) try: # ダメな場合のみメールを送る if len(today_accepted) == 0: sg = SendGridAPIClient('SendGridのAPIキー') response = sg.send(message) print(response.status_code) print(response.body) print(response.headers) except Exception as e: print(e.message)Sendgridでダメだったら自分宛にメールを贈っています。

また、Twitterライブラリを用いて、もしStreakを繋いでいたら嬉しいという感情のツイートを、ダメだったら焦らせるツイートをしています。Streakをセイキンさんも喜んでくれている (Python) 2020-02-18 23:00:02 pic.twitter.com/hWCsWJuLtf

— 人生さん (@ganariya) February 18, 2020上記のように自動でツイートされます。

これを用いるためにはSendgridのアカウント作成やTwitterのDeveloperアカウントの取得が必要です。

これらのプログラムは

cronを用いて

18:00, 21:00, 23:00に実行されるようになっています。

一時期cronの設定が間違っていて、毎分通知が来るようになっていて、Twitterのツイートがセイキンさんばかりになって焦りました><最後に

Streakの通知についてまとめてみました。

AtCoderのStreakは一日でも忘れると、すごく悔しいです。

みなさんも興味があればStreakの通知を行ってみてください><メールやTwitter以外にももっと色々な通知ができそうで楽しみです!

間違っている点や質問点がありましたら、ぜひコメントしていただければと思います!

- 投稿日:2020-02-18T22:25:40+09:00

【基本文法編】Ruby/Python/PHPの違い

はじめに

個人的な学習のまとめです!

3つの言語の基本文法を学習したのでまとめてみました!1. 出力

Rubyputs "Hello, world"Pythonprint("Hello, world")PHPecho "Hello, world";2. 変数

Rubyvariable = "変数”Pythonvariable = "変数”PHP$variable = "変数”;3.プロパティ値の出力

Ruby# attr_accessor :name 等でゲッターを定義する puts person.namePython# def __init__ 等でゲッターを定義する print(person.name)PHPecho $person->name();4. If文

Rubyif number % 15 == 0 puts "FizzBuzz" elsif number % 3 == 0 puts "Fizz" elsif number % 5 == 0 puts "Buzz" else puts number endPythonif number % 15 == 0: print("FizzBuzz") elif number % 3 == 0: print("Fizz") elif number % 5 == 0: print("Buzz") else: print(number)PHPif (number % 15 == 0){ echo "FizzBuzz"; } elseif (number % 3 == 0){ echo "Fizz"; } elseif (number % 5 == 0){ echo "Buzz"; } else { echo $number; }5. 配列/ハッシュ編

Ruby# 配列 array = ["赤", "青", "黄"] # ハッシュ hash = {"大阪府": "大阪", "愛知県": "名古屋", "東京都": "東京?"}Python# リスト lists = ["赤", "青", "黄"] # 辞書 dict = {"大阪府": "大阪", "愛知県": "名古屋", "東京都": "東京?"}PHP//配列 $array = ["赤", "青", "黄"]; //連想配列 $associative_array = [ "大阪府" => "大阪", "愛知県" => "名古屋", "東京都" => "東京?" ];6. 繰り返し構文

6-1.ループ処理

Rubyi = 1 while i <= 100 do # 処理 i += 1 endPythoni = 1 while i <= 100: # 処理 i += 1 for i in range(1, 101): # 処理PHPfor ($i = 1;$i <= 100;$i++){ //処理 }6-2. 反復処理(?)

Rubyarray.each do |value| #処理 end hash.each {|key, value| #処理 }Pythonfor value in lists: # 処理 for key in dict: # 処理PHPforeach($array as $value){ //処理 } foreach($associativeArray as $key => $value){ //処理 }7.関数定義

Rubydef hello # 処理 endPythondef hello(): # 処理 return # 戻り値PHPfunction hello() { // 処理 return // 戻り値 }8.クラスとインスタンス

Rubyclass Person @@number = 0 def self.classmethod # 処理 end def initialize(name) @name = name end person = Person.new("山田") endPythonclass Person: number = 0 @classmethod def classmethod: # 処理 def __init__(self, name): self.name = name end person = Person("山田") endPHPclass Person { private static $number; private $name; public function static function classmethod(){ echo self::$number; } public function __construct($name){ $this->name = $name; } $person = new Person(); }9.ゲッターとセッター

Rubydef setName(name) @name = name end def getName @name end #あるいは attr_accessor :namePythondef __init__(self, name): self._name = name @property def name(self): return self.__name @name.setter def name(self, name): self.__name = namePHPpublic function setName($name) { $this->name = $name; } public function getName() { return $this->name; }10.最後に

1ブロックをどのように(end/インデント/{})指定するかに個性がある感じですね!

ご一読頂き、ありがとうございました!

- 投稿日:2020-02-18T21:35:06+09:00

pythonを使った株価の自動収集

はじめに

最近、株価を予想するAIを作って欲しいということで、全くいい精度がでる期待もなかったが作ることにした。

過去にkerasやtensorflowを使ってAIを作ったことがあったが、株価を集めることはしたことがなかったのでやり方をまとめておく。

ビックデータを使いこなすにはスクレイピングやAPIの扱いになれなくてはと思ったりおもってみたり。

Quandl

流石に手動では絶命するので自動で収集する方法がないかと調べていたら、Quandlをみつけた。

銘柄コードを指定してAPIのURLにアクセスすればCSVでダウンロードできる。会員登録

まずはここから会員登録をして、API keyをもらう必要がある。

ライブラリ経由で取得

$pip3 install quandl使用方法

株価取得

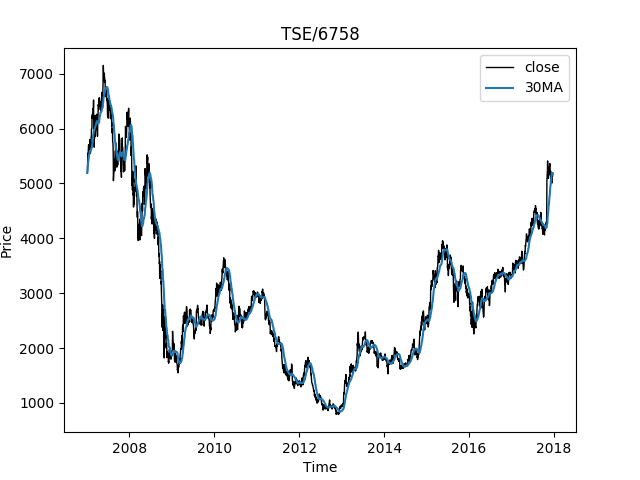

データの取得は、quandl.get()でできる。引数は銘柄コードのみでOK。

TSEは株式会社東京証券取引所らしい。import quandl import pandas as pd import matplotlib.pyplot as plt # SONYの株価を取得 brand = "TSE/6758" # quandlに登録して得られたAPI keyを指定する。 quandl.ApiConfig.api_key = 'your API key' # 株価の取得 quandl_data = quandl.get(dataset=brand, returns='pandas') # CSVへ保存 quandl_data.to_csv('stock_price_data.csv')移動平均の計算

せっかくなので終値の30日移動平均も計算。

## 移動平均を計算 quandl_data['30MA'] = quandl_data['Close'].rolling(window = 30, min_periods=0).mean()グラフに表示

fig = plt.figure() axes = fig.add_axes([0.1, 0.1, 0.8, 0.8]) axes.plot(quandl_data['Close'], 'black', lw = 1,label="close") axes.plot(quandl_data['30MA'],label="30MA") axes.set_xlabel('Time') axes.set_ylabel('Price') axes.set_title(brand) axes.legend() plt.savefig('stock_price_data.png') plt.pause(0.001)複数の銘柄から株価を取得

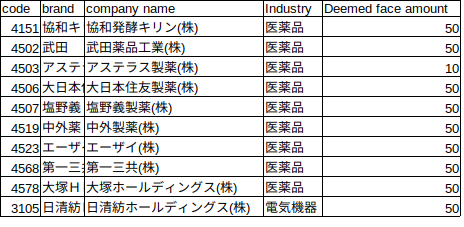

株価の学習をする上で、一つの銘柄より複数の銘柄で学習するのもいいのでは?と思いました。

ということで、複数の銘柄を一度に取得する方法も記載。銘柄code listを作成

前もって銘柄code list(code.csv)を作成しておきます。

主要な銘柄である日経225から10件だけを対象にします。株価取得

# get data print('Getting stock price...') import quandl import pandas as pd import matplotlib.pyplot as plt quandl.ApiConfig.api_key = 'your API key' # 銘柄codeをcsvから読み出し code = pd.read_csv('code.csv') # DataFrameからのDataをlist型かつ文字列として変換 code = ["TSE/"+str(n) for n in code['code'].values.tolist()] # 複数銘柄の株価取得 quandl_data = quandl.get(dataset=code, returns='pandas') # quandl_dataのcolumnsにあるstr(文字列)でCloseが含まれているcolumnsのみを抽出します。 quandl_data = quandl_data.loc[:,(quandl_data.columns.str.contains('Close'))] # 銘柄ごとに終値の移動平均を算出 for k in range(len(code)): quandl_data[code[k] + '_30MA'] = quandl_data.rolling(window = 30, min_periods=0).mean().iloc[:,0] quandl_data.to_csv('dataset.csv')まとめ

今回は、pythonを使って株価を自動収集した。

AIの学習には大量のデータが必要であるが手作業であつめるとなると大変。

この自動収集のやり方は、FXでも適応できますのでぜひ試してください。

AIもすでに作成して精度評価しているのでもしかしたら投稿するかも??

1銘柄のデータセットと255銘柄のデータセットどちらを使うと精度がよくなるとか、AI学習前の前処理の仕方とか、どうすれば勝率があがるかなどなど。

ちなみに、移動平均の予測値は1銘柄2007~2017年のデータセットでAccuracy84~85%、誤差16円。

工夫することで勝率96%、儲からないという検出力96%まで向上させることができた。

詳しくはAI(Deep Learning)作成編で。

- 投稿日:2020-02-18T21:26:55+09:00

【Python】Flaskチュートリアル#3 ~ DB連携編 ~

前回までのあらすじと今回実装するもの

#1ではGETリクエストに対する処理を実装しました。

#2ではPOST, PUT, DELETEリクエストに対する処理を実装しました。

#3となる今回はこれまで実装した処理を全てDB連携した処理に書き換えていきます!詳しくは以下の動画で紹介しています!

ソースコード

.envDB_USER=root DB_PASS=*********init_db.pyimport sqlalchemy import os from os.path import join, dirname from dotenv import load_dotenv load_dotenv(verbose=True) dotenv_path = join(dirname(__file__), '.env') load_dotenv(dotenv_path) DB_USER = os.environ.get('DB_USER') DB_PASS = os.environ.get('DB_PASS') url = f'mysql+mysqldb://{DB_USER}:{DB_PASS}@localhost/test?charset=utf8' engine = sqlalchemy.create_engine(url, echo=True) engine.execute(f'DROP TABLE IF EXISTS posts') engine.execute(''' CREATE TABLE posts ( id INTEGER PRIMARY KEY AUTO_INCREMENT, title CHAR(30), body TEXT ) ''')db.pyimport sqlalchemy import os from os.path import join, dirname from dotenv import load_dotenv load_dotenv(verbose=True) dotenv_path = join(dirname(__file__), '.env') load_dotenv(dotenv_path) DB_USER = os.environ.get("DB_USER") DB_PASS = os.environ.get("DB_PASS") url = f'mysql+mysqldb://{DB_USER}:{DB_PASS}@localhost/test?charset=utf8' engine = sqlalchemy.create_engine(url, echo=True)app.pyfrom flask import Flask, jsonify, request from db import engine import json app = Flask(__name__) db_data = [ {'title': 'タイトル1', 'body': '本文1'}, {'title': 'タイトル2', 'body': '本文2'}, {'title': 'タイトル3', 'body': '本文3'}, {'title': 'タイトル4', 'body': '本文4'}, {'title': 'タイトル5', 'body': '本文5'}, ] app.config['JSON_AS_ASCII'] = False @app.route('/', methods=['GET']) def index(): return 'hello world' @app.route('/posts', methods=['GET']) def get_all_posts(): if 'limit' in request.args: limit = request.args['limit'] posts = engine.execute(f''' SELECT * FROM posts LIMIT {int(limit)} ''') else: posts = engine.execute(f''' SELECT * FROM posts ''') result = [dict(row) for row in posts] return jsonify(result) @app.route('/post/<id>', methods=['GET']) def get_post(id): posts = engine.execute(f''' SELECT * FROM posts WHERE id={int(id)} ''') result = [dict(row) for row in posts] return jsonify(result) @app.route('/post/add', methods=['POST']) def create_post(): post = request.json engine.execute(f''' INSERT INTO posts (title, body) VALUES ('{post['title']}', '{post['body']}') ''') return 'success' @app.route('/post/update/<id>', methods=['PUT']) def update_post(id): post = request.json engine.execute(f''' UPDATE posts SET title='{post['title']}', body='{post['body']}' WHERE id={int(id)} ''') return 'success' @app.route('/post/delete/<id>', methods=['DELETE']) def delete_post(id): engine.execute(f''' DELETE FROM posts WHERE id={int(id)} ''') return 'success' if __name__ == '__main__': app.debug = True app.run()

- 投稿日:2020-02-18T21:26:55+09:00

Flaskチュートリアル#3 ~ DB連携編 ~

前回までのあらすじと今回実装するもの

#1ではGETリクエストに対する処理を実装しました。

#2ではPOST, PUT, DELETEリクエストに対する処理を実装しました。

#3となる今回はこれまで実装した処理を全てDB連携した処理に書き換えていきます!詳しくはこちらで紹介しています。

ソースコード

.envDB_USER=root DB_PASS=*********init_db.pyimport sqlalchemy import os from os.path import join, dirname from dotenv import load_dotenv load_dotenv(verbose=True) dotenv_path = join(dirname(__file__), '.env') load_dotenv(dotenv_path) DB_USER = os.environ.get('DB_USER') DB_PASS = os.environ.get('DB_PASS') url = f'mysql+mysqldb://{DB_USER}:{DB_PASS}@localhost/test?charset=utf8' engine = sqlalchemy.create_engine(url, echo=True) engine.execute(f'DROP TABLE IF EXISTS posts') engine.execute(''' CREATE TABLE posts ( id INTEGER PRIMARY KEY AUTO_INCREMENT, title CHAR(30), body TEXT ) ''')db.pyimport sqlalchemy import os from os.path import join, dirname from dotenv import load_dotenv load_dotenv(verbose=True) dotenv_path = join(dirname(__file__), '.env') load_dotenv(dotenv_path) DB_USER = os.environ.get("DB_USER") DB_PASS = os.environ.get("DB_PASS") url = f'mysql+mysqldb://{DB_USER}:{DB_PASS}@localhost/test?charset=utf8' engine = sqlalchemy.create_engine(url, echo=True)app.pyfrom flask import Flask, jsonify, request from db import engine import json app = Flask(__name__) db_data = [ {'title': 'タイトル1', 'body': '本文1'}, {'title': 'タイトル2', 'body': '本文2'}, {'title': 'タイトル3', 'body': '本文3'}, {'title': 'タイトル4', 'body': '本文4'}, {'title': 'タイトル5', 'body': '本文5'}, ] app.config['JSON_AS_ASCII'] = False @app.route('/', methods=['GET']) def index(): return 'hello world' @app.route('/posts', methods=['GET']) def get_all_posts(): if 'limit' in request.args: limit = request.args['limit'] posts = engine.execute(f''' SELECT * FROM posts LIMIT {int(limit)} ''') else: posts = engine.execute(f''' SELECT * FROM posts ''') result = [dict(row) for row in posts] return jsonify(result) @app.route('/post/<id>', methods=['GET']) def get_post(id): posts = engine.execute(f''' SELECT * FROM posts WHERE id={int(id)} ''') result = [dict(row) for row in posts] return jsonify(result) @app.route('/post/add', methods=['POST']) def create_post(): post = request.json engine.execute(f''' INSERT INTO posts (title, body) VALUES ('{post['title']}', '{post['body']}') ''') return 'success' @app.route('/post/update/<id>', methods=['PUT']) def update_post(id): post = request.json engine.execute(f''' UPDATE posts SET title='{post['title']}', body='{post['body']}' WHERE id={int(id)} ''') return 'success' @app.route('/post/delete/<id>', methods=['DELETE']) def delete_post(id): engine.execute(f''' DELETE FROM posts WHERE id={int(id)} ''') return 'success' if __name__ == '__main__': app.debug = True app.run()

- 投稿日:2020-02-18T20:30:12+09:00

2つの分かち書きの対応を計算する

言語処理をする際,mecabなどのトークナイザを使って分かち書きすることが多いと思います.本記事では,異なるトークナイザの出力(分かち書き)の対応を計算する方法とその実装(tokenizations)を紹介します.

例えば以下のような,sentencepieceとBERTの分かち書きの結果の対応を計算する,トークナイザの実装に依存しない方法を見ていきます.# 分かち書き (a) BERT : ['フ', '##ヘルト', '##ゥス', '##フルク', '条約', 'を', '締結'] (b) sentencepiece : ['▁', 'フ', 'ベル', 'トゥス', 'ブルク', '条約', 'を', '締結'] # 対応 a2b: [[1], [2, 3], [3], [4], [5], [6], [7]] b2a: [[], [0], [1], [1, 2], [3], [4], [5], [6]]問題

先ほどの例を見ると,分かち書きが異なると以下のような差異があることがわかります

- トークンの切り方が異なる

- 正規化が異なる (例: ブ -> フ)

- 制御文字等のノイズが入りうる (例: #, _)

差異が1.だけなら簡単に対処できそうです.二つの分かち書きについて,1文字ずつ上から比べていけば良いです.実際,以前spaCyに実装した

spacy.gold.align(link)はこの方法で分かち書きを比較します.

しかし2.や3.が入ってくると途端にややこしくなります.各トークナイザの実装に依存して良いならば,制御文字を除いたりして対応を計算することができそうですが,あらゆるトークナイザの組み合わせに対してこのやり方で実装するのは骨が折れそうです.

spacy-transformersはこの問題に対して,ascii文字以外を全部無視するという大胆な方法を採用しています.英語ならばそこそこ動いてくれそうですが,日本語ではほとんど動きません.

ということで今回解くべき問題は,上記1~3の差異を持つ分かち書きの組みの対応を計算することです.正規化

言語処理では様々な正規化が用いられます.例えば

- Unicode正規化: NFC, NFD, NFKC, NFKD

- 小文字化

- アクセント削除

などです.上記一つだけでなく,組み合わせて用いられることも多いです.例えばBERT多言語モデルは小文字化+NFKD+アクセント削除を行なっています.

対応の計算法

2つの分かち書きを

A,Bとします.例えばA = ["今日", "は", "いい", "天気", "だ"]となります.以下のようにして対応を計算することができます.

- 各トークンをNFKDで正規化し,小文字化をする

A,Bのそれぞれのトークンを結合し,2つの文字列Sa,Sbを作る. (例:Sa="今日はいい天気だ")SaとSbの編集グラフ上での最短パスを計算する- 最短パスを辿り,

SaとSbの文字の対応を取得する- 文字の対応からトークンの対応を計算する

要するに適当に正規化した後に,diffの逆を使って文字の対応を取り,トークンの対応を計算します.肝となるのは3で,これは編集距離のDPと同じ方法で計算でき,例えばMyers' algorithmを使えば低コストで計算できます.

1.でNFKDを採用したのは,Unicode正規化の中でもっとも正規化後の文字集合が小さいからです.つまりヒット率をなるべくあげることができます.例えば"ブ"と"フ"はNFKDでは部分的に対応を取れますが,NFKCでは対応を取れません.>>> a = unicodedata.normalize("NFKD", "フ") >>> b = unicodedata.normalize("NFKD", "ブ") >>> print(a in b) True >>> a = unicodedata.normalize("NFKC", "フ") >>> b = unicodedata.normalize("NFKC", "ブ") >>> print(a in b) False実装

実装はこちらに公開しています: GitHub: tamuhey/tokenizations

中身はRustですが,Pythonバインディングも提供しています.Pythonライブラリは以下のように使えます.

$ pip install pytokenizations>>> import tokenizations >>> tokens_a = ['フ', '##ヘルト', '##ゥス', '##フルク', '条約', 'を', '締結'] >>> tokens_b = ['▁', 'フ', 'ベル', 'トゥス', 'ブルク', '条約', 'を', '締結'] >>> a2b, b2a = tokenizations.get_alignments(tokens_a, tokens_b) >>> print(a2b) [[1], [2, 3], [3], [4], [5], [6], [7]] >>> print(b2a) [[], [0], [1], [1, 2], [3], [4], [5], [6]]終わりに

先日,Camphrという言語処理ライブラリを公開しましたが,このライブラリの中で

pytokenizationsを多用しています.transformersとspaCyの分かち書きの対応を計算するためです.おかげで,2つのライブラリを簡単に結合できるようになり,モデルごとのコードを書く必要がなくなりました.地味ですが実用上非常に役に立つ機能だと思います.

- 投稿日:2020-02-18T18:57:15+09:00

しきい値を自動的に決定する手法のまとめ

最近,しきい値を自動的に決定したいという話をよく相談されるので,まとめてみました.

しきい値設計とは,1次元の教師なし2グループのクラスタリングに対応し

ます.

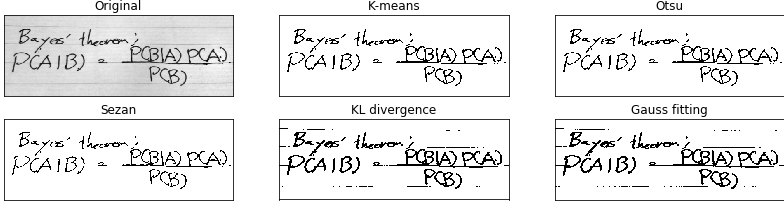

今回は,画像の2値化を例として,5個の古典的かつ有用な手法をまとめます.注意: 分布系が未知ならば,しきい値決定には正解はありません

準備

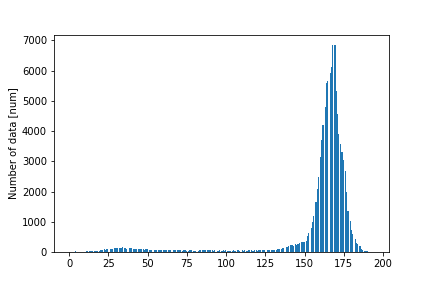

この画像の輝度のヒストグラムは以下の様になります.

この輝度の分布から最適な閾値を設定し,バイナリー画像を作るという問題になります.

K-means [1]

教師なし学習で最も有名な手法は,K-meansです (wiki).

K-meansは以下の最適化問題の解となるそれぞれのクラスの中心点 {m1,...,mM}を探すことを目的としています.$$

{\rm minimize}_{m_1,\ldots, m_M} \quad \sum_{i=1}^N \min_j |x_i - m_j|

$$ここで{x1,...,xN}は与えられたデータになります.

クラスの中心点{m1,...,mM)}は以下の2つを繰り返すことによって求められます.

1. クラス内の平均値の計算する.

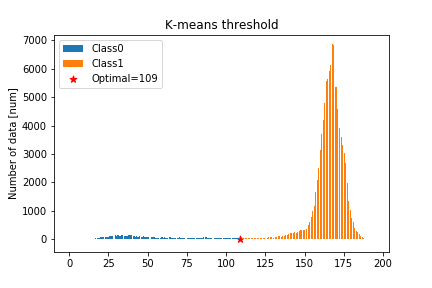

2. データをもっとも近い中心のクラスに割り当て直す.K-meansは多次元の場合でも適用できますが,閾値設計の問題ではM=2となります.

この分類の結果は次の図のようになります.

K-meansの特徴としては,以下のような特徴があります.

- 更新ごとにN×Mオーダーの距離を計算する必要がある.

- 初期値依存性が存在する.import cv2 import numpy as np import pandas as pd import matplotlib.pyplot as plt # データの読み込み img = cv2.imread('img/main.png',0) data = img.reshape(-1) # ラベルの初期化 labels = np.random.randint(0,2,data.shape[0]) # 終了条件 OPTIMIZE_EPSILON = 1 m_0_old = -np.inf m_1_old = np.inf for i in range(1000): # それぞれの平均の計算 m_0 = data[labels==0].mean() m_1 = data[labels==1].mean() # ラベルの再計算 labels[np.abs(data-m_0) < np.abs(data-m_1)] = 0 labels[np.abs(data-m_0) >= np.abs(data-m_1)] = 1 # 終了条件 if np.abs(m_0 - m_0_old) + np.abs(m_1 - m_1_old) < OPTIMIZE_EPSILON: break m_0_old = m_0 m_1_old = m_1 # 初期値によって,クラスが変化するため上界の小さい方を採用 thresh_kmeans = np.minimum(data[labels==0].max(),data[labels==1].max())大津法 [2]

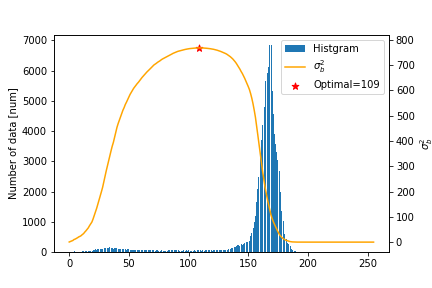

大津法は各クラスの重み付き平均値の差を最大化する方法です(wiki).

具体的には以下の最適化問題を解くしきい値Tを見つけることに対応します.$$

{\rm maximize}_T\quad \sigma_b^2 (T):= w_1 (m_1 - m)^2 +w_2 (m_2 - m)^2

$$ここで,

$$

w_1 = \frac{ | {x_1,\ldots, x_N}\leq T|}{N},\quad w_2 = \frac{ | {x_1,\ldots, x_N} > T|}{N}

$$

$$

m_1 = \frac{\sum_{x_i\leq T} x_i}{\sum x_i},\quad m_2 = \frac{\sum_{x_i>T} x_i}{\sum x_i}

$$

となります.上記のσbを最大化する問題は,各クラスの分散の重み付き和

$$

\sigma_a^2 (T) := w_1 \frac{\sum_{x_i\leq T} (x_i - m_1)^2}{N} +w_2 \frac{\sum_{x_i>T} (x_i - m_2)^2}{N}

$$

を最小化する問題と一致します.

そのため,σa最小化の問題やσa/σbを最小化する問題を解くこともあります.この分類の結果は次の図のようになります.

以下にpythonでのコードを記述します.

# Define Otsu scoring function def OtsuScore(data,thresh): w_0 = np.sum(data<=thresh)/data.shape[0] w_1 = np.sum(data>thresh)/data.shape[0] # check ideal case if (w_0 ==0) | (w_1 == 0): return 0 mean_all = data.mean() mean_0 = data[data<=thresh].mean() mean_1 = data[data>thresh].mean() sigma2_b = w_0 *((mean_0 - mean_all)**2) + w_1 *((mean_1 - mean_all)**2) return sigma2_b # Callculation of Otsu score and analyze the optimal scores_otsu = np.zeros(256) for i in range(scores_otsu.shape[0]): scores_otsu[i] = OtsuScore(data,i) thresh_otsu = np.argmax(scores_otsu)Sezanらによる方法 [3]

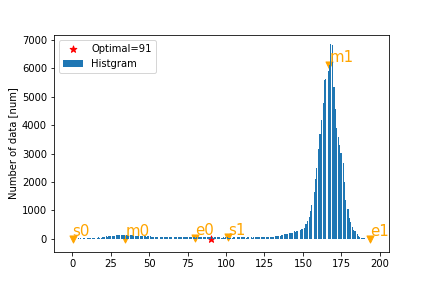

画像の輝度の分布などで,ピークが2つあるということを利用したしきい値設計手法です.

2つのピークの内側のすその値を求めることにより,しきい値を設計します.まず,平滑化したヒストグラムを極地計算により,一番左側(値が小さい)のピークと一番右側(値が大きい)のピークを検出し,それぞれ[m0,m1]とします.

同じく極地の計算によって,各ピークの左右の裾を計算し,左の裾を[s0,s1], 右の裾を[e0,e1]とします.このとき,しきい値は左側のピークの右側の裾e0と右側のピークの左側の裾s1の間にあると考えられます.

そのため,0以上1以下の設計パラメーターγを用いて,しきい値を設計します.$$

{\rm Sezan~threshold} := (1 - \gamma )e_0 + \gamma s_1

$$この分類の結果は次の図のようになります.

Sezanらによる2値のしゅほうの特徴として以下があります.

- 調整するハイパーパラメーターが多いが状況に合わせて使い分けることができる

- 多次元化が難しいpythonコードは以下のようになります.

# 平滑化パラメータ sigma = 5.0 # 重要視する割合 # gamma = 1 : 黒の領域を広めに取る # gamma = 0 : 白の領域を広めに取る gamma = 0.5 # 平滑化のためのガウスカーネル def getGaus(G_size,G_sigma): G_kernel = np.zeros(G_size) G_i0 = G_size//2 for i in range(G_size): G_kernel[i] = np.exp(-(i-G_i0)**2 / (2*G_sigma**2)) # 和が1になるように調整 G_kernel = G_kernel/G_kernel.sum() return G_kernel # ガウスカーネルの作成 kernel = getGaus(55,sigma) # ヒストグラム化 num_hist, range_hist = np.histogram(data, bins= 256) mean_hist = (range_hist[1:] + range_hist[:-1]) / 2 # 平滑化 hist_bar = np.convolve(num_hist,kernel,'same') # 差分の計算 d_hist = hist_bar[:-1] - hist_bar[1:] # 端の処理 d_hist = np.r_[[0],d_hist,[0]] # ピーク検出 m = np.where((d_hist[1:] >=0) & (d_hist[:-1] <=0))[0] # 局地検出 es =np.where((d_hist[1:] <=0) & (d_hist[:-1] >=0))[0] # 最大ピークと最小ピーク m0 = m.min() m1 = m.max() # ピーク前後の局地 s0 = es[es<m0].max() e0 = es[es>m0].min() s1 = es[es<m1].max() e1 = es[es>m1].min() # 閾値決定 thresh_Sezan = (1 - gamma) * mean_hist[e0] + gamma * mean_hist[s1]カルバック・ライブラー情報量最小化 [4]

情報理論の研究者におなじみのカルバック・ライブラー(KL)情報量を使う手法です.

KL情報量以外の他の情報量基準で研究されている論文も多数あります.まず,輝度のヒストグラムを正規化した確率分布をpと定義します.

次に,しきい値Tによって定まる2値化に対応する確率関分布q(T)を以下のように定義します.

$$

q(i\leq T) = 0,\quad q(i>T) = 1/M

$$ここで,Mはしきい値より大きい要素の数です.

q(T)とpによるKL情報量D(q(T)||p)を最小化する値をしきい値とします.

つまり,以下の最適化問題を解きます.

$$

{\rm minimize}_T\quad D(q(T)||p)

$$

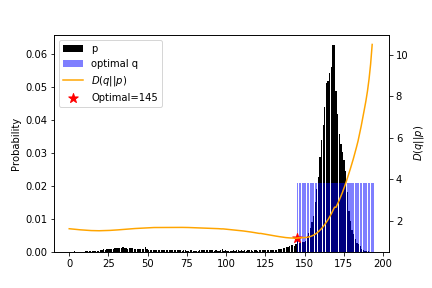

この結果を以下の図にしまします.

特徴としては,以下があります.

- 背景ノイズの推定に便利

- 分布が偏っていないと適用することができない.以下に,pythonコードを示します.

コード内では,「0log0」を回避するために,KL情報量を以下のような変形を行っていことに注意してください.$$

D(q(T)||p) = \sum_{i=1}^N q(T) \ln \frac{q(T)}{p}= -\ln M - \sum_{i=1}^N q(T) \ln p \

$$def InfoScore(data,thresh,bins=100): num_hist, range_hist = np.histogram(data, bins= bins) mean_hist = (range_hist[1:] + range_hist[:-1]) / 2 p = num_hist/num_hist.sum() N = p.shape[0] M = np.sum(mean_hist>thresh) if (M== 0): return np.inf q = np.zeros(N) q[mean_hist>thresh] = 1 / M Dqp = - np.log(M) - np.sum(q*np.log(p)) return Dqp # Callculation of Otsu score and analyze the optimal scores_info = np.zeros(256) for i in range(scores_info.shape[0]): scores_info[i] = InfoScore(data,i,bins = 190) thresh_info = np.argmin(scores_info)混合ガウスモデルのフィッティング

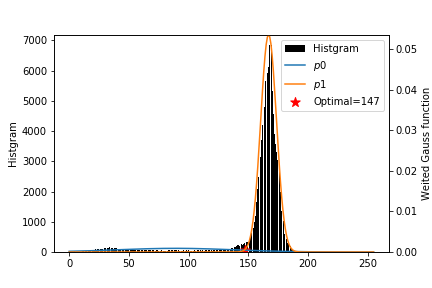

2つのクラスの分布がそれぞれガウス分布であることを仮定し,混合ガウス分布をフィッティンフする手法です.

2クラスのガウス分布であることが既知であり,データが十分にあるときのみの使用をオススメします.2つのガウス分布の交点がしきい値となります.

問題点として:

- ガウスの形状でない+long tailの場合はうまく推定できない.

- 初期値依存性があるという問題があります.

以下が結果とpythonコードになります.

pyhtonコードは勉強のためパッケージを使っていませんが,特に偏った心情がなければこちらをおつかいください.# def gaus func def gaus(x,mu,sigma2): return 1/np.sqrt(2 * np.pi * sigma2) *np.exp(-(x-mu)**2/(2*sigma2)) # Class Number M=2 # Optimmization Condition OPTIMIZE_EPS = 0.01 # Init y = data.copy() mu = 256*np.random.rand(M) sigma2 = 100*np.random.rand(M) w = np.random.rand(M) w = w / w.sum() for cycle in range(1000): # E step gamma_tmp = np.zeros((M,y.shape[0])) for i in range(M): gamma_tmp[i] = w[i] * gaus(y,mu[i],sigma2[i]) gamma = gamma_tmp/ gamma_tmp.sum(axis = 0).reshape(1,-1) Nk = gamma.sum(axis=1) # M step mus = (gamma * y).sum(axis = 1)/Nk sigma2s = (gamma *((y.reshape(1,-1)- mu.reshape(-1,1))**2)).sum(axis = 1)/Nk ws = Nk / Nk.sum() # check break condition if (np.linalg.norm(mu-mus)<OPTIMIZE_EPS)& (np.linalg.norm(sigma2-sigma2s)<OPTIMIZE_EPS) & (np.linalg.norm(w-ws)<OPTIMIZE_EPS): break # updata mu = mus sigma2 = sigma2s w = ws print(cycle) # make distribution x = np.arange(0,256,1) p = np.zeros((M,x.shape[0])) for i in range(M): p[i] = w[i] * gaus(x,mu[i],sigma2[i]) # find threshold if m[0]<m[1]: thresh_gaus = np.where(p[0]<p[1])[0].min() else: thresh_gaus = np.where(p[0]>p[1])[0].min()まとめ

上記の4つの手法を用いたしきい値は下の表の用になりました.

K-means Otsu Sezan KL divergence Gauss Fitting Threshold 109.0 109.0 90.558594 145.0 147.0 また,2値化画像は下の図のようになります.

どれがいいとは一概に良い言えませんので,状況に合わせて使い分けましょう!

とりあえず,この記事の上からオススメします.いくつかの論文は[5]を参考にしています.

よくまとまっていていい感じです.Code詳細

https://github.com/yuji0001/Threshold_Technic

Reference

[1] H, Steinhaus,“Sur la division des corps matériels en parties” (French). Bull. Acad. Polon. Sci. 4 (12): 801–804 (1957).

[2] Nobuyuki Otsu. "A threshold selection method from gray-level histograms". IEEE Trans. Sys. Man. Cyber. 9 (1): 62–66 (1979).

[3] M. I. Sezan, ‘‘A peak detection algorithm and its application to histogram-based image data reduction,’’ Graph. Models Image Process. 29, 47–59(1985).

[4] C. H. Li and C. K. Lee, ‘‘Minimum cross-entropy thresholding,’’ Pattern Recogn. 26, 617–625 (1993).

[5] Sezgin, M. Survey over image thresholding techniques and quantitative performance evaluation. Journal of Electronic Imaging, 13(1), 220(2004).

Author

Yuji Okamoto yuji.0001@gmail.com

- 投稿日:2020-02-18T18:37:36+09:00

Godはなんですか?簡単なチャットボットをpythonで作る

チャットボットはよく使われてます。この記事は自分がMediumのある記事を読んで、作ったチャットボットのメモである。オリジナルの記事はここだ:

https://medium.com/analytics-vidhya/building-a-simple-chatbot-in-python-using-nltk-7c8c8215ac6e

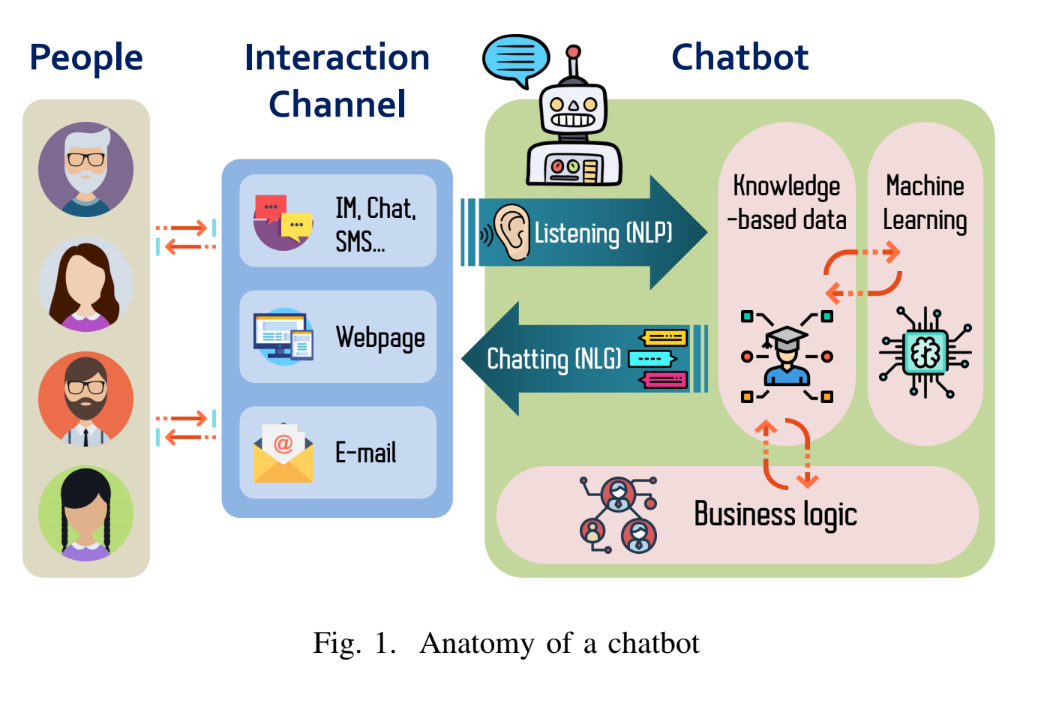

チャットボットはなんですか?

Chatbots are used in a variety of fields for different purposes, such as i) Support bots, designed to solve customer requests related to the delivery of a service or use of a product, and ii) Financial bots, aimed to resolve inquiries about financial services. Chatbots may have some constraints regarding the requests that they can respond and the vocabulary that they can employ, which depends on the specific domain where they are serving on. Furthermore, according to the Hype Cycle for emerging technologies by Gartner [2], conversational AI platforms remain in the phases of “innovation trigger” and “peak of inflated expectations”, meaning that they are getting substantial attention from the industry.

Besides the aforementioned use cases for chatbots, cybersecurity is one of the newest where to apply this technology. Thus, there exist chatbots focused on training end-users [3] or cyber analysts [4] in security awareness and incident response. Further, there are also malicious chatbots devoted to malware distribution through a human-machine conversation [5]. In addition, there is software designed to guide the user in terms of security and privacy, such as Artemis [6], a conversational interface to perform precision-guided analytics on endpoint data. Most of these security chatbots are implemented in a question-answering context [7] using a post-reply technique. As far as we know, the use of chatbots to profile suspects in an active way of child pornography has been little investigated, existing few approaches [8, 9] employing a chatbot to emulate a victim such as a child or a teenager. Likewise, our investigation aims to emulate a vulnerable person while the suspect offers him/her illegal content.

Building the chatbot

In this section, we'll cover NLP and NLG in this project.

- NLP — Natural Language “Processing”

- NLG — Natural Language “Generation”First, we'll need to import the relevant libraries:

import io import random import string # to process standard python strings import warnings import numpy as np from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.metrics.pairwise import cosine_similarity import warnings warnings.filterwarnings('ignore') import nltk from nltk.corpus import gutenberg from nltk.stem import WordNetLemmatizer nltk.download('popular', quiet=True) # for downloading packagesIf this is your first time using nltk, don't forget to run the following line and use the GUI to download all the packages.

nltk.download()Preprocessing

raw = gutenberg.raw('bible-kjv.txt') #Tokenisation sent_tokens = nltk.sent_tokenize(raw)# converts to list of sentences word_tokens = nltk.word_tokenize(raw)# converts to list of words # Preprocessing lemmer = WordNetLemmatizer() def LemTokens(tokens): return [lemmer.lemmatize(token) for token in tokens] remove_punct_dict = dict((ord(punct), None) for punct in string.punctuation) def LemNormalize(text): return LemTokens(nltk.word_tokenize(text.lower().translate(remove_punct_dict)))It doesn't really matter which corpus you use. Here I use the bible from gutenberg.

Keyword Matching

GREETING_INPUTS = ("hello", "hi", "greetings", "sup", "what's up","hey") GREETING_RESPONSES = ["hi", "hey", "*nods*", "hi there", "hello", "I am glad! You are talking to me"] def greeting(sentence): """If user's input is a greeting, return a greeting response""" for word in sentence.split(): if word.lower() in GREETING_INPUTS: return random.choice(GREETING_RESPONSES)Generating Response

TfidfVectorizer and cosine_similarity will be used to find the similarity between words entered by the user and the words in the corpus. This is the simplest possible implementation of a chatbot.

def response(user_response): robo_response='' sent_tokens.append(user_response) TfidfVec = TfidfVectorizer(tokenizer=LemNormalize, stop_words='english') tfidf = TfidfVec.fit_transform(sent_tokens) vals = cosine_similarity(tfidf[-1], tfidf) idx=vals.argsort()[0][-2] flat = vals.flatten() flat.sort() req_tfidf = flat[-2] if(req_tfidf==0): robo_response=robo_response+"I am sorry! I don't understand you" return robo_response else: robo_response = robo_response+sent_tokens[idx] return robo_responseStart and end of the conversation

flag=True print("ROBO: My name is Robo. I will answer your queries about Chatbots. If you want to exit, type Bye!") while(flag==True): user_response = input() user_response=user_response.lower() if(user_response!='bye'): if(user_response=='thanks' or user_response=='thank you' ): flag=False print("ROBO: You are welcome..") else: if(greeting(user_response)!=None): print("ROBO: "+greeting(user_response)) else: print("ROBO: ",end="") print(response(user_response)) sent_tokens.remove(user_response) else: flag=False print("ROBO: Bye! take care..")This approach is very basic for a chatbot as the response from the bot is simply based on keywords matching.

- 投稿日:2020-02-18T18:32:47+09:00

PPLM: 指定した属性をもった文章を生成するシンプルな Deep Learning 手法

はじめに

本記事は日鉄ソリューションズ(NSSOL)様でのインターンシップで執筆したものです.

本記事は以下の構成から成ります.

- 概要

- 本記事で解説するモデルPPLMについての大まかな説明をします.

- モデル構成

- PPLMのモデル概観についての解説をします.

- PPLMの Attribute Model の設計と学習

- PPLMの「小規模モデルの接続」というメインアイデアにおける,モデルの設計・学習の解説を実際のコードを交えながら行います.

- PPLMの実行

- 学習済のモデルを実行する際の処理の流れについて,実際のコードを交えながら解説を行います.

- テスト例

- 実際に生成した文章を紹介します.

- 改善点

- 本モデルについて,改善の余地があると思われる点について解説します.

概要

本記事で解説するモデルPPLMについて,大まかな解説をします.

Plug and Play Language Model とは

Plug and Play Language Model (以下PPLM) とは, PLUG AND PLAY LANGUAGE MODELS: A SIMPLE APPROACH TO CONTROLLED TEXT GENERATION で提案されたモデルになります.著者実装もGithubに存在します.

本研究は,controlled text generation というタスクに取り組んだ研究になります.controlled text generation とは,言語生成モデルが文章を生成する際,指定した属性(positive/negative といった極性や「政治」「科学」といったトピック)に合った文章を生成させるというタスクです.

PPLMの何がすごい?

PPLMのすごいところは,既存の言語生成モデルに対して,新たに小規模なモデルを学習するだけで controlled text generation を実現するというところにあります.

このすごさは既存手法と比較することでわかります.

controlled text generation に対する既存研究のアプローチは以下のように分類できます.

- 既存の言語生成モデルを属性1つ1つに対して別々にFine-tuning

- 既存のモデルは往々にして大規模なモデルであり,その再学習を属性の数だけ行うという膨大なコストがかかる

- Decodingの際にスコアを考慮する

- 生成文の自然さが損なわれがち

- そもそもこの手法で属性をコントロールするのは難しい

前者は属性のコントロールに関して十分な性能を発揮しますが,学習コストの面で大きな問題を抱えています.新しい属性を追加したいとなったとき,大規模なモデルを再び学習する必要があります.

後者は学習コスト面では問題ありませんが,性能が前者に比べ大きく劣るようです.

PPLMで提案される手法は,前者に匹敵する性能を維持しながらも,学習コストが非常に小さいという強みを持っています.モデル構成

PPLMはTransformerをDecoderとして用いた言語生成モデルを対象としたものになります.著者実装ではGPT-2を用いているため,今後はGPT-2の利用を前提として記述します.

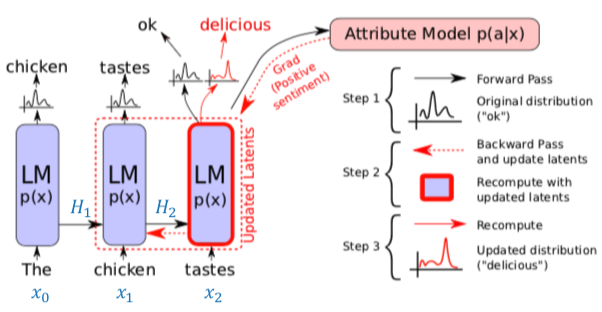

こちらはPPLMの原著論文 (https://openreview.net/pdf?id=H1edEyBKDS) より引用した図になります.ただし,青字($H_1, H_2, x_0, x_1, x_2$)は私が加筆したものです.

図中の黒矢印だけを見て, [Attribute Model p(a|x)] を無視すると元のTransformerのDecoderを用いたモデル(以降,オリジナルのモデルと呼称)となります.

図中のLM (Language Model) は Transformer の Decoder ブロックをl層積み上げたものです.

このl層のブロックそれぞれの中で発生する self-attention の Key, Value のペアを保持したものが$H_t$となります.つまり,$$H_t = [({K_t}^{(1)}, {V_t}^{(1)}), ... , ({K_t}^{(l)}, {V_t}^{(l)})]$$

ここで,${K_t}^{(i)}, {V_t}^{(i)}$はある時刻においてi層目のDecoderブロックによって作成された Key, Value のペアです.

オリジナルのモデルでは,前の時刻に出力した単語と共に,この$H_t$がLMに渡されます.つまり,

$$

o_{t+1}, H_{t+1} = \text{LM}(x_t, H_t)

$$

$o_{t+1}$ はLMからの出力であり,次のように行列 $W$ によって線形変換したのち,Softmax関数にかけて全単語の尤度の分布 $p_{t+1}$ が求まります. $x_{t+1}$ はこの分布に従います.

$$

x_{t+1} \sim p_{t+1} = \text{Softmax}(W o_{t+1})

$$

このようにして次々に単語を生成していくのがオリジナルのモデルになります.

ここからがPPLMの話になります.PPLMでは,接続した Attribute Model が $H_t$ を受け取り, $x_{t+1}$ が指定した属性 $a$ に対してどれだけ尤もらしいかを表す $p(a|x_{t+1})$ が大きくなるように $H_t$ を更新します.この $H_t$ を更新した $\tilde{H_t}$ をもとに新たに $\tilde{p_{t+1}}$ が計算されるため,単語の尤度の分布が変化します.図中においては,オリジナルのモデルから出力された $p_3$ では "ok" の尤度が高くなっていましたが, $\tilde{p_3}$ では "delicious" の尤度が高くなっている様子が描かれています.PPLMの Attribute Model の設計と学習

PPLMでは, Attribute Model $p(a|x)$ の構成に対して2つの手法が提唱されています.一方がBag-of-Wordsを利用するもの,もう一方が判別器によるものです.ここでは,これらについて実装コードを交えながら解説します.

Bag-of-Wordsによる Attribute Model

ここでは,事前に属性に関連するキーワードの集合を作成します.著者実装において用意されている属性には "computers", "fantasy", "kitchen", "legal", "military", "politics", "positive_words", "religion", "science", "space" があります.例えば "science" であれば, "astronomy", "atom", "biology", "cell", "chemical" など,48単語が用意されています.

ある属性 $a$ についてのキーワード集合 $\{ w_1, ... , w_k \}$ を用意したとき,オリジナルのモデルによって計算される単語の尤度の分布 $p_{t+1}$ を用いると,出力単語 $x_{t+1}$ が属性 $a$ に対してどれだけ尤もらしいかを表す $p(a|x_{t+1})$ は次のように考えることができます.

$$

p(a|x_{t+1}) = \sum_{i}^k p_{t+1}[w_i]

$$

この式の右辺が表すものは,キーワード集合に含まれる単語が出現する確率,つまり望んだ属性に関連する単語が出現する確率です.

原著論文には書いていませんが, $p(a|x_{t+1})$ (これは論文内では $p(a|x)$ と表記されています)を$p(a|p_{t+1})$ として,単語の尤度の分布がどれだけ属性 $a$ にふさわしいか,と捉えた方がわかりやすいかもしれません.

なお,後述の判別器とは違い,Bag-of-Wordsを利用した Attribute Model には学習パラメータが存在せず,学習は行いません判別器による Attribute Model

前述のBag-of-Wordsを利用した Attribute Model はシンプルな設計でしたが,問題があります.それは,属性をキーワードの集合のみで表すのが難しいケースがあるということです.そのような場合,本節で解説する判別器によるモデルが有用です.

属性の判別器は,出力単語 $x$ の属性 $a$ らしさを表す $p(a|x)$ を, self-attention の Key, Value のペア $H_t$ を利用して $p(a|H_t)$ と再解釈します.つまり, $H_t$ を入力として受け取り,属性 $a$ の尤度を返す判別器の学習を行います.

実装上ではこの判別器が返すものは,全属性に関しての尤度の分布の対数を取ったものになります.以下の実際のコードを見て行きましょう.run_pplm_discrim_train.pyclass Discriminator(torch.nn.Module): """Transformer encoder followed by a Classification Head""" def __init__( self, class_size, pretrained_model="gpt2-medium", cached_mode=False, device='cpu' ): super(Discriminator, self).__init__() self.tokenizer = GPT2Tokenizer.from_pretrained(pretrained_model) self.encoder = GPT2LMHeadModel.from_pretrained(pretrained_model) self.embed_size = self.encoder.transformer.config.hidden_size self.classifier_head = ClassificationHead( class_size=class_size, embed_size=self.embed_size ) self.cached_mode = cached_mode self.device = device def get_classifier(self): return self.classifier_head def train_custom(self): for param in self.encoder.parameters(): param.requires_grad = False self.classifier_head.train() def avg_representation(self, x): mask = x.ne(0).unsqueeze(2).repeat( 1, 1, self.embed_size ).float().to(self.device).detach() # maskはpaddingの0を無視するために利用 hidden, _ = self.encoder.transformer(x) masked_hidden = hidden * mask avg_hidden = torch.sum(masked_hidden, dim=1) / ( torch.sum(mask, dim=1).detach() + EPSILON ) return avg_hidden def forward(self, x): if self.cached_mode: avg_hidden = x.to(self.device) else: avg_hidden = self.avg_representation(x.to(self.device)) logits = self.classifier_head(avg_hidden) probs = F.log_softmax(logits, dim=-1) return probs class ClassificationHead(torch.nn.Module): """Classification Head for transformer encoders""" def __init__(self, class_size, embed_size): super(ClassificationHead, self).__init__() self.class_size = class_size self.embed_size = embed_size self.mlp = torch.nn.Linear(embed_size, class_size) def forward(self, hidden_state): logits = self.mlp(hidden_state) return logitsDiscriminator クラスは,事前学習済のモデルとこれから学習する ClassificationHead の2部から構成されます.学習済のモデルの再学習は一切行いません.なお,PPLMの実行時に $p(a|x)$ (より正確には $p(a|H_t)$)のモデルとして利用するのは ClassificationHead の部分のみになります.

Discriminator の処理の解説をします.入力xはミニバッチで,各単語をIDで表した文がバッチサイズ分並んだTensorになります.これが事前学習済モデルによって処理され,hiddenが出力されます.hidden, _ = self.encoder.transformer(x)この hidden は入力xの各単語を分散表現で表したようなものになっています.次に,この hidden には padding による余計な単語が Tensor のバッチ処理の関係上含まれているため,それを無視するために mask をかけます.こうすることで,padding によって追加された単語の分散表現が0になります(masked_hidden).最後に,この masked_hidden の各文中の分散表現を足し合わせることで avg_hidden が求まります.1つの文中の単語を足し合わせていると考えると,これは文を分散表現で表したものと解釈できます.この avg_hidden が ClassificationHead への入力となります.

ClassificationHead は中間層の存在しない,入力層と出力層のみのニューラルネットです.入力層のノード数はavg_hiddenの分散表現の次元数で,出力層のノード数は属性の数です.出力はロジットとなっており,これをソフトマックス関数に通してさらに対数をとります.logits = self.classifier_head(avg_hidden) probs = F.log_softmax(logits, dim=-1)このprobs (= output_t) の,正解クラス(target_t)に対応する値(負対数尤度)がlossとなり,このlossをbackpropして学習します.

loss = F.nll_loss(output_t, target_t) loss.backward(retain_graph=True) optimizer.step()PPLMの実行

前章の Attribute Model の学習を終えたら次は実際にPPLMの実行です.なお,実際には学習済の Attribute Model が用意されているため,動作を確認するだけならば改めて学習する必要はありません.また,Bag-of-Wordsによる Attribute Model を利用する場合も学習は必要ありません.

モデル構成で述べたように,PPLMではオリジナルのモデルの $H_t$ を更新した $\tilde{H_t}$ を用いることで出力単語をコントロールします.この更新は,実際には次のように行われます.\begin{align} \tilde{H_t} &= H_t + \Delta H_t \\ \Delta H_t & \leftarrow \Delta H_t + \alpha \frac{\nabla_{\Delta H_t} \log p(a | H_t + \Delta H_t)}{||\nabla_{\Delta H_t} \log p(a | H_t + \Delta H_t)||^{\gamma}} \end{align}$\alpha, \gamma$ はハイパーパラメータです.ここで行っているのは,属性 $a$ の尤度を高めるような更新 $\Delta H_t$ の計算です.この $\Delta H_t$ 自身は複数回計算して更新したのちに, $H_t$ に加算されます.この回数は3-10回だと言われています(実装コードでのデフォルト値は3).

この更新は run_pplm.py の perturb_past関数内で行われます.まず,Bag-of-Words を利用した Attribute Model による実装を見てみましょう.loss = 0.0 bow_logits = torch.mm(probs, torch.t(one_hot_bow)) bow_loss = -torch.log(torch.sum(bow_logits)) loss += bow_loss過程を省きましたが,probsは $p_{t+1}$ に相当するもので,言語モデルの知識にある全単語の尤度の分布です. one_hot_bow は属性のキーワード集合に属する各単語を,言語モデルの知識にある全単語に対する one-hot-vector で表したものです.これらを掛け合わせた bow_logits の和をとることは Bag-of-WordsによるAttribute Model に記した $\sum_{i}^k p_{t+1}[w_i]$ の計算に相当します.この和の負の対数を取ったものが bow_loss となります.この bow_loss は, $- \log p(a | H_t + \Delta H_t)$ に相当します.

次に,判別器を利用した Attribute Model による実装は以下のようになっています.

ce_loss = torch.nn.CrossEntropyLoss() prediction = classifier(new_accumulated_hidden / (curr_length + 1 + horizon_length)) label = torch.tensor(prediction.shape[0] * [class_label], device=device, dtype=torch.long) discrim_loss = ce_loss(prediction, label) loss += discrim_lossclassifier は前章で学習した,判別器の ClassificationHead の部分になります.new_accumulated_hidden の解説をします.GPT-2に対して更新した $\tilde{H_t}$ を与えて計算した,12層重ねたTransformerの最後の層から出力される隠れ状態を,判別器による Attribute Modelで解説したavg_hiddenと同様に分散表現を足し合わせたものを考えます.この計算を,未更新の $H_t$ についても同様に行い,これら2つを足し合わせたものが new_accumulated_hidden になります.このあたりは実際にコードを追いかけないとわからないかもしれませんが,隠れ状態を classifier に入力している,の認識程度でも大丈夫かもしれません.curr_length は現時点でのGPT-2に対する入力単語数, horizon_length は1がデフォルト値となっています(horizon_length 何の役割を担っているのかは本家の解説が薄くわかりません).

label に使われる class_label は run_pplm.py 実行時にユーザにより与えられるものです.例えば positive クラスに対して事前に割り当てたインデックスなどです.この label と prediction 間のクロスエントロピーロスを求めます.

このようにして計算した discrim_loss もまた,$- \log p(a | H_t + \Delta H_t)$ に相当します.

なお,Bag-of-Words と判別器による Attribute Model は併用できます.その場合は bow_loss と discrim_loss を足し合わせますloss = 0.0 loss += bow_loss loss += discrim_lossここまでで $\log p(a | H_t + \Delta H_t)$ の計算はできており( $\log p(a | H_t + \Delta H_t) = - \text{loss}$ ),あとは勾配を求めることで $\Delta H_t$ の更新が可能となりますが,これだけではうまくいきません.これまでに考えたきたことは, $p(a|x)$ (あるいは $p(a|H_t)$ )の値を大きくすることだけでした. $p(x)$ 自体については考慮していません.そのため,生成文が不自然なものになってしまう可能性が残ってしまいます.

この問題は,2つのアプローチにより解決されています.1つが, $p_{t+1}$ と $\tilde{p_{t+1}}$ 間の KL-Divergence, つまり

$$

\text{kl_loss} = \sum_i \tilde{p_{t+1}}[w_i] \log{ \frac{ \tilde{p_{t+1}}[w_i] }{ p_{t+1}[w_i] } }

$$

を小さくすることです.実装を見てみましょう.kl_loss = kl_scale * ( (corrected_probs * (corrected_probs / unpert_probs).log()).sum() ) loss += kl_lossここで, corrected_probs が $\tilde{p_{t+1}}$ ,unpert_probs が $p_{t+1}$ に当たります. kl_scale はハイパーパラメータで,基本的には0.01に設定すればいいようです.計算した kl_loss は, bow_loss や discrim_loss あるいはそれらの和にさらに加算されます. $\Delta H_t$ の更新時にすべてまとめて勾配方向に移動させる形です.

更新式の設計段階での対策は KL-Divergence のみです.もう1つのアプローチは, $\tilde{p_{t+1}}$ の計算後,実際に尤度にしたがって単語をサンプリングする際に行います.以下のようにサンプリングを行います.

$$

x_{t+1} \sim \frac{1}{\beta} \left( \tilde{p_{t+1}}^{\gamma_{gm}} {p_{t+1}}^{1-\gamma_{gm}} \right)

$$

このサンプリングが表すことは,更新した分布 $\tilde{p_{t+1}}$ だけでなく,更新前の $p_{t+1}$ も考慮したサンプリングを行うということです. $\beta$ は単なる確率分布として成立させるための正規化係数で, $\tilde{p_{t+1}}^{\gamma_{gm}} {p_{t+1}}^{1-\gamma_{gm}}$ の総和です. $\gamma_{gm}$ はハイパーパラメータで, $\gamma_{gm}$ を1に近づけると $\tilde{p_{t+1}}$ に近づき,0に近づけると $p_{t+1}$ に近づきます.実際には, $\gamma_{gm}$ は $0.8 \sim 0.95$ に設定するといいようです.つまり,更新後の分布は少し考慮するのみで,更新前の分布を重く考える,といった具合でしょうか.実装は以下のようになっています.pert_probs = ((pert_probs ** gm_scale) * (unpert_probs ** (1 - gm_scale))) pert_probs = top_k_filter(pert_probs, k=top_k, probs=True) if torch.sum(pert_probs) <= 1: pert_probs = pert_probs / torch.sum(pert_probs) if sample: last = torch.multinomial(pert_probs, num_samples=1) else: _, last = torch.topk(pert_probs, k=1, dim=-1)1行目で $\tilde{p_{t+1}}^{\gamma_{gm}} {p_{t+1}}^{1-\gamma_{gm}}$ を計算しています.2行目では,サンプリングする際に尤度の小さすぎる単語が出現しないよう,尤度上位k個の単語のみ残すようフィルタをかけています.3-4行目の操作が $\beta$ で割る操作です.6-7行目は尤度の分布にしたがってのサンプリングで,8-9行目が貪欲に最大尤度の単語をサンプリングする場合です.

以上が $H_t$ の更新およびサンプリングの工夫という,PPLMのアイデアになります.

テスト例

実際のテスト例を載せます.著者実装には2つの命令例が載せてあるため,それらを試します.

Bag-of-Words PPLMモデルの例

まず,Bag-of-Words を利用したPPLMについて.著者実装の以下の命令を試しに使います.

python run_pplm.py -B military --cond_text "The potato" --length 50 --gamma 1.5 --num_iterations 3 --num_samples 10 --stepsize 0.03 --window_length 5 --kl_scale 0.01 --gm_scale 0.99 --colorama --sample-Β military で military 属性の Bag-of-Words モデルを指定しています.結果がこちら.

Unperturbed generated text

<|endoftext|>The potato is probably the world's most widely eaten plant. But what if it's also the most dangerous?In the last two decades, there's been a dramatic decrease in potato crop damage from crop rot and disease. The decline, which started in

Perturbed generated text 1

<|endoftext|>The potato-flour soup that is the best way to start a weekend!

The following recipe is one of several that I have been working on over the past few months. I think it is the best of them. It uses all the elements of thePerturbed generated text 2

<|endoftext|>The potato bomb and the anti-Semitic attack that killed four Jewish students at a Jewish school in France are the most recent examples of bomb threats targeting Israeli facilities. The latest bomb threat targeting a U.S. nuclear facility, the bomb was sent out over thePerturbed generated text 3

<|endoftext|>The potato chip explosion has been a boon to the world's food industry since its release in late March. A handful of companies have already announced plans to produce chips using the chips, including Chipotle Mexican Grill Corp.'s parent company, Taco Bell Corp.'sPerturbed generated text 4

<|endoftext|>The potato is a very popular and delicious vegetable in many countries, but it can also cause severe health problems for people. The health of your body depends on your diet. If your diet doesn't include enough protein to get through the meal, or if you arePerturbed generated text 5

<|endoftext|>The potato plant, which is a member of the same family as wheat, can be found around the world. It's also used to make potato chips, bread, and other food products.The Plant

The plant grows as a seed and produces

Perturbed generated text 6

<|endoftext|>The potato bomb has been a controversial weapon for years. The device is packed with bomb-like devices and packed on a bomb-filled potato bomb. It's a bomb that detonates in the bomb-packed potato bomb and explodes in the potato bomb. SoPerturbed generated text 7

<|endoftext|>The potato has a lot in common with the human earworm: The first, and only, time you hear it, you'll hear the sound of the potato in your ear as well.It's the first sound you hear when your cat or dog

Perturbed generated text 8

<|endoftext|>The potato salad is coming to a restaurant near you!The new restaurant, in the heart of downtown Chicago, will be named the Potato Salad.

A photo posted by @the_mike_barnes on Aug 7, 2016 at

Perturbed generated text 9

<|endoftext|>The potato is a staple in many people's diet, and it is an easy food to make in your home.The best potato chips in the world are made by hand using only potatoes.

The potato is a staple in many people's diet

Perturbed generated text 10

<|endoftext|>The potato bomb is an improvised explosive device, typically containing one bomb and no more than 10 grams of explosive and containing no explosive material.Bombardment of an aircraft aircraft, a tank truck or explosive device

Bombardment of an aircraft aircraft

実行の際に指定した num_samples の数だけ独立に文を生成します(今回は10).赤字で強調しているのが属性に関連する語になります.これは実行時に --colorama を指定することで標準出力に赤字で表示させることができます.

生成例を見ていきましょう.まず,コントロールしていないオリジナルのモデルの生成文には military の要素は特に見られません.

コントロールした文に関しては,2, 6, 10に関しては "bomb" という単語がよく現れているのが見受けられます.ただ,他の例に関してはあまり military の文という印象は受けません.The potato から始まる military 属性の

文は少し難しかったのかもしれません.Discriminator PPLMモデルの例

属性の判別器を利用したモデルを試します.実行は著者実装の以下の文です.

python run_pplm.py -D sentiment --class_label 2 --cond_text "My dog died" --length 50 --gamma 1.0 --num_iterations 10 --num_samples 10 --stepsize 0.04 --kl_scale 0.01 --gm_scale 0.95 --sample結果がこちら.

Unperturbed generated text

<|endoftext|>My dog died in February, after suffering from severe arthritis. He had been suffering with a terrible cold that was causing his skin to break. I couldn't afford a replacement dog and couldn't afford to have him taken to the vet. I knew the vet would bePerturbed generated text 1

<|endoftext|>My dog died of a heart attack at the age of 88, his son said, and her death has shocked and brought closure to the family. (Published Wednesday, March 12, 2017)A mother who was found dead at home with a heart attack on

Perturbed generated text 2

<|endoftext|>My dog died from a rare and potentially deadly form of a rare form of sickle cell disease.A rare form of sickle cell is called hemizygaly in the families.

The family is an important part of the game and it's

Perturbed generated text 3

<|endoftext|>My dog died after being shot.A woman in the United States died after a man in his 20s opened fire at her home in North Carolina and injured several others.

On March 12 a neighbor heard a woman screaming. After she ran outside to

Perturbed generated text 4

<|endoftext|>My dog died of a heart attack, after suffering from a heart attack.The title text of this page has a a a

of

of the work and work in to be an in a way, that the idea of the idea to aPerturbed generated text 5

<|endoftext|>My dog died from a rare form of cancer that was not known before.The rare form of brain cancer called glioblastomatosis is more common in people of European descent. People of European descent are also at greater risk of glioma

Perturbed generated text 6

<|endoftext|>My dog died from anaphase and I don't know how to give birth to a child with a rare genetic condition, an important personal health gain, with health - "" " The " " " "'The'"'" The book " The wordPerturbed generated text 7

<|endoftext|>My dog died from a rare form of cancer, the Daily Mail reports.

"I have a really strong desire to help others and so I am happy to have the chance to help others to be happy and to love their loved ones and that's something I lovePerturbed generated text 8

<|endoftext|>My dog died because I didn't let him go.I have a 6-year-old, 3-year-old, 1-year-old, 2-year-old, and 2-year-old. I have a very active and

Perturbed generated text 9

<|endoftext|>My dog died of a heart attack while while while I was in the house. I had the old man's head and body, and a large one, I have my hands and feet with me. I have a good time, and the best, as I amPerturbed generated text 10

<|endoftext|>My dog died from a rare form of cancer, scientists have found.... James M. He he is is is is aA lot of a lot of a fun!! The Great Escape The Great Escape! The Great Escape! The Great Escape

Bag-of-Words のときとは違い,関連する単語の強調表示はできません.

-D sentiment で,事前に学習済の "sentiment" の判別器を指定しています.この判別器は "very_positive", "very_negative" の2つのクラスを判別する判別器で,今回指定している class_label=2 は, "very_positive" を表します.(なお, class_label=3 とすると "very_negative" を指定できます)."My dog died" というネガティブな文章しか生成されなさそうな始まりに対して,ポジティブな文を生成させようという例です.各例を見ていきましょう.

属性のコントロールをしていないオリジナルのモデルの生成文は悲観的な文章になっています.

コントロールした生成文に関しては,2, 5, 7などは比較的前向き(というよりネガティブさがない)文が生成されています.rare や love などの単語が目立ちます.1, 3, 4, 6, 8, 9, 10などはネガティブさが消えていなかったり,不自然な文になっていたりするため,文の始まりと属性が合わないと適切な生成が困難である様子が見て取れます.もう少し生成しやすそうな例を試す

上記の例は生成が難しそうな文の始まりと属性の組み合わせでした.もう少し文の始まりと属性を合わせてみましょう.始まりを The potato にして,属性を positive_words にします.

python run_pplm.py -B positive_words --cond_text "The potato" --length 50 --gamma 1.5 --num_iterations 3 --num_samples 10 --stepsize 0.03 --window_length 5 --kl_scale 0.01 --gm_scale 0.99 --colorama --sample結果がこちら.

Unperturbed generated text

<|endoftext|>The potato is probably the world's most widely eaten plant. But what if it's also the most dangerous?In the last two decades, there's been a dramatic decrease in potato crop damage from crop rot and disease. The decline, which started in

Perturbed generated text 1

<|endoftext|>The potato-like, gluten-free, low-calorie, sweet, and nutritious sweet potato pie recipe. Easy to make, and perfect for those who love to eat sweet, healthy, and filling pie!When my kids are home from school

Perturbed generated text 2

<|endoftext|>The potato has been a popular favorite since the 1980s. But with its recent popularity and rising popularity, is it time to eat your favorite potato again?The potato is still a great food to enjoy and enjoy, with its healthy benefits and delicious flavor

Perturbed generated text 3

<|endoftext|>The potato chip craze is in full swing.The popular snacks have been making the rounds in recent weeks as people seek out fresh and healthier alternatives to fried foods.

But there may have never been a better time to eat these crispy snacks than

Perturbed generated text 4

<|endoftext|>The potato is a very versatile, versatile vegetable and it is a great addition to many tasty salads, soups and stews.The potato is the star of many salads and stirfries. I love the versatility of potatoes in many recipes.

Perturbed generated text 5

<|endoftext|>The potato is a common dish, so much so in fact that it is often served with pasta. It is often served with rice, or topped with a sweet and savoury sauce.Serves 4

1 onion

2 cloves garlic

Perturbed generated text 6

<|endoftext|>The potato has become the new darling of American farmers in recent years. Its popularity is so great that it has even been featured in many successful television shows like "The Big Bang Theory".But there has never been an easier way to prepare your favorite snack

Perturbed generated text 7

<|endoftext|>The potato is a favorite among the health-conscious, so what better time to try a new way to eat them? The recipe below is easy and healthy, and you can easily freeze it, freeze it for later, reheat it for breakfast or lunch,Perturbed generated text 8

<|endoftext|>The potato salad that inspired the popular dish is one of a number of new varieties of the dish being sold at popular popular restaurants. (Photo: Thinkstock)When it comes to classic American comfort food, a popular dish that's popular around the country

Perturbed generated text 9

<|endoftext|>The potato is a staple in many people's diet, and it is not only delicious in its own right, but is also a good protein source. It is easy to eat, nutritious, and healthy.Potato, as we know it, originated

Perturbed generated text 10

<|endoftext|>The potato has been used as an ingredient in everything from salad dressing to soups for decades. However, it was once thought to be a poor performer in the kitchen. In recent years, scientists have shown potatoes to be a promising food source. The research shows最初のオリジナルの生成文は客観的な事実を述べているような文で,ポジティブな印象は特に受けません.他の文は,おおむねポジティブな文になっているのが見て取れます(2は何を言っているのかよくわからなかったり,3は better の前に never が付いてしまっていたりしますが...).

やはり,文の開始と属性の取り合わせはある程度考える必要がありそうです.これは,論文にも「属性によっては制御が難しい」と記されています.

改善点

実行時間が長い

今回の実験では,単語数50の文章を生成しました.その際,1つの文章を生成するのに,オリジナルのGPT-2による生成には2-3秒しかかかりませんが,Bag-of-Words によるモデルでは22秒ほど,判別器によるモデルでは95秒ほどかかっています.

利用タスクにも依存しますが,50単語程度の文を作成するのにこれほど時間がかかってしまうのがネックになります.学習するパラメータはオリジナルのモデルに比べると非常に少ないですが,ハイパーパラメータは $\Delta H_t$ を更新する際の $\alpha, \gamma$, KL-Divergenece kl_loss, $p_{t+1}$ と $\tilde{p_{t+1}}$ のバランスをとるための $\gamma_{gm}$ と多く,1回の実行に時間がかかりすぎるのはチューニングのコストに響いてしまうと考えられます.

この長さはおそらく, $H_t$ の更新時に偏微分の操作を何度も行っているのが原因だと私は考えています.普通のネットワークでは順方向に伝播していくだけで,そのような操作はありません.偏微分したりせずに, $H_t$ を入力すると $\tilde{H_t}$ が出力されるようなネットワークを構成・学習できればこの問題は解決できるかもしれません.Transformer 利用モデルに限定

本モデルのメインアイデアである $H_t$ の更新は, Transformer をデコーダとして利用している言語モデルに限る話になります.今後,違った構造が主流になるとこの手法は利用できない可能性があります.

まとめ

本記事では,Transformer をデコーダに用いたモデルで文を生成する際に,指定した属性に合った文章を生成する手法PPLMについて解説いたしました.

PPLMのメインアイデアは,外部接続したモデルにより,指定した属性の文を生成する方向に Transformer のself-attention の Key, Value を再帰的に更新すると言う考えです.この考えにより,オリジナルの大規模なモデルを再学習する必要なく属性の制御が可能になります.

テスト結果からは,おおむね制御できているものの,文の始まりと属性の相性が悪いと生成が困難である様子が見てとれました.また,実行時間がオリジナルのモデルに比べて長くなってしまう欠点もあります.参考文献

読んだもの

- PLUG AND PLAY LANGUAGE MODELS: A SIMPLE APPROACH TO CONTROLLED TEXT GENERATION

- 原著論文.平易な英語で書かれており,とても読みやすいため,興味があればぜひお読みください.

- Language Models are Unsupervised Multitask Learners

- GPT-2の原著論文.基本的なモデル構成についてはGPTの原著論文(後述)の方に書かれています.

- The Illustrated GPT-2 (Visualizing Transformer Language Models)

- GPT-2を懇切丁寧に図解した記事.非常にわかりやすいです.

- The Illustrated Transformer

- Transformer を懇切丁寧に図解した記事.非常にわかりやすいです.

- 作って理解する Transformer / Attention