- 投稿日:2020-01-04T23:43:31+09:00

言語処理100本ノック 2015をやったら結構Python基礎力がついた 第1章

はじめに

今更ですが、Pythonの勉強がてら言語処理100本ノック 2015をやってみました。最初は何も見ずにやってみて、その後、他の方の100本ノックの書き方を参考に、より良い(スマートな)書き方でやり直してみます。

より良い書き方の参考文献は最後にまとめて記載しています。

第1章: 準備運動

00. 文字列の逆順

文字列"stressed"の文字を逆に(末尾から先頭に向かって)並べた文字列を得よ.

コードinput_str = 'stressed' result = input_str[::-1] print(result)出力結果dessertsより良いコード

スライスのステップに負の値を設定すると末尾から見てくれる。これより大きく変わるのはなさそう。

01. 「パタトクカシーー」

「パタトクカシーー」という文字列の1,3,5,7文字目を取り出して連結した文字列を得よ.

コードinput_str = 'パタトクカシーー' result = '' for index, s in enumerate(input_str): if index % 2 == 0: result += s print(result)出力結果パトカーより良いコード

これもスライスでOK。

コードinput_str = 'パタトクカシーー' result = input_str[::2] print(result)02. 「パトカー」+「タクシー」=「パタトクカシーー」

「パトカー」+「タクシー」の文字を先頭から交互に連結して文字列「パタトクカシーー」を得よ.

コードp = 'パトカー' t = 'タクシー' result = '' for i in range(len(p)): result += p[i] result += t[i] print(result)出力結果パタトクカシーーより良いコード

['パタ', 'トク', 'カシ', 'ーー']というリストを作ってjoin()する。コードp = 'パトカー' t = 'タクシー' result = ''.join([char1 + char2 for char1, char2 in zip(p, t)]) print(result)03. 円周率

"Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics."という文を単語に分解し,各単語の(アルファベットの)文字数を先頭から出現順に並べたリストを作成せよ.

コードinput_str = 'Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics.' result = [] input_str = input_str.replace(',', '').replace('.', '').split(' ') for s in input_str: result.append(len(s)) print(result)出力結果[3, 1, 4, 1, 5, 9, 2, 6, 5, 3, 5, 8, 9, 7, 9]より良いコード

split()の引数はデフォルトで' 'のため指定不要。コードinput_str = 'Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics.' result = [] input_str = input_str.replace(',', '').replace('.', '').split() for s in input_str: result.append(len(s)) print(result)04. 元素記号

"Hi He Lied Because Boron Could Not Oxidize Fluorine. New Nations Might Also Sign Peace Security Clause. Arthur King Can."という文を単語に分解し,1, 5, 6, 7, 8, 9, 15, 16, 19番目の単語は先頭の1文字,それ以外の単語は先頭に2文字を取り出し,取り出した文字列から単語の位置(先頭から何番目の単語か)への連想配列(辞書型もしくはマップ型)を作成せよ.

コードinput_str = 'Hi He Lied Because Boron Could Not Oxidize Fluorine. New Nations Might Also Sign Peace Security Clause. Arthur King Can.' single_ary = [1, 5, 6, 7, 8, 9, 15, 16, 19] result = {} input_str = input_str.replace('.', '').split(' ') for index, s in enumerate(input_str): if index + 1 in single_ary: result[s[0]] = index else: result[s[0] + s[1]] = index print(result)出力結果{'H': 0, 'He': 1, 'Li': 2, 'Be': 3, 'B': 4, 'C': 5, 'N': 6, 'O': 7, 'F': 8, 'Ne': 9, 'Na': 10, 'Mi': 11, 'Al': 12, 'Si': 13, 'P': 14, 'S': 15, 'Cl': 16, 'Ar': 17, 'K': 18, 'Ca': 19}より良いコード

if文を三項演算子に。リストにaryって命名もよくなさそうなので修正。

コードinput_str = 'Hi He Lied Because Boron Could Not Oxidize Fluorine. New Nations Might Also Sign Peace Security Clause. Arthur King Can.' single_list = [1, 5, 6, 7, 8, 9, 15, 16, 19] result = {} input_str = input_str.split() for index, s in enumerate(input_str): l = 1 if index + 1 in single_list else 2 result[s[:l]] = index print(result)05. n-gram

与えられたシーケンス(文字列やリストなど)からn-gramを作る関数を作成せよ.この関数を用い,"I am an NLPer"という文から単語bi-gram,文字bi-gramを得よ.

コードinput_str = 'I am an NLPer' def create_word_n_gram(input_str, num): str_list = input_str.split(' ') results = [] for i in range(len(str_list) - num + 1): ngram = '' for j in range(num): ngram += str_list[j + i] results.append(ngram) return results def create_char_n_gram(input_str, num): str_no_space = input_str.replace(' ', '') results = [] for i in range(len(str_no_space) - num + 1): ngram = '' for j in range(num): ngram += str_no_space[j + i] results.append(ngram) return results print(create_word_n_gram(input_str, 2)) print(create_char_n_gram(input_str, 2))出力結果['Iam', 'aman', 'anNLPer'] ['Ia', 'am', 'ma', 'an', 'nN', 'NL', 'LP', 'Pe', 'er']より良いコード

文字n-gramはスペースも含む。ずっと勘違いしていた。。。

単語n-gramも出力形式がいけていないので修正。コードinput_str = 'I am an NLPer' def create_word_n_gram(input_str, num): str_list = input_str.split(' ') results = [] for i in range(len(str_list) - num + 1): results.append(str_list[i:i + num]) return results def create_char_n_gram(input_str, num): results = [] for i in range(len(input_str) - num + 1): results.append(input_str[i:i + num]) return results print(create_word_n_gram(input_str, 2)) print(create_char_n_gram(input_str, 2))出力結果[['I', 'am'], ['am', 'an'], ['an', 'NLPer']] ['I ', ' a', 'am', 'm ', ' a', 'an', 'n ', ' N', 'NL', 'LP', 'Pe', 'er']06. 集合

"paraparaparadise"と"paragraph"に含まれる文字bi-gramの集合を,それぞれ, XとYとして求め,XとYの和集合,積集合,差集合を求めよ.さらに,'se'というbi-gramがXおよびYに含まれるかどうかを調べよ.

コードinput_str_x = 'paraparaparadise' input_str_y = 'paragraph' word = 'se' def create_char_n_gram(input_str, num): str_no_space = input_str.replace(' ', '') results = [] for i in range(len(str_no_space) - num + 1): ngram = '' for j in range(num): ngram += str_no_space[j + i] results.append(ngram) return results def calculate_union(list_x, list_y): list_union = list(set(list_x + list_y)) return list_union def calculate_intersection(list_x, list_y): list_sum = list_x + list_y list_intersection = [elem for elem in set(list_sum) if list_sum.count(elem) > 1] return list_intersection def calculate_difference(list_x, list_y): list_intersection = calculate_intersection(list_x, list_y) list_sum = list_x + list_intersection list_difference = [elem for elem in set(list_sum) if list_sum.count(elem) == 1] return list_difference def check_including_word(word_list, word): if word in word_list: return True else: return False x = create_char_n_gram(input_str_x, 2) y = create_char_n_gram(input_str_y, 2) print(calculate_union(x, y)) print(calculate_intersection(x, y)) print(calculate_difference(x, y)) print(check_including_word(x, word)) print(check_including_word(y, word))出力結果['ar', 'ag', 'gr', 'is', 'ph', 'se', 'pa', 'di', 'ap', 'ad', 'ra'] ['ar', 'pa', 'ap', 'ra'] ['is', 'se', 'di', 'ad'] True Falseより良いコード

setにしてしまえば集合演算が可能。関数なんていらなかった・・・

チェック関数もかなり冗長。こっちは書いている最中に気付くべき。コードinput_str_x = 'paraparaparadise' input_str_y = 'paragraph' word = 'se' def create_char_n_gram(input_str, num): results = [] for i in range(len(input_str) - num + 1): results.append(input_str[i:i + num]) return results x = set(create_char_n_gram(input_str_x, 2)) y = set(create_char_n_gram(input_str_y, 2)) print(x | y) print(x - y) print(x & y) print(word in x) print(word in y)07. テンプレートによる文生成

引数x, y, zを受け取り「x時のyはz」という文字列を返す関数を実装せよ.さらに,x=12, y="気温", z=22.4として,実行結果を確認せよ.

コードx = 12 y = '気温' z = 22.4 def create_str(x, y, z): return str(x) + '時の' + y + 'は' + str(z) print(create_str(x, y, z))出力結果12時の気温は22.4より良いコード

文字列の足し方はいろいろあると思うが、これより大きく変わるのはなさそう。

08. 暗号文

与えられた文字列の各文字を,以下の仕様で変換する関数cipherを実装せよ.

英小文字ならば(219 - 文字コード)の文字に置換

その他の文字はそのまま出力

この関数を用い,英語のメッセージを暗号化・復号化せよ.コードinput_str = 'Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics.' def cipher(input_str): result = list(map(lambda e: chr(219 - ord(e)) if e.islower() else e, input_str)) return ''.join(result) print(cipher(input_str)) print(cipher(cipher(input_str)))出力結果Nld I mvvw z wirmp, zoxlslorx lu xlfihv, zugvi gsv svzeb ovxgfivh rmeloermt jfzmgfn nvxszmrxh. Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics.より良いコード

これより大きく変わるのはなさそう。

正しくは「復号化」ではなく「復号」。と思ったけど、今は「復号化」も普通に使われているらしい・・・※一瞬、同じ操作で暗号化と復号を両方やるのは不可能だと思ってしまったが、

219 - x = yなら、219 - y = xになるのは当然だった。219は他の数字でもよい。09. Typoglycemia

スペースで区切られた単語列に対して,各単語の先頭と末尾の文字は残し,それ以外の文字の順序をランダムに並び替えるプログラムを作成せよ.ただし,長さが4以下の単語は並び替えないこととする.適当な英語の文(例えば"I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind .")を与え,その実行結果を確認せよ.

コードimport random input_str = "I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind ." def create_typoglycemia(input_str): input_str_list = input_str.split(' ') result = [] for word in input_str_list: length = len(word) if length > 4: first_char = word[0] last_char = word[length - 1] random_str = ''.join(random.sample(list(word[1:length - 1]), length - 2)) result.append(word[0] + random_str + word[length - 1]) else: result.append(word) return ' '.join(result) print(create_typoglycemia(input_str))出力結果I cunldo't biveele that I culod aclatluy urdseanntd what I was rdineag : the pehaneomnl pewor of the huamn mind .より良いコード

定義したくせに一度しか使っていない変数や、定義したくせに全く使っていない変数を削除。

コードimport random input_str = "I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind ." def create_typoglycemia(input_str): result = [] for word in input_str.split(' '): length = len(word) if length > 4: random_str = ''.join(random.sample(word[1:length - 1], length - 2)) result.append(word[0] + random_str + word[length - 1]) else: result.append(word) return ' '.join(result) print(create_typoglycemia(input_str))おわりに

参考とさせていただいた、Qiitaに上がっている言語処理100本ノック2015(Python)の記事をまとめておきます。

- 投稿日:2020-01-04T23:34:29+09:00

Pythonによる AI・機械学習について学んだ内容(3)

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方scikit-learn

Python向けの機械学習フレームワークの定番

http://scikit-learn.org/次の特徴がある

- 機械学習で使われるさまざまなアルゴリズムに対応

- すぐに機械学習を試すことができるようにサンプルデータが含まれる

- 機械学習の結果を検証する機能を持っている

- 機械学習でよく使われる他のライブラリ(Pnadas, Numpy, scipy, Matplotlib etc)と親和性が高い

- BSDライセンスのオープンソースのため無料で商用利用可能

アルゴリズムを選択する

https://scikit-learn.org/stable/tutorial/machine_learning_map/index.html

どのような機械学習をしたいか、どのようなデータを準備しているのかなどの条件をたどっていくとアルゴリズムを選択できるようになっている。AND演算を機械学習する

and.py# ライブラリをインポートする from sklearn.svm import LinearSVC # LinearSVC アルゴリズムを利用するためのパッケージ(sklearn.svm.LinearSVC) from sklearn.metrics import accuracy_score # テスト結果を評価するためのパッケージ(sklearn.metrics.accuracy_score) #学習データを用意 learn_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # 学習用の入力データ(AND の入力値) learn_label = [0, 0, 0, 1] # 学習用の結果データ(AND の出力値) # アルゴリズムの指定 clf = LinearSVC() # 学習する(学習用の入力データと結果データを渡す) clf.fit(learn_data, learn_label) # 学習用の入力データと結果データを渡す # 学習を検証する test_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # テストデータの入力データを用意 test_label = clf.predict(test_data) # テストデータの結果を取得 # テストデータの結果を表示 print(test_data, "の予測結果", test_label) # 正解率を表示 Accuracy_rate= accuracy_score([0, 0, 0, 1], test_label) # accuracy_score(正解データ, テストの結果) print("正解率:", Accuracy_rate)[[0, 0], [1, 0], [0, 1], [1, 1]] の予測結果 [0 0 0 1] 正解率: 1.0AND論理演算を正しく学習している。

線形に分類できるものは、LinearSVCアルゴリズムで解決できる。

でも、XORは?使用される単語

SVM(Support Vector Machine)

「本当に予測に必要となる一部のデータ」のこと

このサイトがわかりやすいLinear SVM Classification ... 線形 SVM 分類

accuracy ... 精度・正確さ

classification ... 分類

classifier ... 分類器

fit ... 学習する(適合する)

predict ... 予測する

XOR演算を機械学習する

xor.py# ライブラリをインポートする from sklearn.svm import LinearSVC # LinearSVC アルゴリズムを利用するためのパッケージ(sklearn.svm.LinearSVC) from sklearn.metrics import accuracy_score # テスト結果を評価するためのパッケージ(sklearn.metrics.accuracy_score) #学習データを用意 learn_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # 学習用の入力データ(XORの入力値) learn_label = [0, 1, 1, 0] # 学習用の結果データ(XORの出力値) # アルゴリズムの指定 clf = LinearSVC() # 学習する(学習用の入力データと結果データを渡す) clf.fit(learn_data, learn_label) # 学習用の入力データと結果データを渡す # 学習を検証する test_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # テストデータの入力データを用意 test_label = clf.predict(test_data) # テストデータの結果を取得 # テストデータの結果を表示 print(test_data, "の予測結果", test_label) # 正解率を表示 Accuracy_rate= accuracy_score([0, 1, 1, 0], test_label) # accuracy_score(正解データ, テストの結果) print("正解率:", Accuracy_rate)[[0, 0], [1, 0], [0, 1], [1, 1]] の予測結果 [0 0 0 0] 正解率: 0.5うーん、線形では正しく分類できない。

xor2.py# ライブラリをインポートする from sklearn.neighbors import KNeighborsClassifier # LinearSVC アルゴリズムを利用するためのパッケージ(sklearn.svm.LinearSVC) from sklearn.metrics import accuracy_score # テスト結果を評価するためのパッケージ(sklearn.metrics.accuracy_score) #学習データを用意 learn_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # 学習用の入力データ(XORの入力値) learn_label = [0, 1, 1, 0] # 学習用の結果データ(XORの出力値) # アルゴリズムの指定 clf = KNeighborsClassifier(n_neighbors = 1) # 学習する(学習用の入力データと結果データを渡す) clf.fit(learn_data, learn_label) # 学習用の入力データと結果データを渡す # 学習を検証する test_data = [[0, 0], [1, 0], [0, 1], [1, 1]] # テストデータの入力データを用意 test_label = clf.predict(test_data) # テストデータの結果を取得 # テストデータの結果を表示 print(test_data, "の予測結果", test_label) # 正解率を表示 Accuracy_rate= accuracy_score([0, 1, 1, 0], test_label) # accuracy_score(正解データ, テストの結果) print("正解率:", Accuracy_rate)[[0, 0], [1, 0], [0, 1], [1, 1]] の予測結果 [0 1 1 0] 正解率: 1.0KNeighborsClassifierアルゴリズムを使うと学習できた。

- 投稿日:2020-01-04T22:47:38+09:00

Homebrewのエラー

Python update時、venvをリセットする時でたエラー

$ brew cleanupで下記のWarningがありました。

Warning: Skipping python: most recent version 3.7.6_1 not installed

アップデートします。

$ brew upgradeで下記のエラー...

Traceback (most recent call last):

4: from /usr/local/Homebrew/Library/Homebrew/brew.rb:23:in `<main>'

3: from /usr/local/Homebrew/Library/Homebrew/brew.rb:23:in `require_relative'

2: from /usr/local/Homebrew/Library/Homebrew/global.rb:13:in `<top (required)>'

1: from /System/Library/Frameworks/Ruby.framework/Versions/2.6/usr/lib/ruby/2.6.0/rubygems/core_ext/kernel_require.rb:54:in `require'

/System/Library/Frameworks/Ruby.framework/Versions/2.6/usr/lib/ruby/2.6.0/rubygems/core_ext/kernel_require.rb:54:in `require': cannot load such file -- active_support/core_ext/object/blank (LoadError)

$ brew update-resetでブランチのリセットとアップデート

==> Fetching /usr/local/Homebrew...

==> Resetting /usr/local/Homebrew...

Branch 'master' set up to track remote branch 'master' from 'origin'.

Reset branch 'master'

brew upgradeで問題なくアップデートしましたが、Warningもありました。

Warning: Building python from source:

The bottle needs the Apple Command Line Tools to be installed.

You can install them, if desired, with:

xcode-select --install

$ xcode-select --installでまだ下記のエラー...

xcode-select: note: install requested for command line developer tools以上で全部解決。

- 投稿日:2020-01-04T22:29:18+09:00

Python で初めての単回帰分析

単回帰分析の意味は調べればいくらでも出てきますが、自分で実際にプログラムを書いてみることで、理解が深まればいいかなと思い、Python を使って試してみたいと思っています。

一応、単回帰分析に対する説明としては、以下のような例があります。

1. 1つの目的変数(y)を1つの説明変数(x)で予測するもの。

2. それらの関係性を y = ax + b という一次方程式の形であらわす。

※ a は傾き、b は切片テスト環境は、(いつインストールしたかも覚えていない) Jupyter Notebook を使います。

使用したバージョンは以下です。The version of the notebook server is: 6.0.0 Python 3.7.3 (default, Mar 27 2019, 22:11:17) [GCC 7.3.0]pandas

pandas(パンダス、パンダズまたはパンダ)はデータを変換したり解析したりするためのライブラリ。

これを使って、データを読み込んでいきます。

使用したバージョンは以下です。import pandas as pd print(pd.__version__) # 0.24.2データ読み込み

今回は、48名分の身長(x)と体重(y)のデータ(sample.csv)を使用してみます。

sample.csvx,y 152,57 173,78 172,83 178,58 166,63 175,66 158,66 163,74 157,64 165,68 176,68 165,60 147,63 153,63 146,47 156,49 145,59 181,66 160,74 140,55 152,55 165,56 170,65 159,51 151,52 167,51 177,82 155,63 159,45 170,66 154,56 163,60 161,70 165,70 150,57 158,53 163,67 186,69 168,68 170,74 155,60 159,49 170,87 163,50 166,58 161,69 159,60 171,71sample.csv ファイルを読み込み、最初の3行を出力してみます。

以下のように読み込めているようです。df = pd.read_csv('sample.csv') df.head(3) x y 0 152 57 1 173 78 2 172 83pandas.read_csv でデータを読み込むと、DataFrame という型でデータが作成されるようです。

pandas.read_csv

DataFrameそれぞれの列データを変数x, y に格納しておきます。

x = df.x y = df.ymatplotlib

matplotlib(マットプロットリブ)は、グラフ描画ライブラリ。

使用したバージョンは以下です。import matplotlib matplotlib.__version__ # '3.1.0'グラフ描画

import matplotlib.pyplot as plt plt.plot(x, y) plt.show()全ての点が線でつながれたグラフが表示されました。

期待していたのは点だけが表示されているグラフでしたので、以下のように修正します。import matplotlib.pyplot as plt plt.plot(x, y, 'o') plt.show()scikit-learn

scikit-learn(サイキット・ラーン)は、科学技術計算を行うためのPythonパッケージ NumPy(ナンパイまたはナムパイ)と SciPy(サイパイ)の上で構築されている機械学習用ライブラリ。

使用したバージョンは以下です。import sklearn print(sklearn.__version__) # 0.21.2scikit-learn を使うことでお手軽に単回帰分析することが出来そうです。

LinearRegressionデータの学習

線形回帰モデル(LinearRegression)のインスタンスを生成し、データを学習(fit)させます。

from sklearn.linear_model import LinearRegression model = LinearRegression() model.fit(x, y) # ValueError: Expected 2D array, got 1D array instead:と思ったら、エラーが出てしまいました。2次元配列が必要なところ、1次元配列を与えているようです。

x, y の格納の仕方を変更して、改めて学習してみます。x = df[['x']] y = df[['y']]from sklearn.linear_model import LinearRegression model = LinearRegression() model.fit(x, y) # LinearRegression(copy_X=True, fit_intercept=True, n_jobs=None, normalize=False)今度は取り込んでくれたようです。

ここの部分は、元の x と y のままでも以下のように定義すれば動いてくれるはずです。# values で numpy.ndarray 型に変換し、np.reshape(-1, 1)でn行1列に変換する model.fit(x.values.reshape(-1,1), y.values.reshape(-1,1))データの予測

それでは予測(predict)させてみます。

plt.plot(x, y, 'o') plt.plot(x, model.predict(x), linestyle="solid") plt.show()

説明変数(x) から、目的変数(y) を予測した結果、右肩上がり(身長が増えるほど、体重が増える)の線が引かれました。この直線の"傾き"と"切片"については、それぞれ coef_ と intercept_ 属性が保持しているようですので、それらを出力してみると、直線の方程式を得ることができます。

print('y = %.2fx + %.2f' % (model.coef_ , model.intercept_)) # y = 0.52x + -20.94以上のことから、a(傾き)と b(切片)が分かることで、x(身長)から y(体重)を予測することができる、即ち"単回帰分析"が実現出来たということになります。

- 投稿日:2020-01-04T22:28:32+09:00

deeplearningで柴犬の写真からうちの子かどうか判定(2) データ増量・転移学習・ファインチューニング

はじめに

- こちらは私自身の機械学習やディープラーニングの勉強記録のアウトプットです。

- 前回のdeeplearningで柴犬の写真からうちの子かどうか判定(1)に引き続き、Google Colaboratoryで画像データの2種分類を行います。

- 様々なエラーでつまずいた箇所などもなるべく記述し、なるべく誰でも再現がしやすいように記載します。

この記事の対象者・参考にした文献

前回と同じです。詳細はこちら。

私について

- 現職は事務職。2019年9月にJDLA Deep Learning for Engeneer 2019#2を取得。

- 2020年4月からデータサイエンスの仕事にジョブチェンジをしたいと考え、転職活動を開始しました。 詳細はこちら。

前回(1)の分析の概要

- 愛犬(柴犬)の写真60枚、(愛犬以外の)柴犬の写真の写真を60枚、計120枚の画像ファイル(jpg)を集め、それらを deep learning で2分類しました。

- モデルを学習させて、テストデータで検証した結果、精度は75~76%程度に留まりました。

今回(2)の手順概要

手順1 分析データ量を増加し(写真を倍の枚数に増やす)、Google Driveにアップロード

手順2 Google Drive上に作業用フォルダを作成し、データを解凍、コピーする

手順3 モデル構築・学習・結果

手順4 ImageNetのモデル(VGG16)で転移学習

手順5 ImageNetのモデル(VGG16)でファインチューニング手順1 分析データ量を増加し(写真を倍の枚数に増やす)、Google Driveにアップロード

(1) 写真データの増量

前回の分析で、分類精度が7割台に留まった原因はいろいろあると思いますが、その最たるものは、やはり学習用データが60データと少量であったためであると思います。データを増やすのはなかなか大変ですが、今回の分類のため、写真の枚数を愛犬120枚、愛犬以外の柴120枚、計240枚に増量しました。このデータファイルを基に、再度分類を行います。

(2) Google drive内のデータ格納用フォルダを整備する

データファイルが増えた(120データ→240データ)ことにより、今回の分析を行う前に前回使用したデータファイルは一旦丸ごと削除して、新たに入れ替えることにします。そのため、具体的にはGoogle Drive上の操作で、"use_data"フォルダ内の赤字で示した"train","validation","test"の3つのフォルダについては、格納データごとすべて削除します。

(3) データファイルのアップロード

- "mydog2.zip" "otherdogs2.zip"の2つのzipファイルをGoogle Drive("original_data"フォルダ)にアップロードします。

- "mydog2.zip" "otherdogs2.zip"の2つのzipファイルについては、私のgithubに掲載しています。

手順2 Google Drive上に作業用フォルダを作成し、データを解凍、コピーする

- 今回はtrainデータに各60枚、validationデータに各30枚、testデータに各30枚を割り当てます。

- ここからはGoogle Colaboratoryを起動してColab上で操作していきます。

- 以下の内容は前回の実装と共通する部分が大半のため、ここでのコードについてはjupyternotebook形式で私のgithubに掲載しています。

- ファイル名:mydog_or_otherdogs2_1(120data_input320px).ipynb

注)ColaboratoryとGoogle Driveとの間の連携に関するタイムラグについて これは注意点というより、メモ書きに近いのですが、ColaboratoryとGoogle Driveとの連携にはタイムラグがあるように思います。安全に処理を実施するには、作業用フォルダ作成、コピー等の各処理は一気通貫に行うのではなく、ワンステップずつ、各処理が完了しているのを確認しながら進めたほうがよさそうだと思います。私の試行だと、ColaboratoryからGoogle Driveに命令を出した後、それが実際に反映するのにちょっと時間を要しています。そのため、タイミングにもよるかもしれませんが、反映前に次の処理を走らせるとエラーになる場合がありました。一気通貫でうまくいかない場合には、処理を何ステップかに分けて進めてみるとよいと思います。

手順3 モデル構築・学習・結果

(1) データオーギュメンテーションなしでの学習の結果

(2) テストデータへの適用(データオーギュメンテーションなし)

テストデータに適用した検証結果については次のとおりとなりました。サンプルデータ数を増やしたことが精度の向上につながり、accuracyも8割程度に到達しています。

test loss: 1.7524430536416669

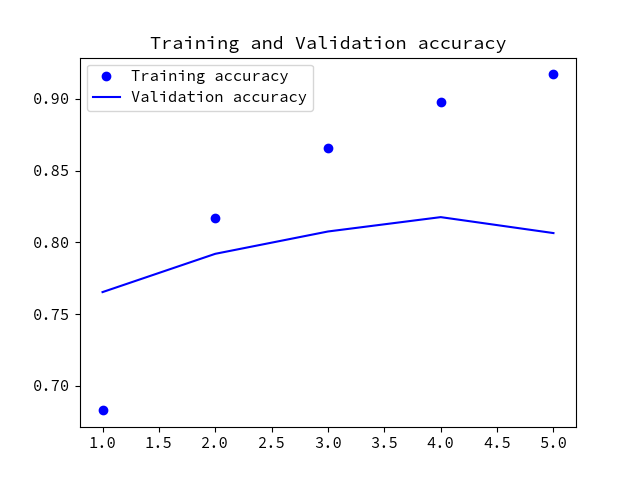

test acc: 0.8166666567325592(3) データオーギュメンテーションありでの学習の結果

続いてデータオーギュメンテーションありで学習させました。訓練の結果は、次のグラフのとおりとなりました。

(4) テストデータへの適用(データオーギュメンテーションあり)

次にImageGeneratorの設定を画像データの水増しありにした場合のテストデータの検証結果は次のとおりです(水増し条件は前回の試行の設定と同じで、結果表示のみ)。こちらの方がaccuracyがより高くなっています。

test loss: 1.382319548305386

test acc: 0.8666666634877522手順4 ImageNetのモデル(VGG16)で転移学習

今度は転移学習を実施します。代表的なモデルであるImageNetの学習済みモデル (VGG16) をkerasのライブラリからインポートして使用します。VGG16モデルからは、学習済み畳み込みベースのみを利用し、汎用性の高い局所的な特徴マップを抽出させます。その出力に「(柴犬用)うちの子-よその子」分類器を接続することで、分類精度の向上を図ります。

(1) VGG16について

- VGG16は、畳み込み13層、全結合層3層、計16層からなる多層ニューラルネットワーク。公開されているモデルはImageNetと呼ばれる大規模な画像セットを用いて訓練されたもの。

- Kerasのライブラリとして keras.applications.vgg16 モジュールに実装されている。

(2) モデルの読み込み

- 以下は、Google Drive内にデータの格納フォルダ、作業用フォルダが生成されており、分析用画像データが格納されていることを前提に進めて行きます。(これまでの分析環境そのままで実施します)

- 変数conv_baseにVGG16モデルを読み込みます。

# VGG16の読み込み from keras.applications import VGG16 conv_base = VGG16(weights='imagenet', # 重みの種類を指定(ここではImagenetで学習した重みを指定) include_top=False, # NWの出力側にある全結合分類器を含めるかどうか(ここでは自作の全結合分類器を使用するので含まない設定とする) input_shape=(320, 320, 3)) # NWに供給する画像テンソルの形状でImageNet標準は(224, 224 3) (今回は320pxl*320pxlのRGB画像を指定) conv_base.summary()読み込んだVGG16の該当部分について、次のようなモデル構造が表示されます。

Model: "vgg16" _________________________________________________________________ Layer (type) Output Shape Param # ================================================================= input_2 (InputLayer) (None, 320, 320, 3) 0 _________________________________________________________________ block1_conv1 (Conv2D) (None, 320, 320, 64) 1792 _________________________________________________________________ block1_conv2 (Conv2D) (None, 320, 320, 64) 36928 _________________________________________________________________ block1_pool (MaxPooling2D) (None, 160, 160, 64) 0 _________________________________________________________________ block2_conv1 (Conv2D) (None, 160, 160, 128) 73856 _________________________________________________________________ block2_conv2 (Conv2D) (None, 160, 160, 128) 147584 _________________________________________________________________ block2_pool (MaxPooling2D) (None, 80, 80, 128) 0 _________________________________________________________________ block3_conv1 (Conv2D) (None, 80, 80, 256) 295168 _________________________________________________________________ block3_conv2 (Conv2D) (None, 80, 80, 256) 590080 _________________________________________________________________ block3_conv3 (Conv2D) (None, 80, 80, 256) 590080 _________________________________________________________________ block3_pool (MaxPooling2D) (None, 40, 40, 256) 0 _________________________________________________________________ block4_conv1 (Conv2D) (None, 40, 40, 512) 1180160 _________________________________________________________________ block4_conv2 (Conv2D) (None, 40, 40, 512) 2359808 _________________________________________________________________ block4_conv3 (Conv2D) (None, 40, 40, 512) 2359808 _________________________________________________________________ block4_pool (MaxPooling2D) (None, 20, 20, 512) 0 _________________________________________________________________ block5_conv1 (Conv2D) (None, 20, 20, 512) 2359808 _________________________________________________________________ block5_conv2 (Conv2D) (None, 20, 20, 512) 2359808 _________________________________________________________________ block5_conv3 (Conv2D) (None, 20, 20, 512) 2359808 _________________________________________________________________ block5_pool (MaxPooling2D) (None, 10, 10, 512) 0 ================================================================= Total params: 14,714,688 Trainable params: 14,714,688 Non-trainable params: 0 _________________________________________________________________(3) モデルの構築

conv_baseに今回の2値分類用の全結合層を結合し、モデルを構築します。

from keras import models from keras import layers model = models.Sequential() model.add(conv_base) model.add(layers.Flatten()) model.add(layers.Dense(256, activation='relu')) model.add(layers.Dense(1, activation='sigmoid')) model.summary()次のようなモデル構造が表示されます。

Model: "sequential_1" _________________________________________________________________ Layer (type) Output Shape Param # ================================================================= vgg16 (Model) (None, 10, 10, 512) 14714688 _________________________________________________________________ flatten_1 (Flatten) (None, 51200) 0 _________________________________________________________________ dense_1 (Dense) (None, 256) 13107456 _________________________________________________________________ dense_2 (Dense) (None, 1) 257 ================================================================= Total params: 27,822,401 Trainable params: 27,822,401 Non-trainable params: 0 _________________________________________________________________(4) 訓練可能な重みの数を確認します

# conv_baseを凍結する前の状態で訓練可能な重みの数 print('conv_baseを凍結する前の状態で訓練可能な重みの数:' ,len(model.trainable_weights))実行すると「30」という結果が表示されます。

(5) conv_baseの重みのみを訓練不可能に設定し、設定結果を確認します

# conv_baseの重みのみ訓練不可能に設定する conv_base.trainable = False # 訓練可能な重みの数の確認 print('conv_base凍結後の状態で訓練可能な重みの数:' ,len(model.trainable_weights))実行すると、訓練可能な重みの数は「4」という結果に変更されて表示されます。このセットアップ状態でモデルの学習を実施します。

(5) 画像のテンソル化、学習

以下のコードで実施します。

from keras.preprocessing.image import ImageDataGenerator from keras import optimizers # trainデータのジェネレータ設定 水増し:あり train_datagen = ImageDataGenerator( rescale=1./255, rotation_range=40, width_shift_range=0.2, height_shift_range=0.2, shear_range=0.2, zoom_range=0.2, horizontal_flip=True, fill_mode='nearest') # validationデータ、testデータ用のジェネレータ設定 水増し:なし\(validationデータとtestデータのジェネレータは共通とする) test_datagen = ImageDataGenerator(rescale=1./255) # trainデータのテンソル化 train_generator = train_datagen.flow_from_directory( # target directory train_dir, # size 320x320 target_size=(320, 320), batch_size=20, # 損失関数としてbinary_crossentropyを使用するため、二値のラベルが必要 class_mode='binary') # validationデータのテンソル化 validation_generator = test_datagen.flow_from_directory( validation_dir, target_size=(320, 320), batch_size=32, class_mode='binary') # モデルのコンパイル model.compile(loss='binary_crossentropy', optimizer=optimizers.RMSprop(lr=2e-5), metrics=['acc']) # 学習 history = model.fit_generator( train_generator, steps_per_epoch=100, epochs=30, validation_data=validation_generator, validation_steps=50, verbose=2)実行後のモデルは保存します。

model.save('mydog_or_otherdogs_02a.h5')(6) 実行結果

- 訓練結果のグラフは次のとおりです。

グラフの形状に変化が出てきました。accuracyは0.88あたりで始まり、0.93から0.96あたりまで改善しています。lossは0.3あたりから始まり、0.1から0.2の範囲を推移しています。過学習状態から少し改善の兆候が出てきました。

続いて、テストデータでこのモデルの分類結果を検証します。(コードは前回記事を参照)

test loss: 0.274524162985399

test acc: 0.9333333373069763転移学習の結果、分類性能は改善しています。accuracyが初めて9割を超えました。

この試行では、畳み込みベースにVGG16の学習済みモジュールのみを使用しましたが、ImageNetでのトレーニングにより得られた汎用性の高い局所的な特徴マップの抽出能力が、分類性能に大きく貢献しているであろうことが確認できます。

手順5 ImageNetのモデル(VGG16)でファインチューニング

(1) ファインチューニングの概要

ファインチューニングは特徴抽出に使用される凍結された畳み込みベースの出力側の層をいくつか解凍し、モデルの新しく追加された部分(この場合は全結合分類器)と解凍した層の両方で訓練を行う、という仕組みになっています。

(2) ファインチューニングの実施手順

- 訓練済みのベースネットワークの最後にカスタムネットワークを追加する

- ベースネットワークを凍結する

- 追加した部分の学習を行う

- ベースネットワークの一部の層を解凍する

- 解凍した層と追加した部分の訓練を同時に行う

※(1)(2)の記載については、『PythonとKerasによるディープラーニング』Francois Chollet著 株式会社クイープ訳 巣籠悠輔監訳 株式会社マイナビ出版刊より、該当部分を引用

(3) 訓練可能な重みの設定

- 次のコードでファインチューニングの実施に際して訓練可能な重みを設定します。

- block5_conv1, block5_conv2, block5_conv3の3つの層のみ、訓練可能に設定します。

conv_base.trainable = True set_trainable = False for layer in conv_base.layers: if layer.name == 'block5_conv1': set_trainable = True if set_trainable: layer.trainable = True else: layer.trainable = False(4) ファインチューニングの実行

次のコードで学習をさせます。

# オプティマイザにRMSpropを選択し、かなり低い設定の学習率を使用 # 更新値が大きいとファインチューニングの対象層3つの表現を傷つけてしまうため model.compile(loss='binary_crossentropy', optimizer=optimizers.RMSprop(lr=1e-5), metrics=['acc']) history = model.fit_generator( train_generator, steps_per_epoch=100, epochs=100, validation_data=validation_generator, validation_steps=50)訓練後のモデルは保存します。

model.save('mydog_or_otherdogs_02b.h5')(5) 結果グラフ

結果のグラフは次のとおりです。

次のコードでグラフのスムース化を行います。# プロットのスムージング def smooth_curve(points, factor=0.8): smoothed_points = [] for point in points: if smoothed_points: previous = smoothed_points[-1] smoothed_points.append(previous * factor + point * (1 - factor)) else: smoothed_points.append(point) return smoothed_points plt.plot(epochs, smooth_curve(acc), 'bo', label='Smoothed training acc') plt.plot(epochs, smooth_curve(val_acc), 'b', label='Smoothed validation acc') plt.title('Training and validation accuracy') plt.legend() plt.figure() plt.plot(epochs, smooth_curve(loss), 'bo', label='Smoothed training loss') plt.plot(epochs, smooth_curve(val_loss), 'b', label='Smoothed validation loss') plt.title('Training and validation loss') plt.legend() plt.show()グラフは次のとおりとなります。validationの状況を見ると、エポックの回数が増えるごとに性能が上がっている様子ではないものの、以前に比べて、グラフの変化の幅がより狭い範囲で表示されているため、精度が改善されていることが期待できます。

(6) 学習済みモデルをテストデータに適用して分類精度を確認します

テストデータに適用した検証結果については次のとおりとなりました。

test loss: 0.5482699687112941

test acc: 0.9499999916553498ファインチューニングの結果、分類性能をさらに向上させることができました。さらなる精度の向上へ向けて、まだ試していないアプローチもいろいろ実施してみたいところです。今回の検証ではここまでで一区切りとします。

- 投稿日:2020-01-04T22:14:07+09:00

[kotlin] アンドロイドで画像分類をする(Pytorch Mobile)

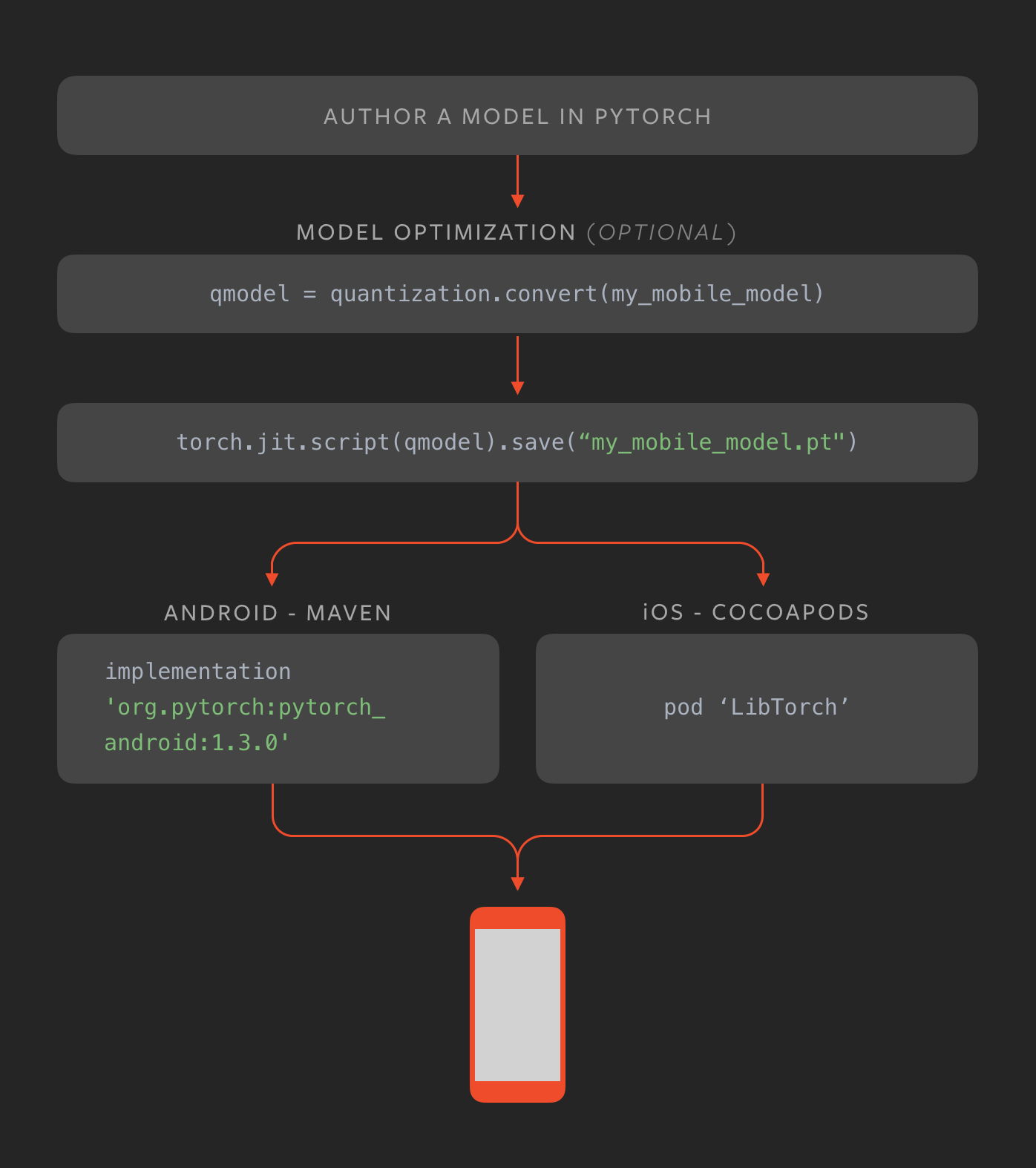

PyTorch Mobile

去年(2019年)の10月くらいに出た。Tensolflow Liteとかではandroid iosでも機械学習ができたが、やっとpytorch 1.3からモバイル向けが登場した。tensorflow よりpytorch使う側からすると最高だね!

tensorflow Liteと同様にandroid ios で利用できるようになっている。詳細はこちら

PyTorch Mobile公式サイト : https://pytorch.org/mobile/home/今回やること

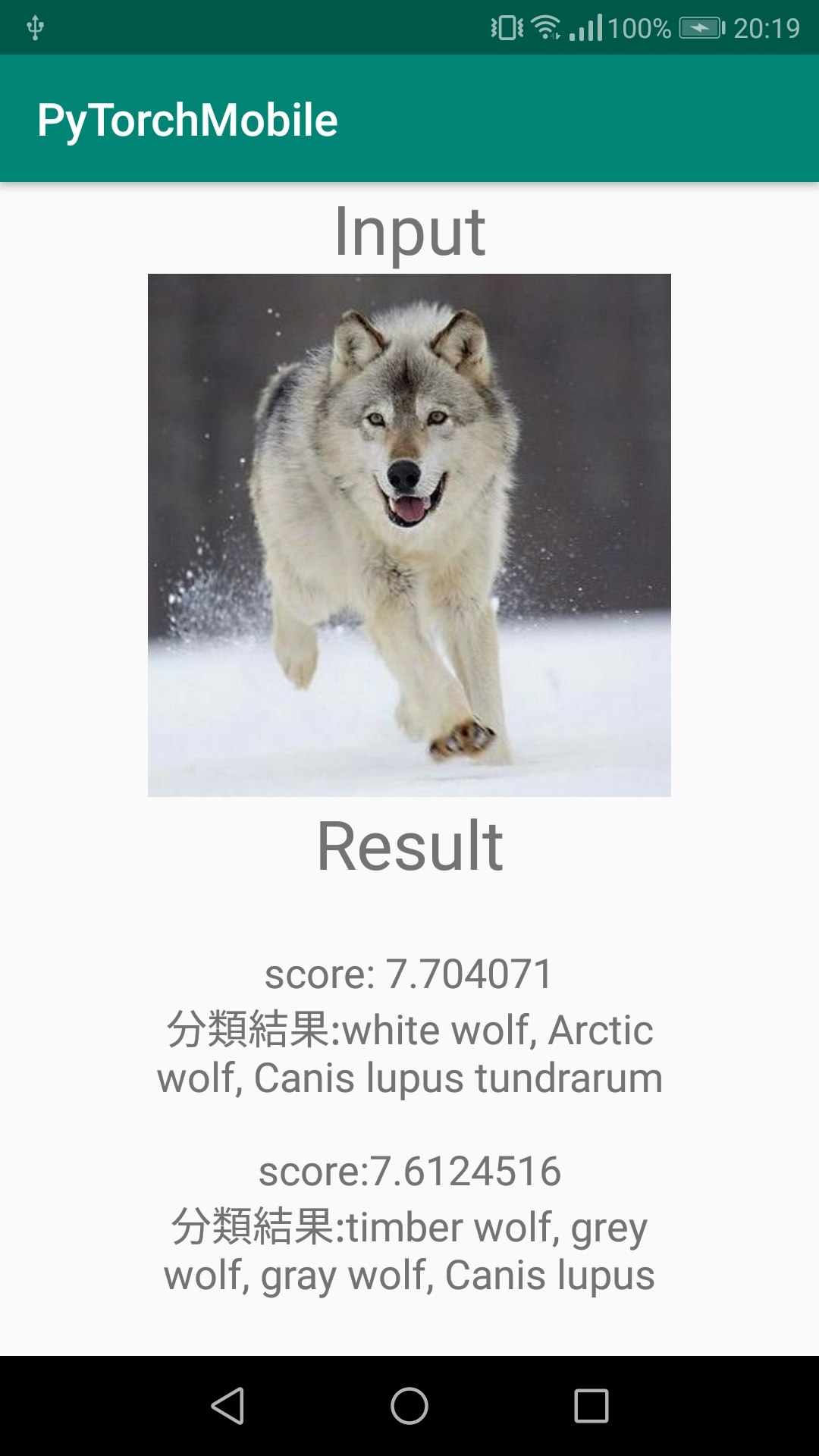

公式サイトで紹介されているチュートリアルをやる。Kotlinで書く!

resNetの学習済みモデルを使って画像の分類を行う。(推論のみ)github載せてます https://github.com/SY-BETA/PyTorchMobile

こんな感じ ↓

分類する画像と上位二つの分類結果とそのスコアを表示するだけの簡単なもの。(Canis lupusってなんだろ?)必要なもの

- python の実行環境 (自分はjupyter notebookでやった)

- pytorch, torchVision(最新版推奨)

- android studio

こんだけ

ResNetモデルのダウンロード

まずandroid studio で新規プロジェクトを作成する。

そのプロジェクトにassetsフォルダを作成する。(「UI左のapp右クリック-> 新規 -> フォルダ -> assetsフォルダ」 でできる)

作成したらそのプロジェクトのappフォルダと同じ階層で以下のpythonコードを実行するcreateModel.pyimport torch import torchvision # resnetモデルを利用 model = torchvision.models.resnet18(pretrained=True) # 推論modeに model.eval() example = torch.rand(1, 3, 224, 224) traced_script_module = torch.jit.trace(model, example) traced_script_module.save("app/src/main/assets/resnet.pt")うまく実行できると先ほど作ったassetsフォルダに

resnet.ptというファイルが追加される。assetsフォルダとdrawableフォルダに以下のサンプル画像を

image.jpgの名前で保存する

実装

依存関係

gradleに以下を追加(2020年1月4日時点)

dependencies { implementation 'org.pytorch:pytorch_android:1.3.0' implementation 'org.pytorch:pytorch_android_torchvision:1.3.0' }android studio でレイアウトを作る

適当にレイアウト作成

縦に画像が1個とテキストが6個あるだけのレイアウトactivity_main.xml<?xml version="1.0" encoding="utf-8"?> <androidx.constraintlayout.widget.ConstraintLayout xmlns:android="http://schemas.android.com/apk/res/android" xmlns:app="http://schemas.android.com/apk/res-auto" xmlns:tools="http://schemas.android.com/tools" android:layout_width="match_parent" android:layout_height="match_parent" tools:context=".MainActivity"> <TextView android:id="@+id/textView" android:layout_width="wrap_content" android:layout_height="wrap_content" android:text="Input" android:textSize="30sp" app:layout_constraintEnd_toEndOf="parent" app:layout_constraintStart_toStartOf="parent" app:layout_constraintTop_toTopOf="parent" /> <ImageView android:id="@+id/imageView" android:layout_width="wrap_content" android:layout_height="230dp" android:scaleType="fitCenter" app:layout_constraintEnd_toEndOf="parent" app:layout_constraintStart_toStartOf="parent" app:layout_constraintTop_toBottomOf="@+id/textView" app:srcCompat="@drawable/image" /> <TextView android:id="@+id/textView2" android:layout_width="wrap_content" android:layout_height="wrap_content" android:text="Result" android:textSize="30sp" app:layout_constraintEnd_toEndOf="parent" app:layout_constraintStart_toStartOf="parent" app:layout_constraintTop_toBottomOf="@+id/imageView" /> <TextView android:id="@+id/result1Score" android:layout_width="wrap_content" android:layout_height="wrap_content" android:layout_marginTop="32dp" android:text="TextView" android:textSize="18sp" app:layout_constraintBottom_toTopOf="@+id/result1Class" app:layout_constraintEnd_toEndOf="parent" app:layout_constraintHorizontal_bias="0.5" app:layout_constraintStart_toStartOf="parent" app:layout_constraintTop_toBottomOf="@+id/textView2" /> <TextView android:id="@+id/result1Class" android:layout_width="250dp" android:layout_height="wrap_content" android:layout_marginStart="40dp" android:layout_marginTop="8dp" android:layout_marginEnd="40dp" android:gravity="center" android:text="TextView" android:textSize="18sp" app:layout_constraintBottom_toTopOf="@+id/result2Score" app:layout_constraintEnd_toEndOf="@+id/result1Score" app:layout_constraintHorizontal_bias="0.5" app:layout_constraintStart_toStartOf="@+id/result1Score" app:layout_constraintTop_toBottomOf="@+id/result1Score" /> <TextView android:id="@+id/result2Score" android:layout_width="wrap_content" android:layout_height="wrap_content" android:layout_marginTop="24dp" android:text="TextView" android:textSize="18sp" app:layout_constraintBottom_toTopOf="@+id/result2Class" app:layout_constraintEnd_toEndOf="parent" app:layout_constraintHorizontal_bias="0.5" app:layout_constraintStart_toStartOf="parent" app:layout_constraintTop_toBottomOf="@+id/result1Class" app:layout_constraintVertical_bias="0.94" /> <TextView android:id="@+id/result2Class" android:layout_width="250dp" android:layout_height="wrap_content" android:layout_marginStart="40dp" android:layout_marginTop="8dp" android:layout_marginEnd="40dp" android:layout_marginBottom="32dp" android:gravity="center" android:text="TextView" android:textSize="18sp" app:layout_constraintBottom_toBottomOf="parent" app:layout_constraintEnd_toEndOf="@+id/result2Score" app:layout_constraintHorizontal_bias="0.5" app:layout_constraintStart_toStartOf="@+id/result2Score" app:layout_constraintTop_toBottomOf="@+id/result2Score" /> </androidx.constraintlayout.widget.ConstraintLayout>モデルのロード

先に作成した

resnet.ptをロードするMainActivity.ktoverride fun onCreate(savedInstanceState: Bundle?) { super.onCreate(savedInstanceState) setContentView(R.layout.activity_main) //// assetファイルからパスを取得する関数 fun assetFilePath(context: Context, assetName: String): String { val file = File(context.filesDir, assetName) if (file.exists() && file.length() > 0) { return file.absolutePath } context.assets.open(assetName).use { inputStream -> FileOutputStream(file).use { outputStream -> val buffer = ByteArray(4 * 1024) var read: Int while (inputStream.read(buffer).also { read = it } != -1) { outputStream.write(buffer, 0, read) } outputStream.flush() } return file.absolutePath } } /// モデルと画像をロード /// シリアル化されたモデルをロード val bitmap = BitmapFactory.decodeStream(assets.open("image.jpg")) val module = Module.load(assetFilePath(this, "resnet.pt")) }assetsフォルダから画像やモデルをロードするのは結構面倒な書き方をするので注意

推論

dependenciesに追加したモジュールとresnetを使ってサンプル画像を入力して結果を出力する

MainActivity.kt/// テンソルに変換 val inputTensor = TensorImageUtils.bitmapToFloat32Tensor( bitmap, TensorImageUtils.TORCHVISION_NORM_MEAN_RGB, TensorImageUtils.TORCHVISION_NORM_STD_RGB ) /// 推論とその結果 /// フォワードプロパゲーション val outputTensor = module.forward(IValue.from(inputTensor)).toTensor() val scores = outputTensor.dataAsFloatArray推論結果

上位のscoreを取り出す

MainActivity.kt/// scoreを格納する変数 var maxScore: Float = 0F var maxScoreIdx = -1 var maxSecondScore: Float = 0F var maxSecondScoreIdx = -1 /// scoreが高いものを上から2個とる for (i in scores.indices) { if (scores[i] > maxScore) { maxSecondScore = maxScore maxSecondScoreIdx = maxScoreIdx maxScore = scores[i] maxScoreIdx = i } }分類クラス

分類するクラスの名前

すごく長いので省略 (imageNetの1000クラス分類のアレです)

githubに載せてるのでImageNetClasses.ktの中身をコピペしてくださいgithub クラス名リスト(ImageNetClasses.kt)

ImageNetClasses.ktclass ImageNetClasses { var IMAGENET_CLASSES = arrayOf( "tench, Tinca tinca", "goldfish, Carassius auratus", //~~~~~~~~~~~~~~略(githubからコピペしてください)~~~~~~~~~~~~~~~~// "toilet tissue, toilet paper, bathroom tissue" ) }結果を表示

インデックスから推論したクラス名を取得し、

最後に推論結果をレイアウトに表示するMainActivity.kt/// インデックスから分類したクラス名を取得 val className = ImageNetClasses().IMAGENET_CLASSES[maxScoreIdx] val className2 = ImageNetClasses().IMAGENET_CLASSES[maxSecondScoreIdx] result1Score.text = "score: $maxScore" result1Class.text = "分類結果:$className" result2Score.text = "score:$maxSecondScore" result2Class.text = "分類結果:$className2"完了!!ビルドすれば冒頭のような画面ができるはず。

いろんな写真入れて遊んでみてください。おわり

ライブラリって便利。画像分類がこんだけでできるとは。

tensorに変換とかが少しひっかかるなって感じだったけど、これでpytorchでもandroid に使えるようになった。

あと余談で、最初pytorchのバージョンが最新じゃなくてモデルのロードのときエラー出て全くできかったところと、assetsフォルダのパスの取得で結構ハマった。

- 投稿日:2020-01-04T22:04:42+09:00

Pythonによる AI・機械学習について学んでいます(2)

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-4 Google Colaboratory

Google が提供している Colaboratory を使うとインストール不要で機械学習の開発を始めることができます。必要なのは、HTML5に対応したWebブラウザだけです!

Colaboratory を使うメリット

Python 環境をインストール不要、最初からよく使うライブラリの一式がインストール済み。

サーバのOS は、Ubuntu(Linux)なのでUbuntuで動作するツールやライブラリであれば自由にインストールして使用可能。

仕組みは、Colaboratoryのサーバで計算が行われ、結果だけがWebブラウザに返されて表示される。Google Colaboratory を開く

https://colab.research.google.com/

GPUをアサイン

メニュー ランタイム > ランタイムのタイプを変更 で、 ノートブックの設定 を開く

ハードウェア・アクセラレータに GPU を選択し 保存 するどんなサーバーなの?

次のコマンドを実行するとわかるよ

- !cat /proc/cpuinfo

- !cat /proc/meminfo

- !cat /etc/issue

- !df -h

- !free -h

- !cat /proc/cpuinfo

- !nvcc -v

- !nvidia-smi

Sat Jan 4 12:04:20 2020 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 440.44 Driver Version: 418.67 CUDA Version: 10.1 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | |===============================+======================+======================| | 0 Tesla T4 Off | 00000000:00:04.0 Off | 0 | | N/A 37C P8 9W / 70W | 0MiB / 15079MiB | 0% Default | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | Processes: GPU Memory | | GPU PID Type Process name Usage | |=============================================================================| | No running processes found | +-----------------------------------------------------------------------------+Tesla T4だって!

AI専用サーバーを構築しようと思ったけどやめました。制約

- 最大利用時間は12時間

- 最大利用時間を超えると全部初期化されて消えてしまう

Google Drive をマウントするといい

Colaboratory の左にある > からドライブをマウントをクリックすると Google Drive を

/content/drive/My Drive/ 以下にマウントすることができる。

必要なファイルは、Google Drive にアップロードすればすぐにみられる。

12時間を超えてもちゃんとファイルは保存されてる。ディレクトリの移動は、cd で行える。

ちなみに ls ll などのコマンドも使える。ちょっとグラフを描いてみる

import numpy as np import matplotlib.pyplot as plt x = np.arange(0, 10, 0.1) y = np.sin(x) plt.plot(x, y) plt.show()

- 投稿日:2020-01-04T22:04:42+09:00

Pythonによる AI・機械学習について学んだ内容(2)

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-4 Google Colaboratory

Google が提供している Colaboratory を使うとインストール不要で機械学習の開発を始めることができます。必要なのは、HTML5に対応したWebブラウザだけです!

Colaboratory を使うメリット

Python 環境をインストール不要、最初からよく使うライブラリの一式がインストール済み。

サーバのOS は、Ubuntu(Linux)なのでUbuntuで動作するツールやライブラリであれば自由にインストールして使用可能。

仕組みは、Colaboratoryのサーバで計算が行われ、結果だけがWebブラウザに返されて表示される。Google Colaboratory を開く

https://colab.research.google.com/

GPUをアサイン

メニュー ランタイム > ランタイムのタイプを変更 で、 ノートブックの設定 を開く

ハードウェア・アクセラレータに GPU を選択し 保存 するどんなサーバーなの?

次のコマンドを実行するとわかるよ

- !cat /proc/cpuinfo

- !cat /proc/meminfo

- !cat /etc/issue

- !df -h

- !free -h

- !cat /proc/cpuinfo

- !nvcc -v

- !nvidia-smi

Sat Jan 4 12:04:20 2020 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 440.44 Driver Version: 418.67 CUDA Version: 10.1 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | |===============================+======================+======================| | 0 Tesla T4 Off | 00000000:00:04.0 Off | 0 | | N/A 37C P8 9W / 70W | 0MiB / 15079MiB | 0% Default | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | Processes: GPU Memory | | GPU PID Type Process name Usage | |=============================================================================| | No running processes found | +-----------------------------------------------------------------------------+Tesla T4だって!

AI専用サーバーを構築しようと思ったけどやめました。制約

- 最大利用時間は12時間

- 最大利用時間を超えると全部初期化されて消えてしまう

Google Drive をマウントするといい

Colaboratory の左にある > からドライブをマウントをクリックすると Google Drive を

/content/drive/My Drive/ 以下にマウントすることができる。

必要なファイルは、Google Drive にアップロードすればすぐにみられる。

12時間を超えてもちゃんとファイルは保存されてる。ディレクトリの移動は、cd で行える。

ちなみに ls ll などのコマンドも使える。ちょっとグラフを描いてみる

import numpy as np import matplotlib.pyplot as plt x = np.arange(0, 10, 0.1) y = np.sin(x) plt.plot(x, y) plt.show()

- 投稿日:2020-01-04T21:34:57+09:00

【初心者向け】自然言語処理ツール「GiNZA」を用いた言語解析入門(形態素解析からベクトル化まで)

はじめに

最近、Pythonの言語処理ツール「GiNZA」を使い始めました。これまではMeCabを使っていましたが、なにやら最先端の機械学習技術を取り入れたライブラリがPythonにあるというのを(恥ずかしながら)最近知ったので、現在GiNZAに移行中です。今回は初めてのGiNZAということもあり、いろいろなサイトを参考にしながら備忘録として処理の流れをまとめてみました。筆者は自然言語解析の初学者で至らぬ箇所も多々ありますので、より深く学習したい方は公式ドキュメントなどを参考にしてください。この記事は、筆者と同じ初学者が「GiNZAってこんなことが出来るんだ!自分も使ってみよう!」と思ってくれればいいなと思いながら書いています。

GiNZAについて

既に多くの方が記事にされていますが、GiNZAはリクルートのAI研究機関であるMegagon Labsと国立国語研究所との共同研究成果の学習モデルを用いた自然言語処理ライブラリです。

「GiNZA」の概要

「GiNZA」は、ワンステップでの導入、高速・高精度な解析処理、単語依存構造解析レベルの国際化対応などの特長を備えた日本語自然言語処理オープンソースライブラリです。「GiNZA」は、最先端の機械学習技術を取り入れた自然言語処理ライブラリ「spaCy」(※5)をフレームワークとして利用しており、また、オープンソース形態素解析器「SudachiPy」(※6)を内部に組み込み、トークン化処理に利用しています。「GiNZA日本語UDモデル」にはMegagon Labsと国立国語研究所の共同研究成果が組み込まれています。https://www.recruit.co.jp/newsroom/2019/0402_18331.htmlより引用

GiNZAの内部では言語処理ライブラリ「spaCy」を利用しているようですね。こちらに記載されているように、GiNZAはspaCyを日本語対応にしたライブラリであるとざっくり解釈しています。また、形態素解析には「SudachiPy」を利用しています。この記事を読む多くの方が日本語の解析を望んでいるはずなので、Pythonユーザーにとって魅力的なライブラリですね!

開発環境

- Ubuntu 16.04

- Python 3.6.7

- GiNZA 2.2.0

(2020/01/04現在、GiNZAの最新バージョンは2.2.1です。)

GiNZAはpipコマンド一行でインストール出来ます。

$ pip install "https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz"形態素解析

まずは基本の形態素解析を行います。

係り受け解析import spacy nlp = spacy.load('ja_ginza') doc = nlp('今年の干支は庚子です。東京オリンピックたのしみだなあ。') for sent in doc.sents: for token in sent: print(token.i, token.orth_, token.lemma_, token.pos_, token.tag_, token.dep_, token.head.i)出力結果

0 今年 今年 NOUN 名詞-普通名詞-副詞可能 nmod 2 1 の の ADP 助詞-格助詞 case 0 2 干支 干支 NOUN 名詞-普通名詞-一般 nsubj 4 3 は は ADP 助詞-係助詞 case 2 4 庚子 庚子 NOUN 名詞-普通名詞-一般 ROOT 4 5 です です AUX 助動詞 aux 4 6 。 。 PUNCT 補助記号-句点 punct 4 7 東京 東京 PROPN 名詞-固有名詞-地名-一般 compound 9 8 オリンピック オリンピック NOUN 名詞-普通名詞-一般 compound 9 9 たのしみ 楽しみ NOUN 名詞-普通名詞-一般 ROOT 9 10 だ だ AUX 助動詞 cop 9 11 なあ な PART 助詞-終助詞 aux 9 12 。 。 PUNCT 補助記号-句点 punct 9上手く形態素に分割できています。左から「入力語」「見出し語(基本形)」「品詞」「品詞詳細」です(tokenの詳細はspaCyのAPIを参照してください)。GiNZAでは依存構造解析にも対応しており、依存関係にある単語番号とその単語との関係も推定されています(token.dep_の詳細はこちらを参照してください)。

GiNZAでは依存関係をグラフで可視化することも可能です。可視化には

displacyを使います。依存関係の可視化from spacy import displacy displacy.serve(doc, style='dep', options={'compact':True})実行後、

Serving on http://0.0.0.0:5000 ...と表示されるので、アクセスすると図が表示されます。MeCabしか使ってこなかったので、一行で構造を図示してくれるのは素晴らしいの一言です。可視化手法の詳細はspaCyのVisualizersを参照してください 。

テキストのベクトル化

単語ベクトルの推定法はいくつか提案されていますが、GiNZAには既に学習済みの単語ベクトルが用意されており、

Tokenのvector属性で参照することが出来ます。単語ベクトルdoc = nlp('あきらめたらそこで試合終了だ') token = doc[4] print(token) print(token.vector) print(token.vector.shape)実行結果

試合 [-1.7299166 1.3438352 0.51212436 0.8338855 0.42193085 -1.4436126 4.331309 -0.59857213 2.091658 3.1512427 -2.0446565 -0.41324708 ... 1.1213776 1.1430703 -1.231743 -2.3723211 ] (100,)単語ベクトルの次元数は100次元です。

また、similarity()メソッドを使用することで単語ベクトル間のコサイン類似度をはかることが出来ます。similarityword1 = nlp('おむすび') word2 = nlp('おにぎり') word3 = nlp('カレー') print(word1.similarity(word2)) #0.8016603151410209 print(word1.similarity(word3)) #0.5304326270109458コサイン類似度は0-1の範囲を取り、1に近いほど単語同士が似ているという意味になります。実際に、おむすびはカレーよりおにぎりに近いです。また、単語ではなく文書の場合でも同じ手順でベクトル化とコサイン類似度の計算が出来ます。文書のベクトルは、その文を構成する単語ベクトルの平均を返しているようです。

最後に、単語や文書をベクトルで表現できたのでこれらをベクトル空間に図示してみます。ベクトルの次元は100次元なので今回は主成分分析を用いて2次元まで落としてからプロットします。

plotimport numpy as np import matplotlib.pyplot as plt from sklearn.decomposition import PCA #text2vector vec1 = nlp('あけましておめでとうございます').vector vec2 = nlp('昨日キャベツを買った').vector vec3 = nlp('映画を観に行こう').vector vec4 = nlp('カレーが食べたい').vector vec5 = nlp('買い物しようと町まで出かけた').vector vec6 = nlp('昨日食べたチョコレート').vector #pca vectors = np.vstack((vec1, vec2, vec3, vec4, vec5, vec6)) pca = PCA(n_components=2).fit(vectors) trans = pca.fit_transform(vectors) pc_ratio = pca.explained_variance_ratio_ #plot plt.figure() plt.scatter(trans[:,0], trans[:,1]) i = 0 for txt in ['text1','text2','text3','text4','text5','text6']: plt.text(trans[i,0]-0.2, trans[i,1]+0.1, txt) i += 1 plt.hlines(0, min(trans[:,0]), max(trans[:,0]), linestyle='dashed', linewidth=1) plt.vlines(0, min(trans[:,1]), max(trans[:,1]), linestyle='dashed', linewidth=1) plt.xlabel('PC1 ('+str(round(pc_ratio[0]*100,2))+'%)') plt.ylabel('PC2 ('+str(round(pc_ratio[1]*100,2))+'%)') plt.tight_layout() plt.show()実行結果

情報量は落ちていますが、大量のデータを扱うにはこちらの方が認識しやすいかと思います。この図を見るとtext3と5が、text4と6がそれぞれ近いようですね。肌感覚でもそんな気がします。

最後に

自然言語処理初学者でしたが、GiNZAを利用することで形態素解析からベクトル化まで簡単に解析することが出来ました。これから言語処理を始めたい方にぜひオススメです。もし間違っている箇所やおかしな表現などありましたらご指摘をいただけますと幸いです。

参考サイト

- 投稿日:2020-01-04T21:34:57+09:00

【初心者向け】自然言語処理ツール「GiNZA」を用いた言語解析(形態素解析からベクトル化まで)

はじめに

最近、Pythonの言語処理ツール「GiNZA」を使い始めました。これまではMeCabを使っていましたが、なにやら最先端の機械学習技術を取り入れたライブラリがPythonにあるというのを(恥ずかしながら)最近知ったので、現在GiNZAに移行中です。今回は初めてのGiNZAということもあり、いろいろなサイトを参考にしながら備忘録として処理の流れをまとめてみました。筆者は自然言語解析の初学者で至らぬ箇所も多々ありますので、より深く学習したい方は公式ドキュメントなどを参考にしてください。この記事は、筆者と同じ初学者が「GiNZAってこんなことが出来るんだ!自分も使ってみよう!」と思ってくれればいいなと思いながら書いています。

GiNZAについて

既に多くの方が記事にされていますが、GiNZAはリクルートのAI研究機関であるMegagon Labsと国立国語研究所との共同研究成果の学習モデルを用いた自然言語処理ライブラリです。

「GiNZA」の概要

「GiNZA」は、ワンステップでの導入、高速・高精度な解析処理、単語依存構造解析レベルの国際化対応などの特長を備えた日本語自然言語処理オープンソースライブラリです。「GiNZA」は、最先端の機械学習技術を取り入れた自然言語処理ライブラリ「spaCy」(※5)をフレームワークとして利用しており、また、オープンソース形態素解析器「SudachiPy」(※6)を内部に組み込み、トークン化処理に利用しています。「GiNZA日本語UDモデル」にはMegagon Labsと国立国語研究所の共同研究成果が組み込まれています。https://www.recruit.co.jp/newsroom/2019/0402_18331.htmlより引用

GiNZAの内部では言語処理ライブラリ「spaCy」を利用しているようですね。こちらに記載されているように、GiNZAはspaCyを日本語対応にしたライブラリであるとざっくり解釈しています。また、形態素解析には「SudachiPy」を利用しています。この記事を読む多くの方が日本語の解析を望んでいるはずなので、Pythonユーザーにとって魅力的なライブラリですね!

開発環境

- Ubuntu 16.04

- Python 3.6.7

- GiNZA 2.2.0

(2020/01/04現在、GiNZAの最新バージョンは2.2.1です。)

GiNZAはpipコマンド一行でインストール出来ます。

$ pip install "https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz"形態素解析

まずは基本の形態素解析を行います。

係り受け解析import spacy nlp = spacy.load('ja_ginza') doc = nlp('今年の干支は庚子です。東京オリンピックたのしみだなあ。') for sent in doc.sents: for token in sent: print(token.i, token.orth_, token.lemma_, token.pos_, token.tag_, token.dep_, token.head.i)出力結果

0 今年 今年 NOUN 名詞-普通名詞-副詞可能 nmod 2 1 の の ADP 助詞-格助詞 case 0 2 干支 干支 NOUN 名詞-普通名詞-一般 nsubj 4 3 は は ADP 助詞-係助詞 case 2 4 庚子 庚子 NOUN 名詞-普通名詞-一般 ROOT 4 5 です です AUX 助動詞 aux 4 6 。 。 PUNCT 補助記号-句点 punct 4 7 東京 東京 PROPN 名詞-固有名詞-地名-一般 compound 9 8 オリンピック オリンピック NOUN 名詞-普通名詞-一般 compound 9 9 たのしみ 楽しみ NOUN 名詞-普通名詞-一般 ROOT 9 10 だ だ AUX 助動詞 cop 9 11 なあ な PART 助詞-終助詞 aux 9 12 。 。 PUNCT 補助記号-句点 punct 9上手く形態素に分割できています。左から「入力語」「見出し語(基本形)」「品詞」「品詞詳細」です(tokenの詳細はspaCyのAPIを参照してください)。GiNZAでは依存構造解析にも対応しており、依存関係にある単語番号とその単語との関係も推定されています(token.dep_の詳細はこちらを参照してください)。

GiNZAでは依存関係をグラフで可視化することも可能です。可視化には

displacyを使います。依存関係の可視化from spacy import displacy displacy.serve(doc, style='dep', options={'compact':True})実行後、

Serving on http://0.0.0.0:5000 ...と表示されるので、アクセスすると図が表示されます。MeCabしか使ってこなかったので、一行で構造を図示してくれるのは素晴らしいの一言です。可視化手法の詳細はspaCyのVisualizersを参照してください 。

テキストのベクトル化

単語ベクトルの推定法はいくつか提案されていますが、GiNZAには既に学習済みの単語ベクトルが用意されており、

Tokenのvector属性で参照することが出来ます。単語ベクトルdoc = nlp('あきらめたらそこで試合終了だ') token = doc[4] print(token) print(token.vector) print(token.vector.shape)実行結果

試合 [-1.7299166 1.3438352 0.51212436 0.8338855 0.42193085 -1.4436126 4.331309 -0.59857213 2.091658 3.1512427 -2.0446565 -0.41324708 ... 1.1213776 1.1430703 -1.231743 -2.3723211 ] (100,)単語ベクトルの次元数は100次元です。

また、similarity()メソッドを使用することで単語ベクトル間のコサイン類似度をはかることが出来ます。similarityword1 = nlp('おむすび') word2 = nlp('おにぎり') word3 = nlp('カレー') print(word1.similarity(word2)) #0.8016603151410209 print(word1.similarity(word3)) #0.5304326270109458コサイン類似度は0-1の範囲を取り、1に近いほど単語同士が似ているという意味になります。実際に、おむすびはカレーよりおにぎりに近いです。また、単語ではなく文書の場合でも同じ手順でベクトル化とコサイン類似度の計算が出来ます。文書のベクトルは、その文を構成する単語ベクトルの平均を返しているようです。

最後に、単語や文書をベクトルで表現できたのでこれらをベクトル空間に図示してみます。ベクトルの次元は100次元なので今回は主成分分析を用いて2次元まで落としてからプロットします。

plotimport numpy as np import matplotlib.pyplot as plt from sklearn.decomposition import PCA #text2vector vec1 = nlp('あけましておめでとうございます').vector vec2 = nlp('昨日キャベツを買った').vector vec3 = nlp('映画を観に行こう').vector vec4 = nlp('カレーが食べたい').vector vec5 = nlp('買い物しようと町まで出かけた').vector vec6 = nlp('昨日食べたチョコレート').vector #pca vectors = np.vstack((vec1, vec2, vec3, vec4, vec5, vec6)) pca = PCA(n_components=2).fit(vectors) trans = pca.fit_transform(vectors) pc_ratio = pca.explained_variance_ratio_ #plot plt.figure() plt.scatter(trans[:,0], trans[:,1]) i = 0 for txt in ['text1','text2','text3','text4','text5','text6']: plt.text(trans[i,0]-0.2, trans[i,1]+0.1, txt) i += 1 plt.hlines(0, min(trans[:,0]), max(trans[:,0]), linestyle='dashed', linewidth=1) plt.vlines(0, min(trans[:,1]), max(trans[:,1]), linestyle='dashed', linewidth=1) plt.xlabel('PC1 ('+str(round(pc_ratio[0]*100,2))+'%)') plt.ylabel('PC2 ('+str(round(pc_ratio[1]*100,2))+'%)') plt.tight_layout() plt.show()実行結果

情報量は落ちていますが、大量のデータを扱うにはこちらの方が認識しやすいかと思います。この図を見るとtext3と5が、text4と6がそれぞれ近いようですね。肌感覚でもそんな気がします。

最後に

自然言語処理初学者でしたが、GiNZAを利用することで形態素解析からベクトル化まで簡単に解析することが出来ました。これから言語処理を始めたい方にぜひオススメです。もし間違っている箇所やおかしな表現などありましたらご指摘をいただけますと幸いです。

参考サイト

- 投稿日:2020-01-04T21:26:38+09:00

実験系でもPythonで効率化したい(4)try構文を用いてエラーを吐いたときにser.close()するようにする

前回までのあらすじ

前回までで測定を自動化できるようになりました。今回は測定装置が機嫌が悪い時に、エラーを吐いてしまうのでそれに対応します。

Windows COMポート二桁以上許容されない問題

- マイクロソフトサポートページ

- 上記サイトでも言及されている通り、WindowsではCOMポートが、接続デバイスが増えるごとに増殖し続けるにも関わらず、10以上になると不具合が出ることがあります。私の環境ではADVANTEST社のR6441が、USBハブなどを用いて接続しているときに、COMポートが10以上だと測定に失敗することがあります。

try構文を用いて解決する

exceptのあとに例外の名前(エラーのときに出力される)を書いておくと、失敗したときの挙動を決められます。今回は、ser.close()するようにします。try: while 1: if pulse >= MAX: ## 位置がMAXまで来ている場合while文を終了 break ## 現在位置の情報を記録 pulse_list.append(pulse/2) ## 電流を測定する(5回とって平均したものをその位置での値とする) for i in range(5): ser = serial.Serial(COMampere,bitRate,timeout=0.1) ser.write(b"F5, R0,PR2\r\n") time.sleep(1) ser.write(b"MD?\r\n") time.sleep(1) tmp = ser.read_all() # 電流が取れていない場合はスキップする if len(tmp)== 0: ser.close() continue ampere = float(tmp.split()[2]) ampere_average_list.append(ampere) time.sleep(1) ser.close() ## 電流とpulse(位置)をlistに追加 ampere_list.append(sum(ampere_average_list)/len(ampere_average_list)) ampere_average_list = [] ## 光学台を動かす pulse += 1000 position = "A:2+P"+str(pulse)+"\r\n" ser = serial.Serial(COMpulse,bitRate,timeout=0.1) ser.write(bytes(position, 'UTF-8')) time.sleep(1) ser.write(b"G:\r\n") ser.close() ## リストをdataframeに変える print(ampere_list) print(pulse_list) df = pd.DataFrame({'ampere(A)':ampere_list,'pulse':pulse_list}) def pulseToMilliMeter(pulse): return pulse*0.006 df["position(mm)"] = df["pulse"].map(pulseToMilliMeter) df.to_csv('./csv/result.csv',index=False) plt.figure() df.plot(x='position(mm)',y='ampere(A)',marker='o') plt.savefig('./img/sample.png') plt.close('all') except IndexError: ser.close()

- 投稿日:2020-01-04T21:25:42+09:00

実験系でもPythonで効率化したい(5)slackAPIで実験終了時に通知を送りたい

前回までのあらすじ

前回まででエラーも考慮して自動測定ができるようになりました。今回はslackのAPIを用いて、測定の終了をslackに通知できるようにします。他のチャットツール(Discord ,Lineなど)であっても、トークンを取得してAPIに要求を送るという流れは同じなので、様々な用途に利用できると思います。

環境

- Windows10

- Anaconda(3.x)

- (2)でpySerialを

conda installしましたやっていること

pythonのslackclientパッケージが私の環境では動かなかったので、

- Slackにpythonからメッセージを送信する - Qiita

- Pythonを使ってSlackに送信する方法 - Qiitaなどを参考にして、

- requests パッケージを用いて

- slackのwebページで取得したトークンを用いて

slackAPIを使って任意のメッセージを、任意のチャンネルに送れます。以下のコードで変更すべき点は

- token

- send_message("ココ", ココ(チャンネル名))

のみで、送れるはずです

mentionの付け方は

このサイトを参考にしてください

import serial import time import pandas as pd ## 定数指定 MAX = 40000 COMampere = "COM10" COMpulse = "COM9" bitRate = 9600 ## 変数初期化 pulse = 0 ampere_list = [] pulse_list = [] ampere_average_list =[] ## 奥原点移動(初期化) ser = serial.Serial(COMsigma, bitRate, timeout=0.1) ser.write(b"H:2-\r\n") # time.sleep(0.1) # print(ser.read_all()) ser.close() import requests class SlackDriver: def __init__(self, _token): self._token = _token # api_token self._headers = {'Content-Type': 'application/json'} def send_message(self, message, channel): params = {"token": self._token, "channel": channel, "text": message} r = requests.get('https://slack.com/api/chat.postMessage', headers=self._headers, params=params) print("return ", r.json()) token = 'xxxx-oooooooooooo-000000000000-hogehoge' # この部分を取得したトークンにしてください slack = SlackDriver(token) # 計測開始 try: while 1: if pulse >= MAX: ## 位置がMAXまで来ている場合while文を終了 break if pulse ==2000: slack.send_message("<@IDhogehoge> 1000おわったよ", "#bot-test") # 取得したIDは<>でくくってください if pulse ==30000: slack.send_message("<@IDhogehoge> 15000おわったよ", "#bot-test") ## 現在位置の情報を記録 pulse_list.append(pulse/2) ## 電流を測定する(5回とって平均したものをその位置での値とする) for i in range(5): ser = serial.Serial(COMampere,bitRate,timeout=0.1) ser.write(b"F5, R0,PR2\r\n") time.sleep(1) ser.write(b"MD?\r\n") time.sleep(1) tmp = ser.read_all() # 電流が取れていない場合はスキップする if len(tmp)== 0: ser.close() continue ampere = float(tmp.split()[2]) ampere_average_list.append(ampere) time.sleep(1) ser.close() ## 電流とpulse(位置)をlistに追加 ampere_list.append(sum(ampere_average_list)/len(ampere_average_list)) ampere_average_list = [] ## 光学台を動かす pulse += 1000 position = "A:2+P"+str(pulse)+"\r\n" ser = serial.Serial(COMpulse,bitRate,timeout=0.1) ser.write(bytes(position, 'UTF-8')) time.sleep(1) ser.write(b"G:\r\n") ser.close() ## リストをdataframeに変える print(ampere_list) print(pulse_list) df = pd.DataFrame({'ampere(A)':ampere_list,'pulse':pulse_list}) def pulseToMilliMeter(pulse): return pulse*0.006 df["position(mm)"] = df["pulse"].map(pulseToMilliMeter) df.to_csv('./csv/result.csv',index=False) plt.figure() df.plot(x='position(mm)',y='ampere(A)',marker='o') plt.savefig('./img/sample.png') plt.close('all') except IndexError: ser.close() slack.send_message("<@IDhogehoge> 測定失敗してるよ", "#bot-test") # slackに通知したい slack.send_message("<@IDhogehoge> 測定終わったよ", "#bot-test") ## 変数初期化 pulse = 0 ampere_list = [] pulse_list = [] ampere_average_list =[] ## 奥原点移動(初期化) ser = serial.Serial(COMpulse, bitRate, timeout=0.1) ser.write(b"H:2-\r\n") time.sleep(0.1) print(ser.read_all()) ser.close()

- 投稿日:2020-01-04T21:09:33+09:00

Raspberry PiでGrove Pi+スターターキットとカメラを使う初期設定

概要

ハッカソンでRaspberry Piとカメラ、Grove Pi+スターターキット、kintoneを活用することになり、Raspberry Piのセットアップと初期設定について調べました。

結果、OpenCVをPython3で使う設定とGrove Pi+設定でトラブルはありましたが、Raspberry Piとカメラ、Grove Pi+スターターキット、Python library to access kintone の設定ができました。使用する機器について(2020/01/03 Amazonで調査)

最新のRaspberry Pi 4はGrove Piのサポートに含まれないため、今回はRaspberry Pi 3を使用しています。

そもそもRaspberry Pi 4は高価で、今回の用途にはそこまでのスペックが必要ないでしょう。今回の調査で用いた機器(一部同等品含む)

Amazonで全て購入して20,408円前後で試すことができます。

Raspberry Pi3 Model B ボード&ケースセット 3ple Decker対応 (Clear)-Physical Computing Lab(6,100円)

https://www.amazon.co.jp/dp/B01CSFZ4JG/

SanDisk microSDHC ULTRA 16GB 80MB/s SDSQUNS-016G Class10(465円)

https://www.amazon.co.jp/dp/B074B4P7KD/

Grove Pi+ スターターキット 初心者向け Raspberry Pi A+,B,B+&2,3適用 CE認証(6,100円)

https://www.amazon.co.jp/dp/B07H9PFWHW/

US電源アダプタ オン/オフスイッチ ケーブル 5V 2.5A ラズベリーパイ3に対応 軽量 携帯便利(464円)

https://www.amazon.co.jp/dp/B07CYNGG4C/

カメラモジュール 感光チップOV5647センサー 5M画素 Raspberry Pi 1 2 3 Model B B A+対応(780円)

https://www.amazon.co.jp/dp/B07G572B3R/Raspberry Piの設定

OSのセットアップ

以下より最新のOSをダウンロードしました。

https://www.raspberrypi.org/downloads/raspbian/使用したOSイメージは以下です。

Raspbian Buster with desktop

・Version: September 2019

・Release date: 2019-09-26

・Kernel version: 4.19OSをSDカードにセットアップする方法などは省略します。

詳しく知りたい方は以下を参照ください。Raspberry Pi 初期設定 Windows( @sigma7641 さん)

https://qiita.com/sigma7641/items/995c7bb07eab408b9d0e

Raspberry Pi 初期設定 Mac( @skkojiko さん)

https://qiita.com/skkojiko/items/a7e342a8ab53b409fe6aコマンドラインテキストエディタについて

作業はsshで接続し、コマンドラインで行います。

コマンドラインのテキストエディタはnanoで説明しますが、使い方は以下を参照ください。GNU nanoを使いこなす( @snct_hu さん)

https://qiita.com/snct_hu/items/971d512c26dd8b3a3b3c固定IPの設定

先ず最初にsshで接続しやすくするため固定IPを設定します。

$ sudo nano /etc/dhcpcd.conf (IPアドレスは適切な内容に変更して、以下の設定を追加) interface eth0 static ip_address=192.168.0.111/24 static routers=192.168.0.1 static domain_name_servers=192.168.0.1 8.8.8.8無線LANの設定は以下を参照ください。

Raspberry Piの無線LAN設定をコマンドラインで行う( @mym さん)

https://qiita.com/mym/items/468d2cdb30d756b6df24OSの基本設定

OSの基本設定はraspi-configを使って行います。

$ sudo raspi-config今回は、以下を設定しています。

1 Change User Password

4 Localisation Options

-> I1 Change Locale -> ja_JP.UTF-8 UTF-8

-> I2 Change Timezone -> Asia -> Tokyo

-> I3 Change Keyboard Layout -> 適宜

-> I4 Change Wi-fi Country -> JP Japan5 Interfacing Options

-> P1 Camera -> Enable

-> P4 SPI -> Enable

-> P5 I2C -> Enable8 Update

設定後はOSを最新の状態にUPDATEします。

$ sudo apt-get update $ sudo apt-get upgradeRaspberry Pi カメラ設定

Raspberry Pi カメラの設定は以下を参照ください。

Raspberry Pi カメラで写真・ビデオを撮影する

https://iotdiyclub.net/raspberry-pi-using-camera-1/基本的な設定完了後、PythonのOpenCV(画像編集ライブラリィ)用の設定を行います。

$ sudo modprobe bcm2835-v4l2 $ sudo nano /etc/modules bcm2835-v4l2 $ sudo apt-get install libopencv-dev python-opencvOpenCVの詳細については以下を参照ください。

OpenCV

https://opencv.org/

Python版 OpenCVの基本

https://cvtech.cc/py-opencv/

画像処理入門講座 : OpenCVとPythonで始める画像処理

https://postd.cc/image-processing-101/Python3を使う場合は以下の設定を行います。

$ sudo apt-get install libhdf5-dev libhdf5-serial-dev libhdf5-103 $ sudo apt-get install libqtgui4 libqtwebkit4 libqt4-test python3-pyqt5 $ sudo apt-get install libatlas-base-dev $ sudo apt-get install libjasper-dev $ pip3 install opencv-pythonOpenCVをPython3でそのまま利用すると import cv2 でエラーになります。

このエラーを回避するため、ロードするライブラリィを追加します。$ nano .bashrc export LD_PRELOAD=/usr/lib/arm-linux-gnueabihf/libatomic.so.1 $ source .bashrcGrove Pi+の設定

Grove Pi+のRaspberry Pi への取り付けは以下を参考にしてください。

GrovePi+

https://www.switch-science.com/catalog/2129/Grove Pi+のソフトウェアの設定は以下を参考に行います。

Setting Up The Software

https://www.dexterindustries.com/GrovePi/get-started-with-the-grovepi/setting-software/$ curl -kL dexterindustries.com/update_grovepi | bash $ sudo reboot $ cd /home/pi/Dexter $ git clone https://github.com/DexterInd/GrovePi $ cd /home/pi/Dexter/GrovePi/Script $ sudo chmod +x install.sh $ sudo ./install.shインストール後に問題なければi2cdetectコマンドで以下のようにI2Cの04ポートが確認できます。

$ sudo i2cdetect -y 1 0 1 2 3 4 5 6 7 8 9 a b c d e f 00: -- 04 -- -- -- -- -- -- -- -- -- -- -- 10: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 20: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 30: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 40: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 50: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 60: -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- -- 70: -- -- -- -- -- -- -- --Grove Pi+設定後、OSやインストール済のソフト更新を行う apt-get upgrade でパッケージ依存関係に問題が発生しエラーになります。

このエラーを回避するため、以下を実行します。$ sudo apt-get --fix-broken upgrade実際に動くか試験するため、以下を参考に付属のGrove LEDをGrove Pi+のD4ポートに配線します。

http://wiki.seeedstudio.com/Grove-Red_LED/#play-with-raspberry-pi-with-grovepi_plus

配線後に、以下のバージョン表示や、LEDの点滅を試験して問題がないか確認します。

$ python /home/pi/Dexter/GrovePi/Software/Python/grovepi.py library supports this fw versions: 1.3.0 $ python /home/pi/Dexter/GrovePi/Software/Python/grove_led_blink.py This example will blink a Grove LED connected to the GrovePi+ on the port labeled D4. If you're having trouble seeing the LED blink, be sure to check the LED connection and the port number. You may also try reversing the direction of the LED on the sensor. Connect the LED to the port labele D4! LED ON! LED OFF! LED ON! LED OFF! LED ON! LED OFF!Grove Pi+のライブラリィ不具合

2020/02/02 時点で以下のGrove Pi+のライブラリィ 1.3.0 のファイルに不具合があり、多くのサンプルが動きません。

/home/pi/Dexter/GrovePi/Software/Python/grovepi.py

https://github.com/DexterInd/GrovePi/blob/master/Software/Python/grovepi.py例えば grove_button.py は、0でボタンOFF、1でボタンONを表示するプログラムですが、実行すると以下の表示になります。

$ python /home/pi/Dexter/GrovePi/Software/Python/grove_button.py 255 255 255 255 255 255grovepi.pyのI2Cの読み込み部分に不具合があり、修正する必要があります。

以下にgrovepi.pyの修正箇所を説明します。227行目read_identified_i2c_block()while文が永久ループするため削除

grovepi.pydef read_identified_i2c_block(read_command_id, no_bytes): data = [-1] data = read_i2c_block(no_bytes + 1) return data246行目analogRead()のnumber配列要素番号を修正

grovepi.py# Read analog value from Pin def analogRead(pin): write_i2c_block(aRead_cmd + [pin, unused, unused]) number = read_identified_i2c_block(aRead_cmd, no_bytes = 2) return number[1] * 256 + number[2]284行目ultrasonicRead()のnumber配列要素番号を修正

grovepi.py# Read value from Grove Ultrasonic def ultrasonicRead(pin): write_i2c_block(uRead_cmd + [pin, unused, unused]) number = read_identified_i2c_block(uRead_cmd, no_bytes = 2) return (number[1] * 256 + number[2])320行目dht()のnumber配列要素番号、no_bytes変数値を修正

grovepi.py# Read and return temperature and humidity from Grove DHT Pro def dht(pin, module_type): write_i2c_block(dht_temp_cmd + [pin, module_type, unused]) number = read_identified_i2c_block(dht_temp_cmd, no_bytes = 9) if p_version==2: h='' for element in (number[1:5]): h+=chr(element) t_val=struct.unpack('f', h) t = round(t_val[0], 2) h = '' for element in (number[5:9]): h+=chr(element) hum_val=struct.unpack('f',h) hum = round(hum_val[0], 2) else: t_val=bytearray(number[1:5]) h_val=bytearray(number[5:9]) t=round(struct.unpack('f',t_val)[0],2) hum=round(struct.unpack('f',h_val)[0],2) if t > -100.0 and t <150.0 and hum >= 0.0 and hum<=100.0: return [t, hum] else: return [float('nan'),float('nan')]上記の修正後に以下を実行すると、期待通りの結果を得ることができました。

$ python /home/pi/Dexter/GrovePi/Software/Python/grove_button.py 0 0 1 1 1 0 0Python library to access kintoneの設定

$ pip install pykintone $ pip3 install pykintonenode-redの設定(必要な場合のみ)

node-redの設定は以下のように行います。

$ sudo apt-get install nodered $ sudo systemctl enable nodered.service $ sudo service nodered startブラウザで http://Raspberry PiのIPアドレス:1880/ にアクセスするとnode-redが利用できます。

詳細は以下を参照ください。

Node-RED Raspberry Piで実行する

https://nodered.jp/docs/getting-started/raspberrypiリモートディスクトップの設定(必要な場合のみ)

リモートディスクトップの設定は以下のように行います。

$ sudo apt-get install xrdp $ cd /etc/xrdp/ $ sudo wget http://w.vmeta.jp/temp/km-0411.ini $ sudo ln -s km-0411.ini km-e0010411.ini $ sudo ln -s km-0411.ini km-e0200411.ini $ sudo ln -s km-0411.ini km-e0210411.ini $ sudo service xrdp restartRaspberry PiのIPアドレスで以下のようにリモートディスクトップに接続できます。

詳細は以下を参照ください。

Windowsパソコンからraspberrypi3にリモートデスクトップで接続する( @t114 さん)

https://qiita.com/t114/items/bfac508504b9a6b7570d参考

ラズパイでpython3にopencvを入れたらエラーが出た【対処法】( @XM03 さん)

https://qiita.com/XM03/items/48463fd910470b226f22Raspberry Pi Projects for the GrovePi.

https://www.dexterindustries.com/GrovePi/projects-for-the-raspberry-pi/

https://www.dexterindustries.com/GrovePi/get-started-with-the-grovepi/setting-software/Grove - LED

https://www.seeedstudio.com/Grove-Green-LED.html

http://wiki.seeedstudio.com/Grove-Red_LED/#play-with-raspberry-pi-with-grovepi_plusGrove - Button(ボタン)

https://www.seeedstudio.com/Grove-Button.html

http://wiki.seeedstudio.com/Grove-Button/#play-with-raspberry-piwith-grovepi_plusNode-RED Raspberry Piで実行する

https://nodered.jp/docs/getting-started/raspberrypiWindowsパソコンからraspberrypi3にリモートデスクトップで接続する( @t114 さん)

https://qiita.com/t114/items/bfac508504b9a6b7570dGitHub icoxfog417/pykintone

https://github.com/icoxfog417/pykintonegrovepi.py の不具合修正(227行以降)

(Y.K Bug fixes) の記載部分に修正ありgrovepi.py(前略) # Read I2C block from the GrovePi def read_i2c_block(no_bytes = max_recv_size): data = data_not_available_cmd counter = 0 while data[0] in [data_not_available_cmd[0], 255] and counter < 3: try: data = i2c.read_list(reg = None, len = no_bytes) time.sleep(0.002 + additional_waiting) if counter > 0: counter = 0 except: counter += 1 time.sleep(0.003) return data # (Y.K Bug fixes) def read_identified_i2c_block(read_command_id, no_bytes): data = [-1] data = read_i2c_block(no_bytes + 1) return data # Arduino Digital Read def digitalRead(pin): write_i2c_block(dRead_cmd + [pin, unused, unused]) data = read_identified_i2c_block( dRead_cmd, no_bytes = 1)[0] return data # Arduino Digital Write def digitalWrite(pin, value): write_i2c_block(dWrite_cmd + [pin, value, unused]) read_i2c_block(no_bytes = 1) return 1 # Read analog value from Pin (Y.K Bug fixes) def analogRead(pin): write_i2c_block(aRead_cmd + [pin, unused, unused]) number = read_identified_i2c_block(aRead_cmd, no_bytes = 2) return number[1] * 256 + number[2] # Write PWM def analogWrite(pin, value): write_i2c_block(aWrite_cmd + [pin, value, unused]) read_i2c_block(no_bytes = 1) return 1 # Setting Up Pin mode on Arduino def pinMode(pin, mode): if mode == "OUTPUT": write_i2c_block(pMode_cmd + [pin, 1, unused]) elif mode == "INPUT": write_i2c_block(pMode_cmd + [pin, 0, unused]) read_i2c_block(no_bytes = 1) return 1 # Read temp in Celsius from Grove Temperature Sensor def temp(pin, model = '1.0'): # each of the sensor revisions use different thermistors, each with their own B value constant if model == '1.2': bValue = 4250 # sensor v1.2 uses thermistor ??? (assuming NCP18WF104F03RC until SeeedStudio clarifies) elif model == '1.1': bValue = 4250 # sensor v1.1 uses thermistor NCP18WF104F03RC else: bValue = 3975 # sensor v1.0 uses thermistor TTC3A103*39H a = analogRead(pin) resistance = (float)(1023 - a) * 10000 / a t = (float)(1 / (math.log(resistance / 10000) / bValue + 1 / 298.15) - 273.15) return t # Read value from Grove Ultrasonic (Y.K Bug fixes) def ultrasonicRead(pin): write_i2c_block(uRead_cmd + [pin, unused, unused]) number = read_identified_i2c_block(uRead_cmd, no_bytes = 2) return (number[1] * 256 + number[2]) # Read the firmware version def version(): write_i2c_block(version_cmd + [unused, unused, unused]) number = read_identified_i2c_block(version_cmd, no_bytes = 3) return "%s.%s.%s" % (number[0], number[1], number[2]) # Read Grove Accelerometer (+/- 1.5g) XYZ value # Need to investigate why this reports what was read with the previous command # Doesn't look to be implemented on the GrovePi def acc_xyz(): write_i2c_block(acc_xyz_cmd + [unused, unused, unused]) number = read_identified_i2c_block(acc_xyz_cmd, no_bytes = 3) if number[1] > 32: number[1] = - (number[1] - 224) if number[2] > 32: number[2] = - (number[2] - 224) if number[3] > 32: number[3] = - (number[3] - 224) return (number[0], number[1], number[2]) # Read from Grove RTC # Doesn't look to be implemented on the GrovePi def rtc_getTime(): write_i2c_block(rtc_getTime_cmd + [unused, unused, unused]) number = read_i2c_block() return number # Read and return temperature and humidity from Grove DHT Pro (Y.K Bug fixes) def dht(pin, module_type): write_i2c_block(dht_temp_cmd + [pin, module_type, unused]) number = read_identified_i2c_block(dht_temp_cmd, no_bytes = 9) if p_version==2: h='' for element in (number[1:5]): h+=chr(element) t_val=struct.unpack('f', h) t = round(t_val[0], 2) h = '' for element in (number[5:9]): h+=chr(element) hum_val=struct.unpack('f',h) hum = round(hum_val[0], 2) else: t_val=bytearray(number[1:5]) h_val=bytearray(number[5:9]) t=round(struct.unpack('f',t_val)[0],2) hum=round(struct.unpack('f',h_val)[0],2) if t > -100.0 and t <150.0 and hum >= 0.0 and hum<=100.0: return [t, hum] else: return [float('nan'),float('nan')] (後略)

- 投稿日:2020-01-04T21:07:19+09:00

自分用 Anaconda + JupyterLab 構築メモ

anaconda ダウンロード

https://www.anaconda.com/distribution/ からダウンロード

インストール確認

以下のディレクトリが存在することを確認

/opt/anaconda3/JupyterLab 起動

以下のコマンドを実行

$ jupyter lab実行すると、ブラウザが立ち上がりJupyterLab が表示される。

- 投稿日:2020-01-04T20:53:32+09:00

numpyのarrayの要素をforで回さないで済むようにする方法チェックリスト

※コメントいただいたので追記します。諸事情によりpython2からアップデートできない状況でして、コードもpython2になってます。大きく結論が変わるわけではないと思いますが、文法が異なるところは適宜ご自身の環境に合わせて読み替えてください。

numpy.arrayの要素をfor文で回すと実行速度がかなり落ちる。

これをもうちょっと早くするために試す対処として、

- list内包表記にする

- 条件が複雑ならnp.whereを使う

- np.frompyfuncを使う

というのを学んだのでその備忘録。

list内包表記

これはもうどこにでも書いてあるけど、

import numpy as np a = np.array(range(10)) a2 = [] for x in a: a2.append(x*2)とかやるくらいなら、

a2 = [x*2 for x in a]にしなさいよ、という話。体感でもかなり早くなる。

条件が複雑ならnp.whereを使う

たとえば、いじりたいのは配列aだけど、条件は配列bの要素で決めたい、みたいな場合。

例として、配列bの要素が偶数なら配列aの要素を2倍、それ以外だったら配列aの要素を3倍にするケースを考えてみる。

ついC++的にインデックス使ってforで回したくなってしまうのをぐっとこらえて、np.whereを使う。

import numpy as np a = np.array(range(10)) print "a = ", a b = a + 100 print "b = ", b # インデックス使っちゃうとこんな感じ result1 = [] for i in range(10) : answer = a[i]*2 if b[i]%2 == 0 else a[i]*3 result1.append(answer) print np.array(result1) # np.whereと関数を使えば1行で書けて速い def func_double(x) : return x*2 def func_triple(x) : return x*3 result2 = np.where(b%2 == 0, func_double(a), func_triple(a)) print result2なお、コメントにいただいた通り、この程度の関数であればリスト内包表記にそのまま関数を埋め込んでも良いと思います。

(ただ、個人的にはリスト内包表記に関数を直書きで埋め込むのはあまり好きではないです…あとから色々変更しにくいし、変更忘れたりするし、ファーストランゲージがpython世代の若い学生さんがリスト内包表記内にクソ長いコード書いてきたりすると、「すっげえ読みにくいィィッ!!!」とキレそうになるから(笑))

np.frompyfuncを使う

もうちょっと速くならないか、と探していたら以下のページを見つけたので、有難く使わせていただいた。

Pythonのリストの全要素に任意の関数をapplyする最速の方法

Python高速化実験~map関数とか~というわけで、frompyfuncを使ってみる。

import numpy as np # prepare input arrays a = np.array(range(10)) print "array a is", a b = a + 100 print "array b is", b def addition(x, y): return x + y np_addition = np.frompyfunc(addition, 2, 1) print "print a + b using frompyfunc" print np_addition(a, b) print "print a + 1 using frompyfunc" print np_addition(a, 1) print "print 1 + b using frompyfunc" print np_addition(1, b) np_subtruction = np.frompyfunc(subtruction, 2, 1) print "using np.where and frompyfuncs" result2 = np.where(b%2 == 0, np_addition(a, b), np_subtruction(a, b)) print result2frompyfuncで作ったユニバーサル関数の引数は、1つ目が関数オブジェクト、2つ目が引数の数、3つ目が戻り値の数。これを使うと、ユニバーサル関数の引数に配列を突っ込めば、それぞれの要素に関数を適用した結果を配列として返してくれる。

なんだ、こんな便利なものがあるなら、さっさと使えばよかった。

体感でも、list内包表記より3割くらい速い感じがする。で、なにを確かめたかったかというと、このfrompyfuncで作ったユニバーサル関数の引数に、一部だけ配列を渡し、残りはただのfloatにする、とかいうことが可能なのか? という話。

結果は、全然問題なし!

つまり、配列を渡した部分だけを要素ごとに変更しながら、計算した結果を返してくれるのである。

しかも、どの引数を配列にしようが、勝手に判断してくれる。スバラシイ!!

さらに、np.whereとの併用も問題がないことを確認。

(追記)この先要検討でした!(汗)np.whereとfrompyfuncで作ったユニバーサル関数の併用の場合、下記のとおり動くことは確認しましたが、場合によっては激遅になって、リスト内包表記で回しながら直接スカラー引数用の関数を呼んだ方が速かった。テストプログラムと実際の解析プログラムと遅くなり方が違うので、どういうときに激遅になるのかまだ不明。というか、要するに、原理わからずに使ってるからこういうことになるんだな(苦笑)。でもあまり速度関係ない場面なら使えるかもしれない。

実は、このケースだと別にnp.whereの引数にわざわざユニバーサル関数を使う必要はなく、ダイレクトにスカラー引数用のaddition, subtruction関数を突っ込んでも同じ結果になる。

しかし、あえてユニバーサル関数を使うことの利点として、C++でいう関数オーバーロードっぽいことができることが考えられる。

つまり、pythonでは、そもそも関数の引数に厳密な型指定がないために、たとえば引数のうちの一つを配列でもfloatでもOKにして振る舞いを変えたければ、関数の中で型チェックをしてif分岐するしかないわけです。それはあまり美しくない。

もちろん、引数名を配列の場合とfloatの場合で変えて定義して振る舞いを変えるなんてのはもっとやりたくない(使用側のコードの変更が必要になるから)。

python楽チンだけど、たまには、C++みたいな厳密な型指定ができて関数オーバーロードできりゃいいのに、と思うことはある(まあ、いわゆるpythonっぽいコードの書き方ができていないせいでしょうが)。しかし、たとえば、あるケースではxは配列だけど、別のケースではxは固定したい、みたいなシンプルなケースの場合には、上の実験から、スカラー引数の場合の関数一つ作ってfrompyfuncでユニバーサル関数にするだけで、全てのケースに勝手に対応してくれる。

これは、パラメタ変数を一個ずつ固定して残りを動かしながら結果の推移を見る、みたいなケースとか、パラメタ全部動かすと計算が重いから一時的に変数一つだけ固定しちゃえ、みたいな場合に大変有用なんではないかという気がする。というわけで、これから今いじっているコードのlist内包表記を駆逐してみて、どのくらい使用感が変わるかみてみようと思います。

- 投稿日:2020-01-04T20:43:14+09:00

Pythonによる AI・機械学習について学んでいます

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-1 機械学習で何ができる?

分類(classification) ... 与えられたデータを分類

データの特徴を調べて分類する回帰(regression) ... 過去の実績から未来の値を予測

過去のデータを学習して将来の数値予測を行うクラスタリング(clustering) ... データを似たものの集合に分類

分類と違うのはあらかじめ決まっている項目に分けるのではなく似たもの区分けする推薦(recommendation) ... データの関連情報を導き出す

ネットショッピングでユーザの嗜好にあったものを推薦するデータの次元数を削減(dimensionality reduction) ... データの特徴を残して削減

大きな次元から特徴的なデータを特定して次元を削減し、効率的にデータを分析する何に適用できる?

- 画像解析 画像の物体を判定

- 音声解析 音声からテキストに変換、どんな音なのか判定

- テキスト解析 文章のカテゴリ分け、特定表現の抽出・構文解析

機械学習の種類

- 教師あり学習(Supervised Learning)

- データとともに正解が与えられる

- 未知のデータに対して予測を行う

- 教師なし学習(Unsupervised Learning)

- 正解は与えられていない

- 未知のデータから規則性を見出す

- 強化学習(Reinforcement Learning)

- 行動により部分的に正解が与えられる

- データから適切な買いを見つける

1-2 どのようなシナリオで機械学習を行うのか

1. ゴールの決定

2. データの収集

3. データの整形・加工

4. データを学習

1. 機械学習の手法を選択

2. パラメータの調整

3. データを学習してモデルを構築

5. モデルを評価

6. 十分な精度がでなければ4.に戻る

7. 業務で活用1-3 機械学習で利用するデータの作り方

機械学習で役に立つ汎用的なデータフォーマット

- カンマ区切りデータ CSV 形式

- ini ファイル形式

- XML

- JSON(JavaScriptのオブジェクト形式を元に考案された構造化データ)

- YAML

その他、Numpy保存形式、Pythonオブジェクトをそのまま書き込むことができる pickleなど

- 投稿日:2020-01-04T20:43:14+09:00

Pythonによる AI・機械学習について学んでいます(1)

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-1 機械学習で何ができる?

分類(classification) ... 与えられたデータを分類

データの特徴を調べて分類する回帰(regression) ... 過去の実績から未来の値を予測

過去のデータを学習して将来の数値予測を行うクラスタリング(clustering) ... データを似たものの集合に分類

分類と違うのはあらかじめ決まっている項目に分けるのではなく似たもの区分けする推薦(recommendation) ... データの関連情報を導き出す

ネットショッピングでユーザの嗜好にあったものを推薦するデータの次元数を削減(dimensionality reduction) ... データの特徴を残して削減

大きな次元から特徴的なデータを特定して次元を削減し、効率的にデータを分析する何に適用できる?

- 画像解析 画像の物体を判定

- 音声解析 音声からテキストに変換、どんな音なのか判定

- テキスト解析 文章のカテゴリ分け、特定表現の抽出・構文解析

機械学習の種類

- 教師あり学習(Supervised Learning)

- データとともに正解が与えられる

- 未知のデータに対して予測を行う

- 教師なし学習(Unsupervised Learning)

- 正解は与えられていない

- 未知のデータから規則性を見出す

- 強化学習(Reinforcement Learning)

- 行動により部分的に正解が与えられる

- データから適切な買いを見つける

1-2 どのようなシナリオで機械学習を行うのか

1. ゴールの決定

2. データの収集

3. データの整形・加工

4. データを学習

1. 機械学習の手法を選択

2. パラメータの調整

3. データを学習してモデルを構築

5. モデルを評価

6. 十分な精度がでなければ4.に戻る

7. 業務で活用1-3 機械学習で利用するデータの作り方

機械学習で役に立つ汎用的なデータフォーマット

- カンマ区切りデータ CSV 形式

- ini ファイル形式

- XML

- JSON(JavaScriptのオブジェクト形式を元に考案された構造化データ)

- YAML

その他、Numpy保存形式、Pythonオブジェクトをそのまま書き込むことができる pickleなど

- 投稿日:2020-01-04T20:43:14+09:00

Pythonによる AI・機械学習について学んだ内容

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-1 機械学習で何ができる?

分類(classification) ... 与えられたデータを分類

データの特徴を調べて分類する回帰(regression) ... 過去の実績から未来の値を予測

過去のデータを学習して将来の数値予測を行うクラスタリング(clustering) ... データを似たものの集合に分類

分類と違うのはあらかじめ決まっている項目に分けるのではなく似たもの区分けする推薦(recommendation) ... データの関連情報を導き出す

ネットショッピングでユーザの嗜好にあったものを推薦するデータの次元数を削減(dimensionality reduction) ... データの特徴を残して削減

大きな次元から特徴的なデータを特定して次元を削減し、効率的にデータを分析する何に適用できる?

- 画像解析 画像の物体を判定

- 音声解析 音声からテキストに変換、どんな音なのか判定

- テキスト解析 文章のカテゴリ分け、特定表現の抽出・構文解析

機械学習の種類

- 教師あり学習(Supervised Learning)

- データとともに正解が与えられる

- 未知のデータに対して予測を行う

- 教師なし学習(Unsupervised Learning)

- 正解は与えられていない

- 未知のデータから規則性を見出す

- 強化学習(Reinforcement Learning)

- 行動により部分的に正解が与えられる

- データから適切な買いを見つける

1-2 どのようなシナリオで機械学習を行うのか

1. ゴールの決定

2. データの収集

3. データの整形・加工

4. データを学習

1. 機械学習の手法を選択

2. パラメータの調整

3. データを学習してモデルを構築

5. モデルを評価

6. 十分な精度がでなければ4.に戻る

7. 業務で活用1-3 機械学習で利用するデータの作り方

機械学習で役に立つ汎用的なデータフォーマット

- カンマ区切りデータ CSV 形式

- ini ファイル形式

- XML

- JSON(JavaScriptのオブジェクト形式を元に考案された構造化データ)

- YAML

その他、Numpy保存形式、Pythonオブジェクトをそのまま書き込むことができる pickleなど

- 投稿日:2020-01-04T20:43:14+09:00

Pythonによる AI・機械学習について学んだ内容(1)

はじめに

この本を使って勉強しています

Pythonによる AI・機械学習・深層学習アプリのつくり方1-1 機械学習で何ができる?

分類(classification) ... 与えられたデータを分類

データの特徴を調べて分類する回帰(regression) ... 過去の実績から未来の値を予測

過去のデータを学習して将来の数値予測を行うクラスタリング(clustering) ... データを似たものの集合に分類

分類と違うのはあらかじめ決まっている項目に分けるのではなく似たもの区分けする推薦(recommendation) ... データの関連情報を導き出す

ネットショッピングでユーザの嗜好にあったものを推薦するデータの次元数を削減(dimensionality reduction) ... データの特徴を残して削減

大きな次元から特徴的なデータを特定して次元を削減し、効率的にデータを分析する何に適用できる?

- 画像解析 画像の物体を判定

- 音声解析 音声からテキストに変換、どんな音なのか判定

- テキスト解析 文章のカテゴリ分け、特定表現の抽出・構文解析

機械学習の種類

- 教師あり学習(Supervised Learning)

- データとともに正解が与えられる

- 未知のデータに対して予測を行う

- 教師なし学習(Unsupervised Learning)

- 正解は与えられていない

- 未知のデータから規則性を見出す

- 強化学習(Reinforcement Learning)

- 行動により部分的に正解が与えられる

- データから適切な買いを見つける

1-2 どのようなシナリオで機械学習を行うのか

1. ゴールの決定

2. データの収集

3. データの整形・加工

4. データを学習

1. 機械学習の手法を選択

2. パラメータの調整

3. データを学習してモデルを構築

5. モデルを評価

6. 十分な精度がでなければ4.に戻る

7. 業務で活用1-3 機械学習で利用するデータの作り方

機械学習で役に立つ汎用的なデータフォーマット

- カンマ区切りデータ CSV 形式

- ini ファイル形式

- XML

- JSON(JavaScriptのオブジェクト形式を元に考案された構造化データ)

- YAML

その他、Numpy保存形式、Pythonオブジェクトをそのまま書き込むことができる pickleなど

- 投稿日:2020-01-04T20:19:05+09:00

Python基本文法メモ

コメント

- コメントは

#。 3重のクォーテーションで、複数行コメントとして使える。print関数

- 改行しないようにする

print(引数1, 引数2, ... , end="")変数

- 変数名は、

sample_colorのように、_で区切るのが一般的。- 代入演算子は、

+= -= *= /=が使える。++ --は使えない。- キーボードから入力するには、

str = input("入力してください:")のようにして、文字列型が返却される。float("160.5")で文字列型をfloat型に変換できる。- Pythonの数値型は、整数型(int)、浮動小数点型(float)、複素数型(complex)の3種類。

type()関数で、型を調べられる。- リテラル、

5はint、5.0はfloat、0xff = 255は16進数、0o23 = 19は8進数、0b1111 = 15は2進数。- 指数表現

9.5e3 = 9.5 * 10^3- 文字列型は、シングルクォーテーションかダブルクォーテーションで囲む。

\でエスケープ。- 複数の行の文字列を記述するには、3重クオーテーションで囲む。

int("5")で文字型から整数型に変換。int("FFF",16)で16進数を整数型に変換。str(数値)で数値型から文字型に変換する。hex()oct()bin()を使うと、それぞれ16進数、8進数、2進数の文字型に変換する。id(オブジェクト)でオブジェクトのid番号を調べられる。シーケンス型

height = [180, 165, 159, 171, 155]のようにしてリスト型を作成する。height[0]のようにして、リスト型の中身を取り出す。height[1] = 182のようにして、中身を変更できる。height[-1]で一番右の値を取り出す。len(height)でリストの長さを返す。height_tuple = (180, 165, 159, 171, 155)のようにしてタプル型を作成する。タプルは値が変更不可なリスト。()は省略可。値の取り出し方はリストと同じ。list()tuple()で相互変換可能。- リスト、タプル、文字列型(str)は、シーケンス型で、インデックスで取り出し可能。

import

import モジュール名でモジュールのインポートをする。モジュール名.コンストラクタを呼び出すことにより、クラスのインスタンスを作成する。インスタンス変数.メソッド名(引数, ...)でメソッドを呼び出す。import calendar cal = calendar.TextCalendar() cal.prmonth(2016, 1)

from モジュール名 import クラス名1, クラス名2, ...と指定すれば、クラスを呼ぶ時のモジュール名を省略できる。from calendar import TextCalendar cal = TextCalendar() cal.prmonth(2016, 1)

- 関数のモジュールをインポートする(クラスのインポートと同じ)

import モジュール名の時、モジュール名.関数名で関数を呼び出せる。from モジュール名 import 関数名1, 関数名2, ...の時は、関数名を直接呼び出せる。from モジュール名 import *で全ての関数を読み込む。乱数の利用

import randomrandint(0,3)で、0以上3以下の整数の乱数を生成する。randrange(3)で。0以上3未満の整数の乱数を生成する。if文

if 条件式A: 処理1 elif 条件式B: 処理2 else: 処理3

- 論理演算子は、

andorを使う。- 条件式は、

3 <= month < 5のように書ける。- リストやタプルは、

inで含まれるかを判定できる3 in [1, 2, 3, 4]not inで含まれないかを判定できる3 not in [1, 2, 3, 4]innot inは文字列にも使える"日" in "月火水木金土日"- Pythonには、switch文はない。

- 以下のように3項演算子を使える。

値1 if 条件式 else 値2 msg = "こんにちは" if hour < 18 else "こんばんは"ループ処理

- Pythonに、do〜whileループはない

- range([開始,] 終了[, ステップ])

# for文 for l in list: 処理 # 10回繰り返す(i=1〜9) for i in range(10): 処理 # rangeオブジェクトをリストに変換 l = list(range(0, 31, 10)) # i=[0, 10, 20, 30] # while while 条件式: 処理

- enumerate()関数を使うと、インデックスと要素のペアが取り出せる。

countries = ["フランス", "アメリカ", "中国" , "ドイツ" , "日本"] for index, country in enumerate(countries): print(str(index + 1) + ":", country)

- zip(リスト1, リスト2, ...)関数を使うと、複数のリストの値を、一番短いリストの要素がなくなるまで、タプルとして順に取り出せる。